AI做数学学会动脑子! UCL等发现LLM程序性知识,推理绝不是背答案

在人工智能领域,大型语言模型(LLM)的崛起引发了广泛的关注。这些模型在处理自然语言任务时展现出了惊人的能力,但它们在数学推理方面的表现却一直备受争议。一方面,LLM在解决数学问题时表现出了一定的能力;另一方面,它们在推理过程中的不稳定性也引发了人们对其可靠性的质疑。 然而,来自伦敦大...

管理AI推理模型,创建AI推理模型

在Elasticsearch(简称ES)实例中使用AI推理模型之前,您需要开通AI搜索开放平台并创建AI模型。您可以参考本文进行相关操作。

基于ACK多机分布式部署DeepSeek满血版推理部署实战

本文深入解析基于阿里云容器服务ACK的DeepSeek-R1-671B大模型分布式推理实战方案。针对该千亿参数模型(671B)单卡显存不足的挑战,提出混合并行策略(Pipeline Parallelism=2 + Tensor Parallelism=8),结合阿里云Arena工具,实现在2台ecs.ebmgn8v.48xlarge(8*96GB)节点上的高效分布式部署。进一步演示如何将部署于AC...

基于英特尔平台加速 AI 应用及 LLM 推理性能介绍|龙蜥大讲堂第115期

基于英特尔平台加速 AI 应用及 LLM 推理性能介绍|龙蜥大讲堂第115期 内容介绍 1. 第五代英特尔至强处理器 2. LLM 推理加速框架 xFast Transformer 及其优化策略 3. 性能数据及 Demo 展示 ...

AI模型推理服务在Knative中最佳配置实践

Knative和AI结合提供了快速部署、高弹性和低成本的技术优势,适用于需要频繁调整计算资源的AI应用场景,例如模型推理等。您可以通过Knative Pod部署AI模型推理任务,配置自动扩缩容、灵活分配GPU资源等功能,提高AI推理服务能力和GPU资源利用率。

云原生 AI 工程化实践之 FasterTransformer 加速 LLM 推理(2)

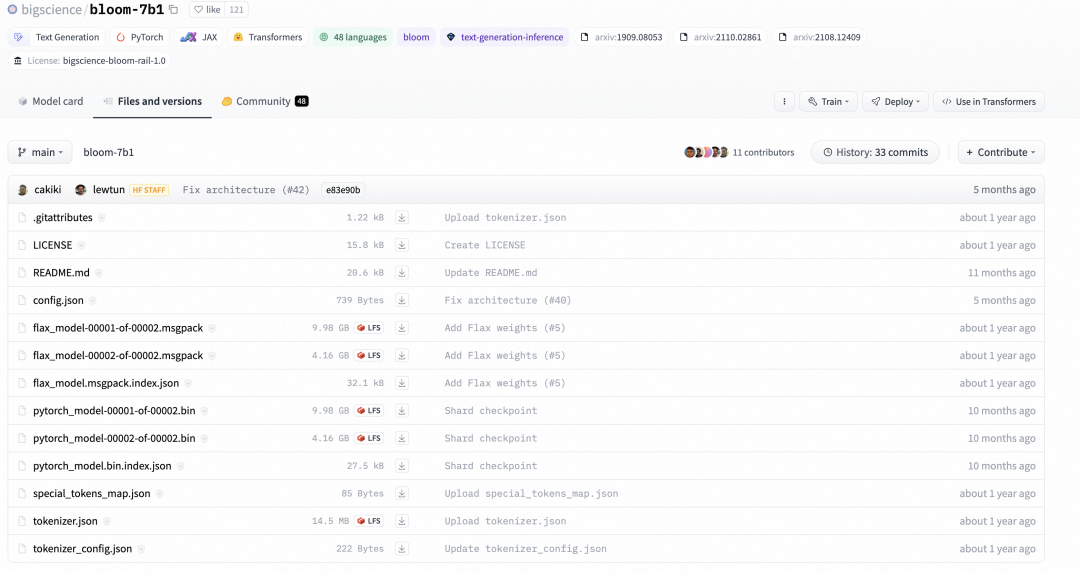

04 性能对比此时,我们的 OSS 上已经有两份 bloom-7b1 checkpoint,一份是 bloom-7b 文件夹存储了 huggingface 原生的 checkpoint,另一份是 bloom-7b-ft-fp16 文件夹存储了转换后的 FasterTransformer 的 checkpoint。我们将使用这两份 checkpoint 进行性能对比,看一下来 FasterTran....

云原生 AI 工程化实践之 FasterTransformer 加速 LLM 推理(1)

01 背景OpenAI 在 3 月 15 日发布了备受瞩目的 GPT4,它在司法考试和程序编程领域的惊人表现让大家对大语言模型的热情达到了顶点。人们纷纷议论我们是否已经跨入通用人工智能的时代。与此同时,基于大语言模型的应用也如雨后春笋般出现,为我们带来了协同办公、客服对话、语言翻译、内容生成等方面前所未有的畅快体验。然而,当我们享受着大语言模型带来的普惠 AI 能力时,它也给开发者们带来了前所未....

云原生 AI 工程化实践之 FasterTransformer 加速 LLM 推理

作者:颜廷帅(瀚廷)01 背景OpenAI 在 3 月 15 日发布了备受瞩目的 GPT4,它在司法考试和程序编程领域的惊人表现让大家对大语言模型的热情达到了顶点。人们纷纷议论我们是否已经跨入通用人工智能的时代。与此同时,基于大语言模型的应用也如雨后春笋般出现,为我们带来了协同办公、客服对话、语言翻译、内容生成等方面前所未有的畅快体验。然而,当我们享受着大语言模型带来的普惠 AI 能力时,它也给....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

产品推荐

人工智能平台PAI

人工智能平台 PAI(Platform for AI,原机器学习平台PAI)是面向开发者和企业的机器学习/深度学习工程平台,提供包含数据标注、模型构建、模型训练、模型部署、推理优化在内的AI开发全链路服务,内置140+种优化算法,具备丰富的行业场景插件,为用户提供低门槛、高性能的云原生AI工程化能力。

+关注