微调DeepSeek-R1

DeepSeek-R1是由深度求索公司推出的首款推理模型,该模型在数学、代码和推理任务上的表现优异。深度求索不仅开源了DeepSeek-R1模型,还发布了从DeepSeek-R1基于Llama和Qwen蒸馏而来的六个密集模型,在各项基准测试中均表现出色。本文以蒸馏模型DeepSeek-R1-Distill-Qwen-7B为例,为您介绍如何微调该系列模型。

使用GA实现PAI-DSW跨域加速拉取海外模型或容器镜像

当您使用海外容器镜像(如:docker.io镜像)创建交互式建模 PAI-DSW实例,或者在PAI-DSW实例中拉取海外模型时(如:huggingface.co模型),可能由于网络跨域的原因无法正常访问,为解决此问题,您可以创建全球加速GA(Global Accelerator)实例,使用其提供的覆盖全球的网络加速服务,使PAI-DSW具备跨域获取模型和镜像的网络访问能力。

DSW跨域拉取海外模型或容器镜像

当您使用海外容器镜像(如:docker.io镜像)创建DSW实例,或者在DSW实例中拉取海外模型时(如:huggingface.co模型),可能由于网络跨域的原因无法正常访问,为解决此问题,您可以创建全球加速GA(Global Accelerator)实例,使用其提供的覆盖全球的网络加速服务,使DSW具备跨域获取模型和镜像的网络访问能力。

部署DeepSeek-V3、DeepSeek-R1模型

DeepSeek-V3是由深度求索公司推出的一款拥有6710亿参数的专家混合(MoE)大语言模型,DeepSeek-R1是基于DeepSeek-V3-Base训练的高性能推理模型。Model Gallery提供了标准部署和多种加速部署方式,帮助您一键部署DeepSeek-V3和DeepSeek-R1...

云上一键部署通义千问 QwQ-32B 模型,阿里云 PAI 最佳实践

QwQ-32B 模型简介 3月6日,阿里云发布并开源了全新的推理模型通义千问QwQ-32B。通过大规模强化学习,千问QWQ-32B在数学、代码及通用能力上实现质的飞跃,整体性能比肩Deepseek-R1。在保持强劲性能的同时,千问QwQ-32B还大幅降低了部署使用成本。 在一系列权威基准测试中,千问QwQ-32B模型表现异常出色,几乎完全超越了OpenAI-o1-mini,比肩最...

云上一键部署 DeepSeek-V3 模型,阿里云 PAI-Model Gallery 最佳实践

1. DeepSeek-V3 模型简介 DeepSeek-V3 是 DeepSeek 发布的 MoE(Mixture-of-Experts)大语言模型,总参数量为6710亿,每个 token 激活的参数量为370亿。为了实现高效的推理和成本效益的训练,DeepSeek-V3 采用了 MLA(Multi-head ...

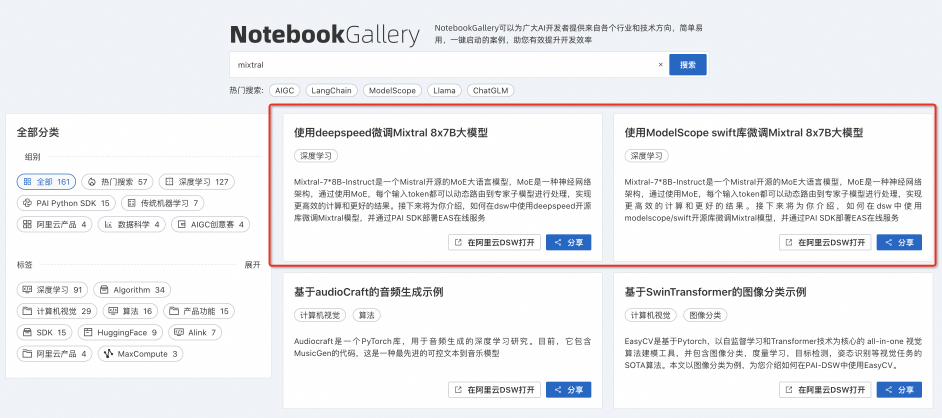

Mixtral 8X7B MoE模型在阿里云PAI平台的微调部署实践

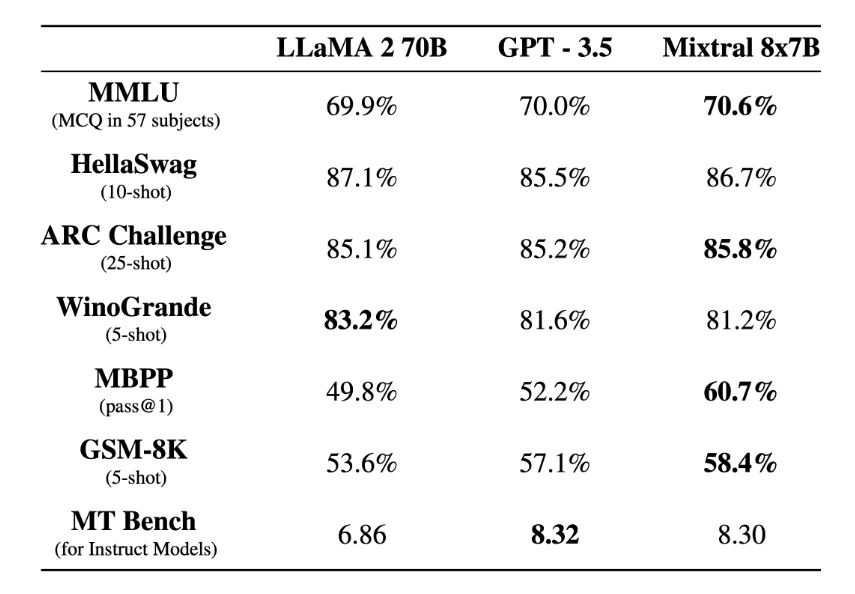

1.引言Mixtral 8x7B 是Mixtral AI最新发布的大语言模型,在许多基准测试上表现优于 GPT-3.5,是当前最为先进的开源大语言模型之一。阿里云人工智能平台PAI是面向开发者和企业的机器学习/深度学习平台,提供了对于 Mixtral 8x7B 模型的全面支持,开发者和企业用户可以基于 PAI-快速开始(PAI-QuickStart)轻松完成Mixtral 8x7B 模型的微调和....

Mixtral 8X7B MoE模型基于阿里云人工智能平台PAI实践合集

1.背景Mixtral 8x7B大模型是Mixtral AI推出的基于decoder-only架构的稀疏专家混合网络(Mixture-Of-Experts,MOE)开源大语言模型。这一模型具有46.7B的总参数量,对于每个token,路由器网络选择八组专家网络中的两组进行处理,并且将其输出累加组合,在增加模型参数总量的同时,优化了模型推理的成本。在大多数基准测试中,Mixtral 8x7B模型与....

社区供稿 | 通义千问开源模型在阿里云PAI灵骏的最佳实践

引言12月1日,通义千问再次宣布重磅开源,目前通义千问已推出1.8B、7B、14B、72B 四款不同尺寸的开源大语言模型。阿里云PAI灵骏智算服务,是面向大规模深度学习场景的智算产品,一站式提供异构算力底座及AI工程平台。本实践将展示如何基于阿里云PAI灵骏智算服务,进行通义千问的高效分布式预训练、指令微调、模型离线推理验证以及在线服务部署。本文将以Qwen-7B为例展示基于Megatron-L....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

人工智能平台 PAI模型相关内容

- 模型人工智能平台 PAI实践

- 模型人工智能平台 PAI部署实践

- 模型人工智能平台 PAI部署

- 模型人工智能平台 PAI

- 人工智能平台 PAI数据模型

- 通义千问模型人工智能平台 PAI

- 云上模型人工智能平台 PAI最佳实践

- 模型人工智能平台 PAI最佳实践

- 模型阿里云人工智能平台 PAI最佳实践

- 部署模型人工智能平台 PAI

- 人工智能平台 PAI model模型

- 人工智能平台 PAI部署模型

- 人工智能平台 PAI产品训练模型

- 人工智能平台 PAI模型任务

- 人工智能平台 PAI训练模型

- fastapi部署人工智能平台 PAI模型

- 部署人工智能平台 PAI模型

- 人工智能平台 PAI模型最佳实践

- 特征人工智能平台 PAI模型

- 人工智能平台 PAI模型方法

- 人工智能平台 PAI模型性能策略

- 人工智能平台 PAI优化模型

- 人工智能平台 PAI factory微调模型

- 人工智能平台 PAI模型工具

- 人工智能平台 PAI模型技术

- 人工智能平台 PAI模型搜索

- 人工智能平台 PAI easyrec模型

- 人工智能平台 PAI模型指标

- 人工智能平台 PAI模型性能指标

- 人工智能平台 PAI深度学习模型

人工智能平台 PAI更多模型相关

- 人工智能平台 PAI模型优化

- 实践人工智能平台 PAI模型

- 人工智能平台 PAI评估模型

- 人工智能平台 PAI模型roc

- 人工智能平台 PAI评估模型指标

- 人工智能平台 PAI模型性能roc

- 人工智能平台 PAI评估模型性能

- 人工智能平台 PAI模型原理

- 人工智能平台 PAI模型应用

- 深度学习人工智能平台 PAI模型

- 人工智能平台 PAI模型部署

- 构建人工智能平台 PAI模型数据预处理优化

- 阿里云人工智能平台 PAI模型

- 人工智能平台 PAI构建模型

- 人工智能平台 PAI模型文件

- 人工智能平台 PAI特征模型

- 人工智能平台 PAI eas模型

- 人工智能平台 PAI模型分析

- 人工智能平台 PAI加载模型

- 人工智能平台 PAI模型报错

- 人工智能平台 PAI dssm模型

- 人工智能平台 PAI导出模型

- 人工智能平台 PAI模型融合

- 人工智能平台 PAI alink模型

- scikit-learn人工智能平台 PAI模型

- 构建人工智能平台 PAI模型调优

- ml人工智能平台 PAI模型

- 人工智能平台 PAI模型可视化

- 人工智能平台 PAI python模型

- 构建人工智能平台 PAI模型技术

人工智能平台 PAI您可能感兴趣

- 人工智能平台 PAI迁移

- 人工智能平台 PAI comfyui

- 人工智能平台 PAI产品

- 人工智能平台 PAI ai

- 人工智能平台 PAI大语言模型

- 人工智能平台 PAI裁判员

- 人工智能平台 PAI简介

- 人工智能平台 PAI技术

- 人工智能平台 PAI实践

- 人工智能平台 PAI解析

- 人工智能平台 PAI pai

- 人工智能平台 PAI机器学习

- 人工智能平台 PAI算法

- 人工智能平台 PAI python

- 人工智能平台 PAI应用

- 人工智能平台 PAI数据

- 人工智能平台 PAI人工智能

- 人工智能平台 PAI平台

- 人工智能平台 PAI训练

- 人工智能平台 PAI实战

- 人工智能平台 PAI构建

- 人工智能平台 PAI入门

- 人工智能平台 PAI深度学习

- 人工智能平台 PAI优化

- 人工智能平台 PAI方法

- 人工智能平台 PAI特征

- 人工智能平台 PAI阿里云

- 人工智能平台 PAI部署

- 人工智能平台 PAI代码

- 人工智能平台 PAI分类

人工智能平台PAI

人工智能平台 PAI(Platform for AI,原机器学习平台PAI)是面向开发者和企业的机器学习/深度学习工程平台,提供包含数据标注、模型构建、模型训练、模型部署、推理优化在内的AI开发全链路服务,内置140+种优化算法,具备丰富的行业场景插件,为用户提供低门槛、高性能的云原生AI工程化能力。

+关注