如何使用Rapidformer优化PyTorch版的Transformer模型训练

PAI-Rapidformer提供了丰富的模型训练加速方法,您只需要安装Rapidformer专属镜像,即可通过黑盒或者白盒化的方式对模型训练进行优化。本文为您介绍如何使用Rapidformer优化PyTorch版的Transformer模型训练。

使用PyTorch实现GPT-2直接偏好优化训练:DPO方法改进及其与监督微调的效果对比

基于人类反馈的强化学习(RLHF)已成为大型语言模型(LLM)训练流程中的关键环节,并持续获得研究界的广泛关注。 本文将探讨RLHF技术,特别聚焦于直接偏好优化(Direct Preference Optimization, DPO)方法,并详细阐述了一项实验研究:通过DPO对GPT-2 124M模型进行调优,同时与传统监督微调(Supervised Fine-tuning, SFT)方法进行对....

使用Pai-Megatron-Patch优化PyTorch版Transformer模型训练

本文介绍如何使用Pai-Megatron-Patch优化PyTorch版Transformer模型训练。

【Pytorch神经网络理论篇】 15 过拟合问题的优化技巧(二):Dropout()方法

同学你好!本文章于2021年末编写,获得广泛的好评!故在2022年末对本系列进行填充与更新,欢迎大家订阅最新的专栏,获取基于Pytorch1.10版本的理论代码(2023版)实现,Pytorch深度学习·理论篇(2023版)目录地址为:CSDN独家 | 全网首发 | Pytorch深度学习·理论篇(2023版)目录本专栏将通过系统的深度学习实例,从可解释性的角度对深度学习的原理进行讲解与分析,通....

PyTorch | 优化神经网络训练的17种方法

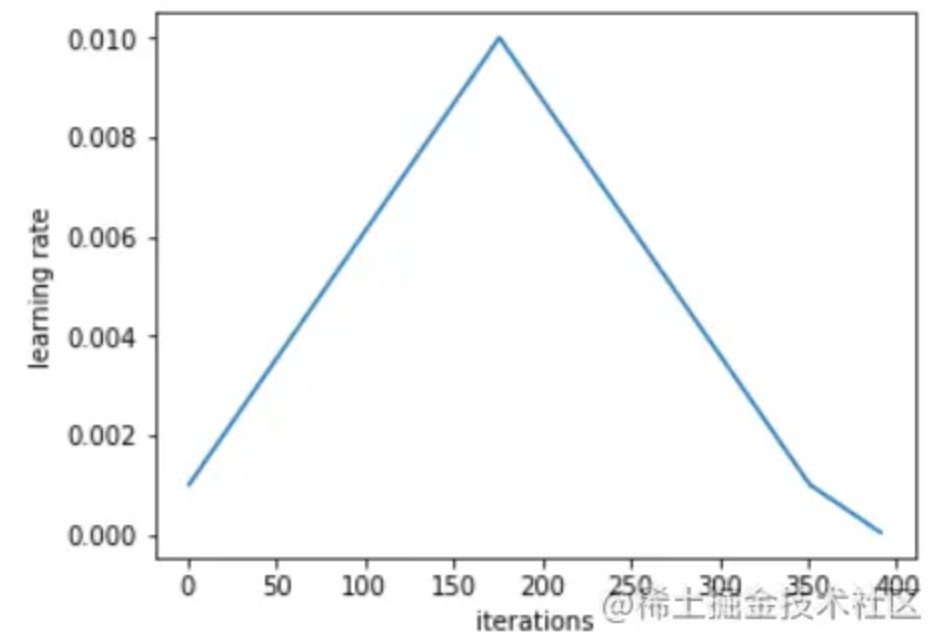

01 考虑换一种学习率 schedule学习率 schedule 的选择对模型的收敛速度和泛化能力有很大的影响。Leslie N. Smith 等人在论文《Cyclical Learning Rates for Training Neural Networks》、《Super-Convergence: Very Fast Training of Neural Networks Using Lar....

如何使用AICompiler对TensorFlow和PyTorch模型进行编译优化

AICompiler是集成在PAI-Blade中的AI编译优化组件,包含Static Shape和Dynamic Shape编译框架。通常您无需提供额外配置,AICompiler即可在通用透明的情况下帮助您提高推理性能。本文介绍如何使用AICompiler对TensorFlow和PyTorch模型进行编译优化。

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

pytorch您可能感兴趣

- pytorch l2

- pytorch代码

- pytorch解析

- pytorch技术

- pytorch图像

- pytorch gat

- pytorch昇腾

- pytorch gemotric

- pytorch vggnet

- pytorch interest

- pytorch模型

- pytorch神经网络

- pytorch教程

- pytorch实战

- pytorch训练

- pytorch学习

- pytorch数据集

- pytorch tensorflow

- pytorch官方教程

- pytorch安装

- pytorch卷积

- pytorch构建

- pytorch gpu

- pytorch卷积神经网络

- pytorch分类

- pytorch数据

- pytorch源码

- pytorch框架

- pytorch案例

- pytorch学习笔记