基于ACK多机分布式部署DeepSeek满血版推理部署实战

本文深入解析基于阿里云容器服务ACK的DeepSeek-R1-671B大模型分布式推理实战方案。针对该千亿参数模型(671B)单卡显存不足的挑战,提出混合并行策略(Pipeline Parallelism=2 + Tensor Parallelism=8),结合阿里云Arena工具,实现在2台ecs.ebmgn8v.48xlarge(8*96GB)节点上的高效分布式部署。进一步演示如何将部署于AC...

模型部署

您可以将AI搜索开放平台中的模型独立部署,提供更高并发、更低延迟的推理服务。计费规则计费公式为:CU单价*机型消耗的CU数量*购买机器个数例如某用户购买2台gpu.a10.24g.x1部署模型服务,计费=1.07*11.01*2=23.56元/小时。机型CU单价单台机器消耗CU数量gpu.v100....

【AI系统】训练后量化与部署

本文将会重点介绍训练后量化技术的两种方式:动态和静态方法,将模型权重和激活从浮点数转换为整数,以减少模型大小和加速推理。并以 KL 散度作为例子讲解校准方法和量化粒度控制来平衡模型精度和性能。 训练后量化的方式 训练后量化的方式主要分为动态和静态两种。 动态离线量化 动态离线量化(Post Training Quantization Dynamic, PTQ Dynamic)仅将模型中特定算子的....

AI模型推理服务在Knative中最佳配置实践

Knative和AI结合提供了快速部署、高弹性和低成本的技术优势,适用于需要频繁调整计算资源的AI应用场景,例如模型推理等。您可以通过Knative Pod部署AI模型推理任务,配置自动扩缩容、灵活分配GPU资源等功能,提高AI推理服务能力和GPU资源利用率。

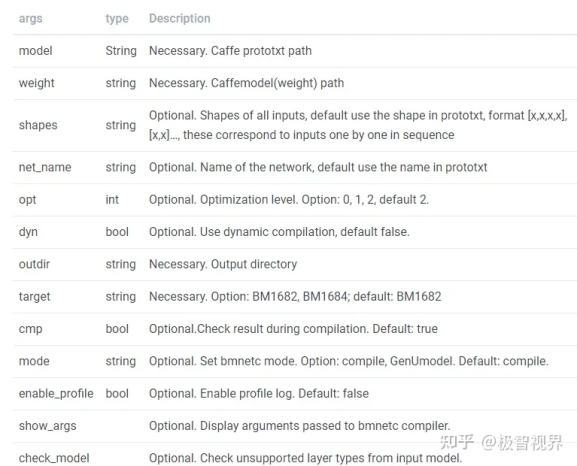

极智AI | 比特大陆SE5边缘盒子caffe SSD量化与转换部署模型

本教程详细记录了在比特大陆 SE5 边缘盒子上对 caffe SSD 检测模型进行量化和转换部署模型的方法。首先介绍一下 BMNETC 转换工具,在比特大陆的 SDK 中,BMNETC 是针对 caffe 的模型编译器,可将模型的 caffemodel 和 prototxt 编译成 BMRuntime 执行所需的 bmodel。BMNETC 工具的传参如下:/path/to/bmnetc [--....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

AI更多部署相关

- AI方案部署

- AI数字人部署

- 部署AI视频生成

- aigc部署AI

- AI环境部署

- 神龙AI部署

- serverless部署AI

- fc部署AI

- 部署AI图像

- 部署AI实验

- 部署stablediffusion AI

- AI工程化部署

- AI ecs部署

- AI部署stable diffusion

- AI助理部署

- AI部署stable

- AI本地化部署

- 部署diffusion AI

- c++ AI工程化部署

- AI云端部署

- 极智AI部署

- pai-eas部署AI

- AI部署gpu

- fc AI部署

- 部署AI绘画

- AI函数计算部署stable

- AI容器镜像部署

- AI部署安装

- 函数计算部署stable AI

- c语言AI工程化部署

产品推荐

人工智能平台PAI

人工智能平台 PAI(Platform for AI,原机器学习平台PAI)是面向开发者和企业的机器学习/深度学习工程平台,提供包含数据标注、模型构建、模型训练、模型部署、推理优化在内的AI开发全链路服务,内置140+种优化算法,具备丰富的行业场景插件,为用户提供低门槛、高性能的云原生AI工程化能力。

+关注