深度学习笔记(九):神经网络剪枝(Neural Network Pruning)详细介绍

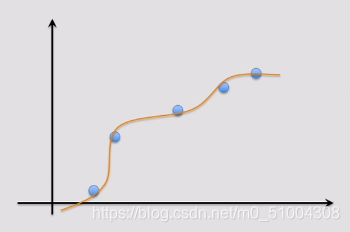

1:What is pruning 剪枝是一种模型压缩的方法,这种方法可以有效的裁剪模型参数且最小化精度的损失。由于深度学习模型可以看作是一个复杂树状结构,如果能减去一些对结果没什么影响的旁枝,也就是修剪神经网络中不重要的权重,就可以实现模型的减小。比如说看下图 我们通过观察这个函数发现有些项对应的系数是很小的,也就是说对于拟合的贡献不是很大,如果我们把系数小的去掉得到-1.2x^2-2x-...

深度学习笔记(七):如何用Mxnet来将神经网络可视化

一:环境依赖 我自己的环境在这篇博客上https://developer.aliyun.com/article/1624222下面是我为了实现可视化需要安装新的环境依赖包 step1:pip install mxnet-cu100 -i https://pypi.douban.com/simple step2:pip install graphviz==0.8.4并把F:\Anaconda...

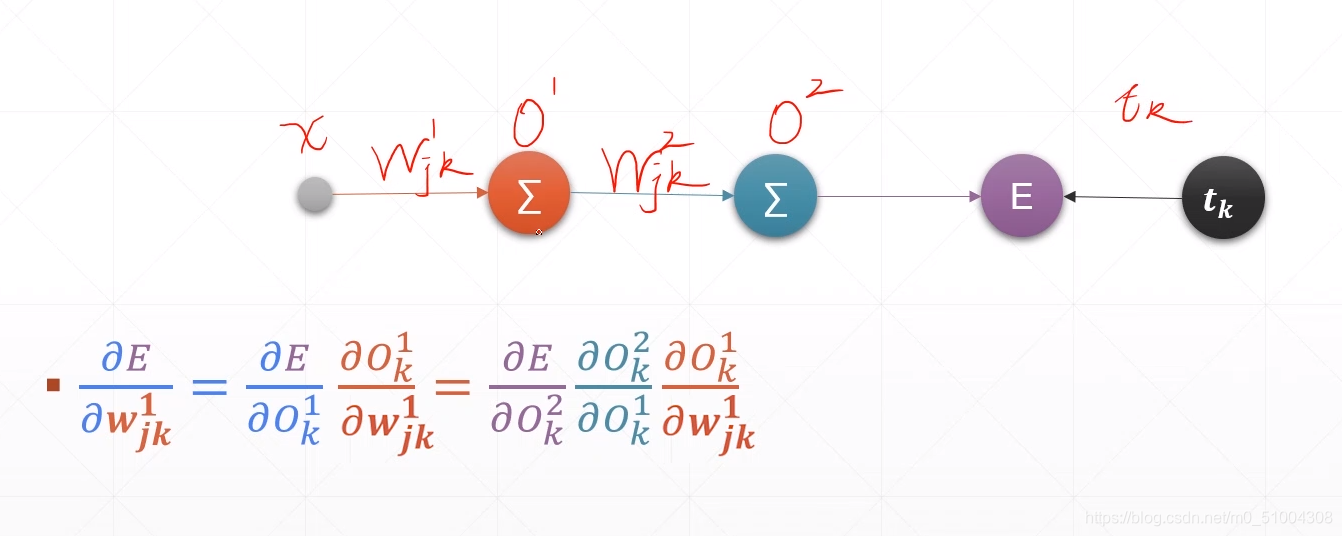

深度学习笔记(四):神经网络之链式法则详解

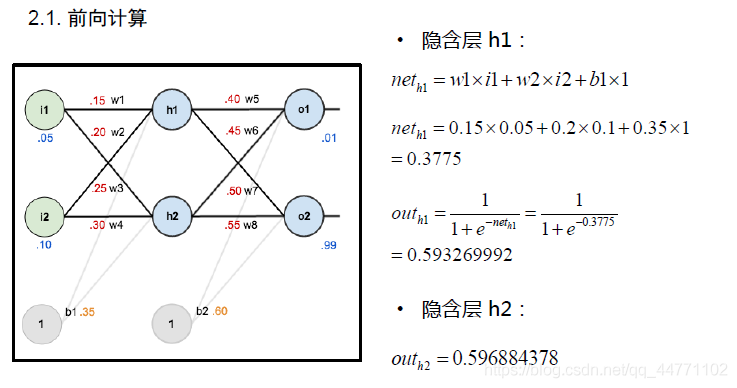

简单的说链式法则就是原本y对x求偏导,但是由于过程较为复杂,我们引入了一个中间层z,先利用y对z求偏导,在乘上z对x求偏导,这样会使整个计算更为简单。 作用:通过链式法则我们就可以把最后一层的误差,一层一层的输出到中间层上面去,从而得到中间层的梯度信息,通过梯度信息我们就能很好的更新权值,从而达到更好的优化效果。 从上面可以知道E为最右边,当E对w1做偏微分,可以更新w1;同理E对w2做偏微分,....

深度学习笔记(三):神经网络之九种激活函数Sigmoid、tanh、ReLU、ReLU6、Leaky Relu、ELU、Swish、Mish、Softmax详解

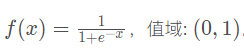

1.什么叫激活函数 激活函数可作用于感知机(wx+b)累加的总和 ,所谓的激活就是把输出值必须要大于,节点才可以被激活,不然就处于睡眠状态。 2.激活函数的作用 提供网络的非线性建模能力。如果没有激活函数,那么该网络仅能够表达线性映射,此时即便有再多的隐藏层,其整个网络跟单层神经网络也是等价的。因此也可以认为,只有加入了激活函数之后,深度神经网络才具备了分层的非线性映射学习能力。由于输出值是有限....

深度学习笔记(一): 神经网络之感知机详解

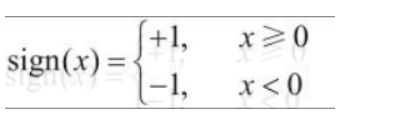

在这篇文章我们主要了解感知机定义、功能、模型如何去获得损失函数、以及有哪些方法去将损失函数极小化,从而确定模型参数 感知机模型的定义: 输入空间由xi(xi(1),xi(2),xi(3)…xi(n))组成,输出空间为{-1, +1},由输入空间到输出空间的映射函数为 f(x)=sign(w·x+b) 称为感知机。其中w是权重向量,b称为偏置,w·x为w和x的内积。sign(x)是符号函数,即:0....

深度学习入门笔记4 深度神经网络

多层感知器在之前的课程中,我们了解到,感知器(指单层感知器)具有一定的局限——无法解决异或问题,即线性不可分的问题。将多个单层感知器进行组合,就可以得到一个多层感知器(MLP——Multi-Layer Perceptron)结构。 多层感知器包含输入层,一个或多个隐藏层以及一个输出层。每层的神经元与下一层进行完全连接。如果网络中包含一个以上的隐层,则称其为深度人工神经网络。说明:通常我们说的神经....

【吴恩达深度学习笔记-改善深层神经网络】——第一周深度学习的实用层面(1.4)

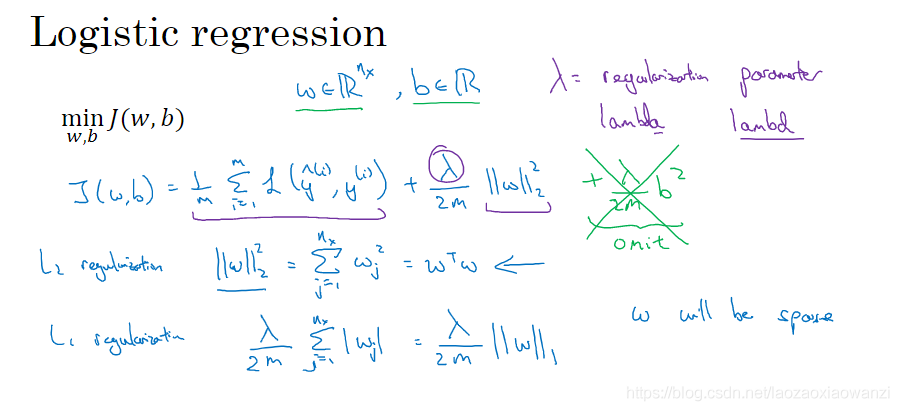

1.4 正则化正则化用来解决神经网络过度拟合数据(即高方差)的问题,正则化的作用原理:1.在逻辑回归中的正则化用逻辑回归来实现,求成本函数的最小值,成本函数中的参数包括一些训练数据和不同数据中个体预测的损失,w和b是逻辑回归的两个参数,其中w是一个多维度的参数矢量,b是一个实数,在逻辑回归中添加正则化就是加入一个参数入(正则化参数),w欧几里得范数的平方等于wj(j从1到nx)平方的和,此方法称....

【吴恩达深度学习笔记-改善深层神经网络】——第一周深度学习的实用层面(1.3)

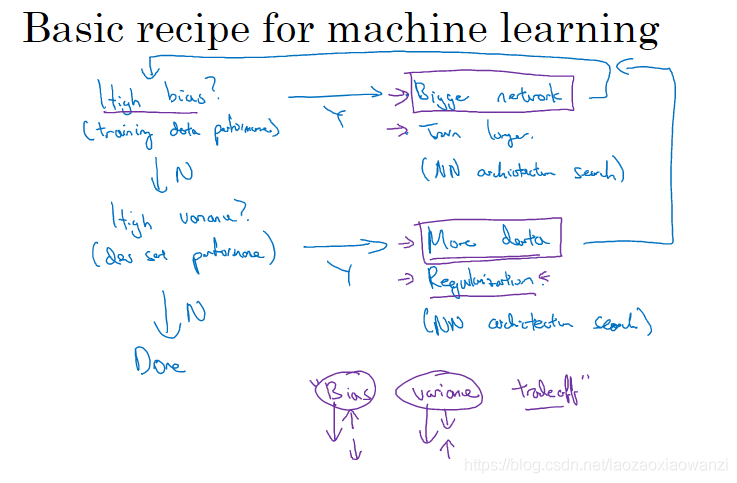

【吴恩达深度学习笔记-改善深层神经网络】——第一周深度学习的实用层面(1.3)1.3机器学习基础训练神经网络的基本方法:初识模型训练完成后,要看下算法的偏差高不高,如果较高,就试着评估训练集或训练数据的性能,如果的确很高,甚至无法拟合训练集,那就选择一个新的网络(含有更多隐藏层或隐藏单元的神经网络),或者花费更多的时间来训练网络,训练算法,尝试更先进的优化算法。采用新的网络架构,采用更大规模的神....

【吴恩达深度学习笔记-改善深层神经网络】——第一周深度学习的实用层面(1.2)

【吴恩达深度学习笔记-改善深层神经网络】——第一周深度学习的实用层面(1.2)1.2 偏差/方差假设图中的ooxx代表数据集,现用一条直线去拟合左图的数据,可能会得到一个逻辑回归拟合,但是可以看到这条直线并不能很好的拟合数据,这种就属于高偏差情况,通常称为欠拟合。而对于一个非常复杂的分类器,比如深度神经网络或者含有隐藏单元的神经网络,就适用于右边的数据集,但也不是一个合适的拟合方式,这种属于分类....

【吴恩达深度学习笔记-改善深层神经网络】——第一周深度学习的实用层面(1.1)

【吴恩达深度学习笔记-改善深层神经网络】——第一周深度学习的实用层面(1.1)1.1训练/开发/测试集如果想要构建一个高效的神经网络,那么配置训练、验证、测试集就要好好斟酌了。在创建神经网络时,要做一些决策,包括网络有几层,每层有几个隐藏单元,学习率,各层用到的激活函数等。但在实际应用中,我们不可能一开始就能够准确的预测出这些超参数的值,因而,可以说,应用型机器学习是一个高度迭代的过程。如果想要....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

深度学习神经网络相关内容

- 深度学习神经网络tensorflow

- 深度学习神经网络cnn

- 卷积神经网络深度学习

- 神经网络深度学习

- 深度学习构建神经网络

- 深度学习入门神经网络

- 深度学习神经网络优化

- 深度学习神经网络结构

- 深度学习神经网络应用

- 深度学习神经网络实践

- 深度学习神经网络图像

- 深度学习神经网络原理实践

- 深度学习神经网络原理

- 深度学习cnn神经网络

- 深度学习神经网络neural

- 深度学习神经网络可视化

- 深度学习神经网络softmax

- 深度学习入门神经网络rnn

- 深度学习神经网络概述

- 深度学习神经网络循环

- 深度学习神经网络案例

- 深度学习卷积神经网络图像

- 深度学习神经网络池化层

- 深度学习神经网络价格

- 深度学习神经网络分类

- 深度学习卷积神经网络cnn入门

- 深度学习入门神经网络反向传播

- 深度学习神经网络感知器

- 深度学习入门神经网络cnn

- ai深度学习神经网络

深度学习更多神经网络相关

- 深度学习浪潮神经网络

- 深度学习构建训练神经网络

- 深度学习训练神经网络

- 深度学习神经网络数据集

- 深度学习入门构建神经网络

- 深度学习tensorflow神经网络

- 深度学习卷积神经网络cnn原理

- 深度学习神经网络简介

- 深度学习神经网络构建

- 入门深度学习神经网络

- 深度学习卷积神经网络代码

- 深度学习教程神经网络

- 人工智能深度学习神经网络融合

- 深度学习lstm神经网络

- deeplearning.ai深度学习神经网络

- 深度学习rnn神经网络

- 深度学习cv神经网络

- 深度学习卷积神经网络训练

- 深度学习技术神经网络

- keras深度学习神经网络

- 深度学习神经网络研究

- 深度学习线性神经网络

- 学习笔记深层神经网络深度学习

- 深度学习代码神经网络

- 学习笔记神经网络深度学习

- 深度学习计算神经网络

- 深度学习神经网络序列数据

- 深度学习卷积神经网络分类

- 深度学习神经网络实战源码

- 深度学习神经网络卷积神经网络

智能引擎技术

AI Online Serving,阿里巴巴集团搜推广算法与工程技术的大本营,大数据深度学习时代的创新主场。

+关注