如何配置API数据服务

DataWorks的数据服务模块,提供了通过API消费数据的服务,可以为使用API接收数据的业务提供数据。本文将以场景示例形式,为您介绍如何用DataWorks完成API服务对数据的消费。

如何配置API数据服务

DataWorks的数据服务模块,提供了通过API消费数据的服务,可以为使用API接收数据的业务提供数据。本文将以场景示例形式,为您介绍如何用DataWorks完成API服务对数据的消费。

如何配置API数据服务

DataWorks的数据服务模块,提供了通过API消费数据的服务,可以为使用API接收数据的业务提供数据。本文将以场景示例形式,为您介绍如何用DataWorks完成API服务对数据的消费。

HBase在线迁移数据

本方案通过结合HBase Snapshot和HBase Replication技术,在源端HBase集群不停服的情况下,实现存量数据和增量数据的在线迁移,确保迁移过程中数据无丢失。

大数据-159 Apache Kylin 构建Cube 准备和测试数据(一)

点一下关注吧!!!非常感谢!!持续更新!!! 目前已经更新到了: Hadoop(已更完) HDFS(已更完) MapReduce(已更完) Hive(已更完) Flume(已更完) Sqoop(已更完) Zookeeper(已更完) HBase(已更完) Redis (已更完) Kafka(已更完) ...

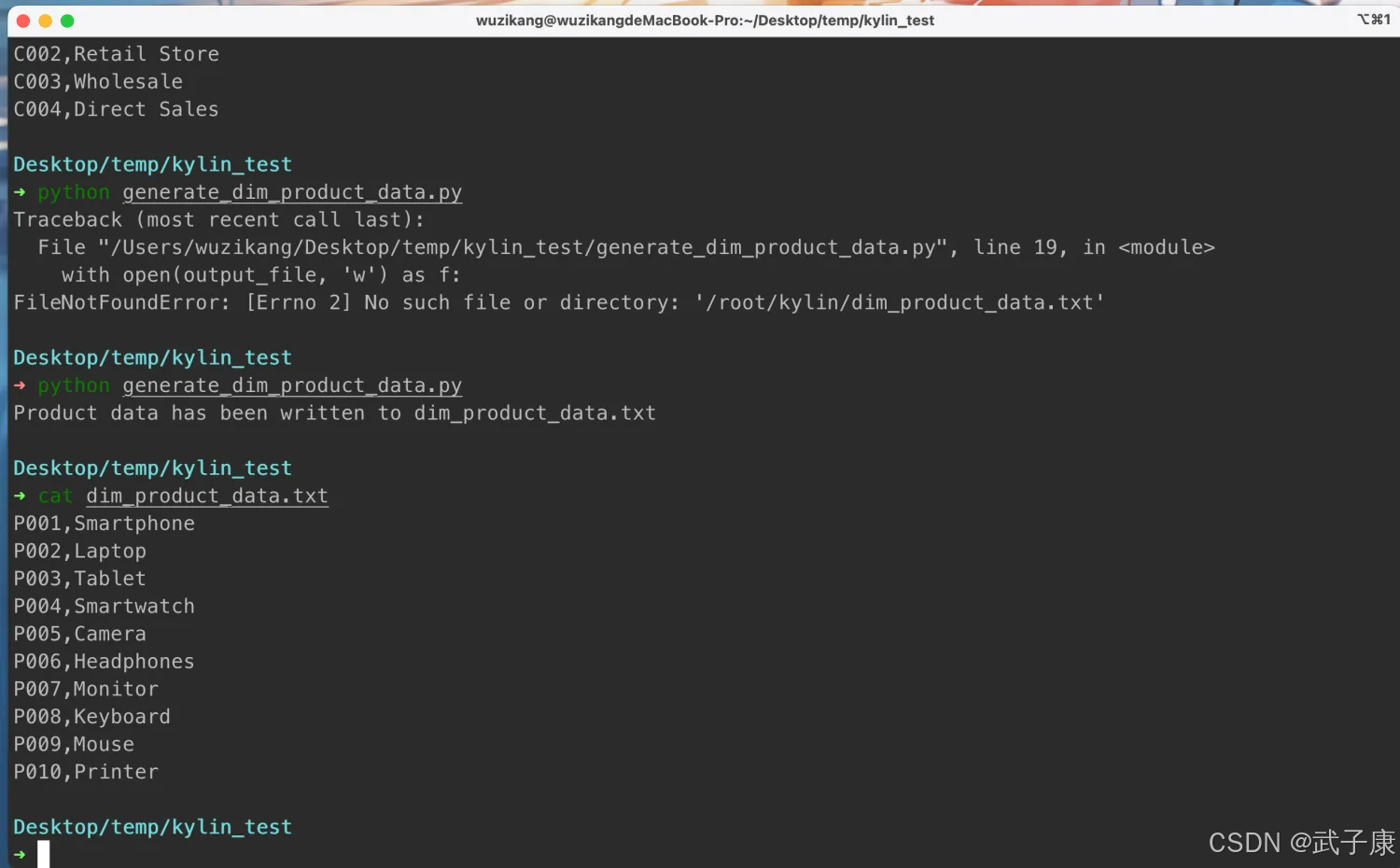

大数据-159 Apache Kylin 构建Cube 准备和测试数据(二)

接上篇:https://developer.aliyun.com/article/1623254?spm=a2c6h.13148508.setting.18.66e24f0etlssu8 dim_product_data # 设置参数 output_file = 'dim_pro...

【大数据开发运维解决方案】Kylin消费Kafka数据流式构建cube

文章开始之前先说明环境情况,这里kylin消费的kafka数据是从Oracle 数据库用Ogg For Bigdata以json格式将数据投递到kafka topic的,投递的时候,关于insert和update 之前的数据投递到名为 ZTVOUCHER_INS 的topic,而delete和update之后的数据投递到名为 ZTVOUCHER_DEL 的topic中,这里主要介绍kylin如何....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

云原生大数据计算服务 MaxCompute数据相关内容

- 数据科学云原生大数据计算服务 MaxCompute

- 数据云原生大数据计算服务 MaxCompute实战

- 数据云原生大数据计算服务 MaxCompute分析

- 智能数据云原生大数据计算服务 MaxCompute

- 工具数据云原生大数据计算服务 MaxCompute

- 同步云原生大数据计算服务 MaxCompute数据

- 大数据计算云原生大数据计算服务 MaxCompute数据

- dataworks云原生大数据计算服务 MaxCompute数据

- 数据云原生大数据计算服务 MaxCompute挖掘

- 数据云原生大数据计算服务 MaxCompute专家

- 云原生大数据计算服务 MaxCompute数据外表

- spark云原生大数据计算服务 MaxCompute数据

- 云原生大数据计算服务 MaxCompute分析数据技术

- 云原生大数据计算服务 MaxCompute数据处理数据

- 云原生大数据计算服务 MaxCompute数据技术

- 云原生大数据计算服务 MaxCompute分区数据

- 数据资产云原生大数据计算服务 MaxCompute

- maxcompute云原生大数据计算服务 MaxCompute数据

- 查询云原生大数据计算服务 MaxCompute数据

- 云原生大数据计算服务 MaxCompute优化数据

- 数据云原生大数据计算服务 MaxCompute技术

- 数据云原生大数据计算服务 MaxCompute企业

- 数据治理云原生大数据计算服务 MaxCompute数据质量

- 云原生大数据计算服务 MaxCompute技术数据

- 云原生大数据计算服务 MaxCompute测试数据

- 云原生大数据计算服务 MaxCompute apache数据

- 云原生大数据计算服务 MaxCompute构建数据

- 云原生大数据计算服务 MaxCompute flink数据

- 云原生大数据计算服务 MaxCompute方案数据

- 云原生大数据计算服务 MaxCompute学习数据

云原生大数据计算服务 MaxCompute更多数据相关

- 产品云原生大数据计算服务 MaxCompute数据

- 云原生大数据计算服务 MaxCompute数据增量

- 云原生大数据计算服务 MaxCompute数据分区表

- 云原生大数据计算服务 MaxCompute数据odps

- 云原生大数据计算服务 MaxCompute数据步骤

- 云原生大数据计算服务 MaxCompute增量数据

- 数据云原生大数据计算服务 MaxCompute价值

- 数据计算云原生大数据计算服务 MaxCompute离线同步数据

- 数据计算云原生大数据计算服务 MaxCompute数据导出

- 数据计算云原生大数据计算服务 MaxCompute数据oss

- 云原生大数据计算服务 MaxCompute产品数据

- 云原生大数据计算服务 MaxCompute tunnel数据

- 云原生大数据计算服务 MaxCompute下载数据

- 云原生大数据计算服务 MaxCompute sql数据

- 云原生大数据计算服务 MaxCompute查询数据

- 云原生大数据计算服务 MaxCompute数据报错

- dataworks数据云原生大数据计算服务 MaxCompute

- 云原生大数据计算服务 MaxCompute外部表数据

- 云原生大数据计算服务 MaxCompute任务数据

- 云原生大数据计算服务 MaxCompute命令数据

- 云原生大数据计算服务 MaxCompute存储数据

- 云原生大数据计算服务 MaxCompute pyodps数据

- 云原生大数据计算服务 MaxCompute模型数据

- 云原生大数据计算服务 MaxCompute数据配置

- 云原生大数据计算服务 MaxCompute数据oss

- 云原生大数据计算服务 MaxCompute分区表数据

- 云原生大数据计算服务 MaxCompute tunnel命令数据

- 云原生大数据计算服务 MaxCompute spark数据

- 云原生大数据计算服务 MaxCompute tunnel下载数据

- 云原生大数据计算服务 MaxCompute类型数据

云原生大数据计算服务 MaxCompute您可能感兴趣

- 云原生大数据计算服务 MaxCompute解析

- 云原生大数据计算服务 MaxCompute技术

- 云原生大数据计算服务 MaxCompute操控

- 云原生大数据计算服务 MaxCompute工具

- 云原生大数据计算服务 MaxCompute较量

- 云原生大数据计算服务 MaxCompute温度

- 云原生大数据计算服务 MaxCompute数据链路

- 云原生大数据计算服务 MaxCompute预测性维护

- 云原生大数据计算服务 MaxCompute故障

- 云原生大数据计算服务 MaxCompute设备

- 云原生大数据计算服务 MaxCompute MaxCompute

- 云原生大数据计算服务 MaxCompute大数据计算

- 云原生大数据计算服务 MaxCompute dataworks

- 云原生大数据计算服务 MaxCompute sql

- 云原生大数据计算服务 MaxCompute分析

- 云原生大数据计算服务 MaxCompute报错

- 云原生大数据计算服务 MaxCompute应用

- 云原生大数据计算服务 MaxCompute表

- 云原生大数据计算服务 MaxCompute阿里云

- 云原生大数据计算服务 MaxCompute spark

- 云原生大数据计算服务 MaxCompute产品

- 云原生大数据计算服务 MaxCompute任务

- 云原生大数据计算服务 MaxCompute同步

- 云原生大数据计算服务 MaxCompute计算

- 云原生大数据计算服务 MaxCompute开发

- 云原生大数据计算服务 MaxCompute大数据

- 云原生大数据计算服务 MaxCompute查询

- 云原生大数据计算服务 MaxCompute hadoop

- 云原生大数据计算服务 MaxCompute odps

- 云原生大数据计算服务 MaxCompute平台