Hadoop-14-Hive HQL学习与测试 表连接查询 HDFS数据导入导出等操作 逻辑运算 函数查询 全表查询 WHERE GROUP BY ORDER BY(一)

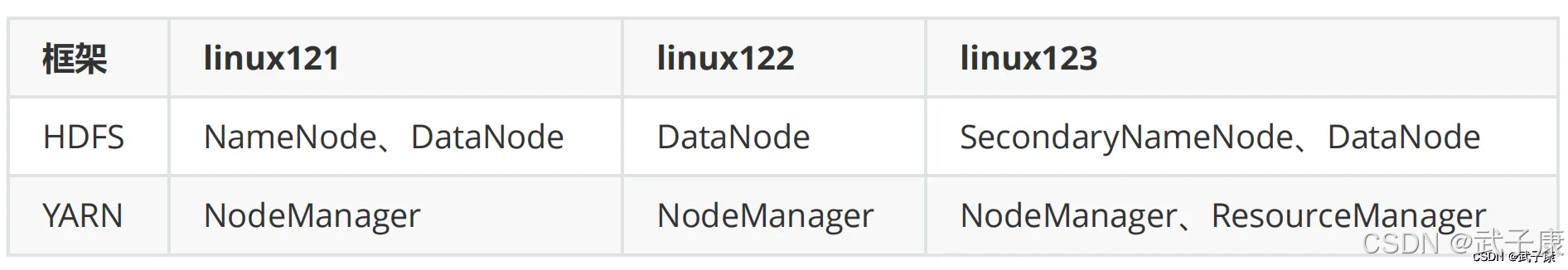

章节内容 上一节我们完成了: 启动Hive 测试Hive 修改配置 简单测试 背景介绍 这里是三台公网云服务器,每台 2C4G,搭建一个Hadoop的学习环境,供我学习。 之前已经在 VM 虚拟机上搭建过一次,但是没留下笔记,这次趁着前几天薅羊毛的3台机器,赶紧尝试在公网上搭建体验一下。 注意,如果你和我...

Hadoop-14-Hive HQL学习与测试 表连接查询 HDFS数据导入导出等操作 逻辑运算 函数查询 全表查询 WHERE GROUP BY ORDER BY(二)

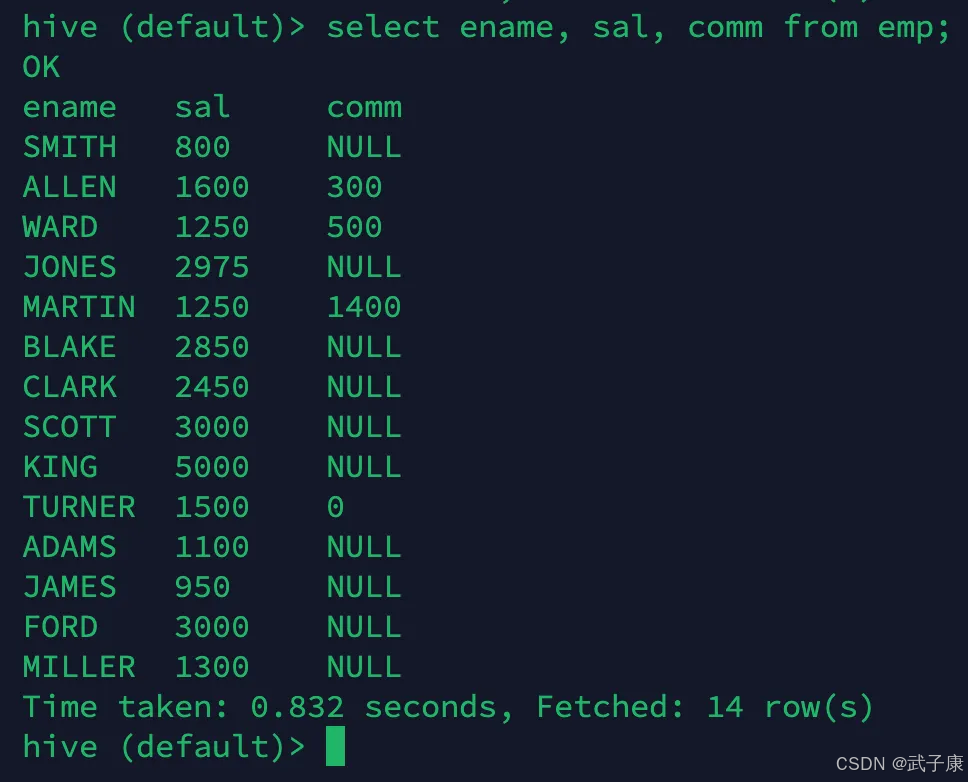

接上篇:https://developer.aliyun.com/article/1621741?spm=a2c6h.13148508.setting.14.49764f0eO8xDpK 部分字段查询 这与我们平常写SQL基本是一样的: select ename, sal...

Hadoop学习指南:探索大数据时代的重要组成——HDFS(上)

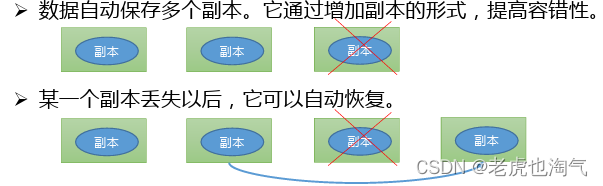

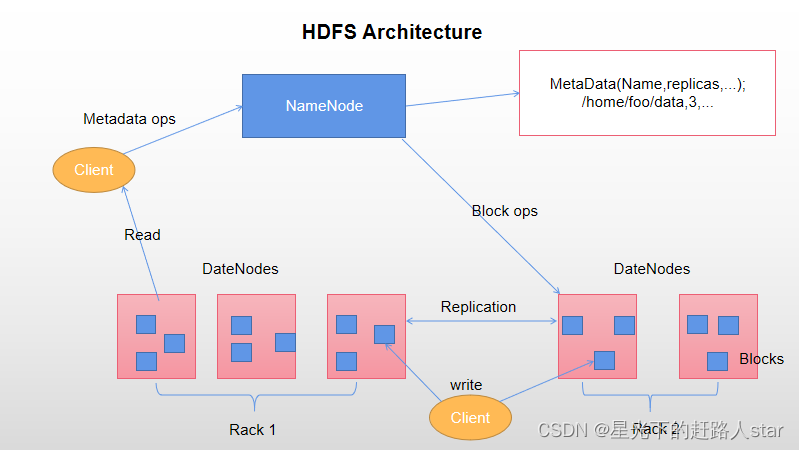

HDFS概述1.1 HDFS 产出背景及定义1)HDFS产生背景随着数据量越来越大,在一个操作系统存不下所有的数据,那么就分配到更多的操作系统管理的磁盘中,但是不方便管理和维护,迫切需要一种系统来管理多台机器上的文件,这就是分布式文件管理系统。HDFS只是分布式文件管理系统中的一种。2)HDFS定义HDFS(Hadoop Distributed File System),它是一个文件系统,用于存....

Hadoop学习指南:探索大数据时代的重要组成——HDFS(下)

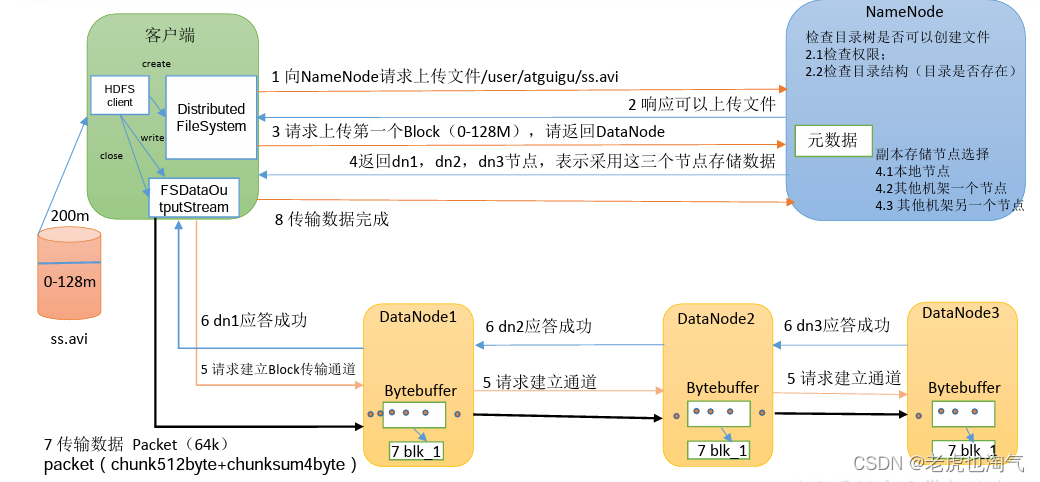

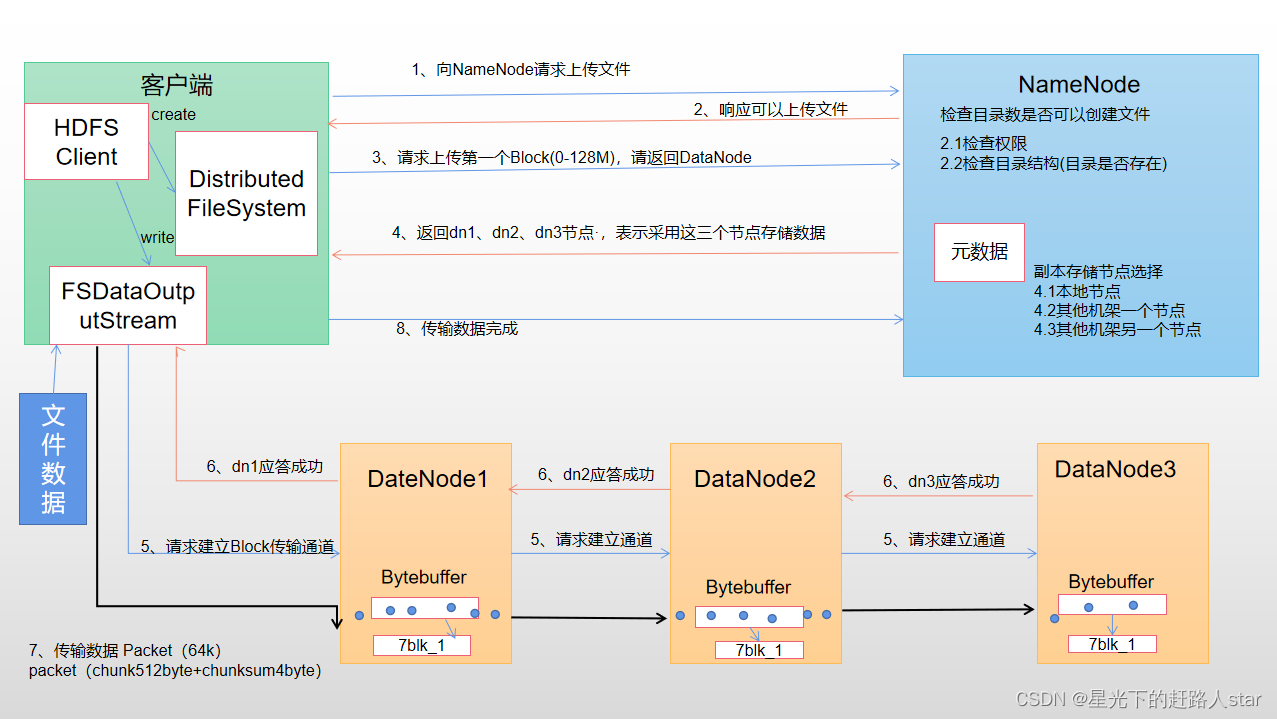

HDFS的读写流程(面试重点)HDFS 写数据流程1.1 剖析文件写入(1)客户端通过Distributed FilileSystem 模块向NameNode 请求上传文件,NameNode检查目标文件是否已存在,父目录是否存在。(2)NameNode返回是否可以上传。(3)客户端请求第一个 Block上传到哪几个DataNode服务器上。(4)NameNode返回3个DataNode节点,分别....

Hadoop基础学习---4、HDFS写、读数据流程、NameNode和SecondaryNameNode、DataNode

1、HDFS写、读数据流程1.1 HDFS写数据流程1.1 剖析文件写入1、客户端通过Distributed FileSystem模块向NameNode请求上传文件,NameNode检查目标文件是否已存在,父目录是否存在。2、NameNode返回是否可以上传。3、客户端请求第一个Block上传到哪几个DataNode服务器上。4、NameNode返回三个DataNode节点,分别为dn1、dn2....

Hadoop基础学习---3、HDFS概述、HDFS的Shell操作、HDFS的API操作

1、HDFS概述1.1 HDFS产出背景及定义1、HDFS产生背景随着数据量越来越大,在一个操作系统存不住所有的数据,那么就分配到更多的操作系统管理的磁盘中,但是不方便管理和维护,迫切需要一种系统来管理多台机器上的文件,这就是分布式文件管理系统。HDFS只是分布式文件管理系统中的一种。2、HDFS定义HDFS(Hadoop Distributed File System),是一个文件系统,用于存....

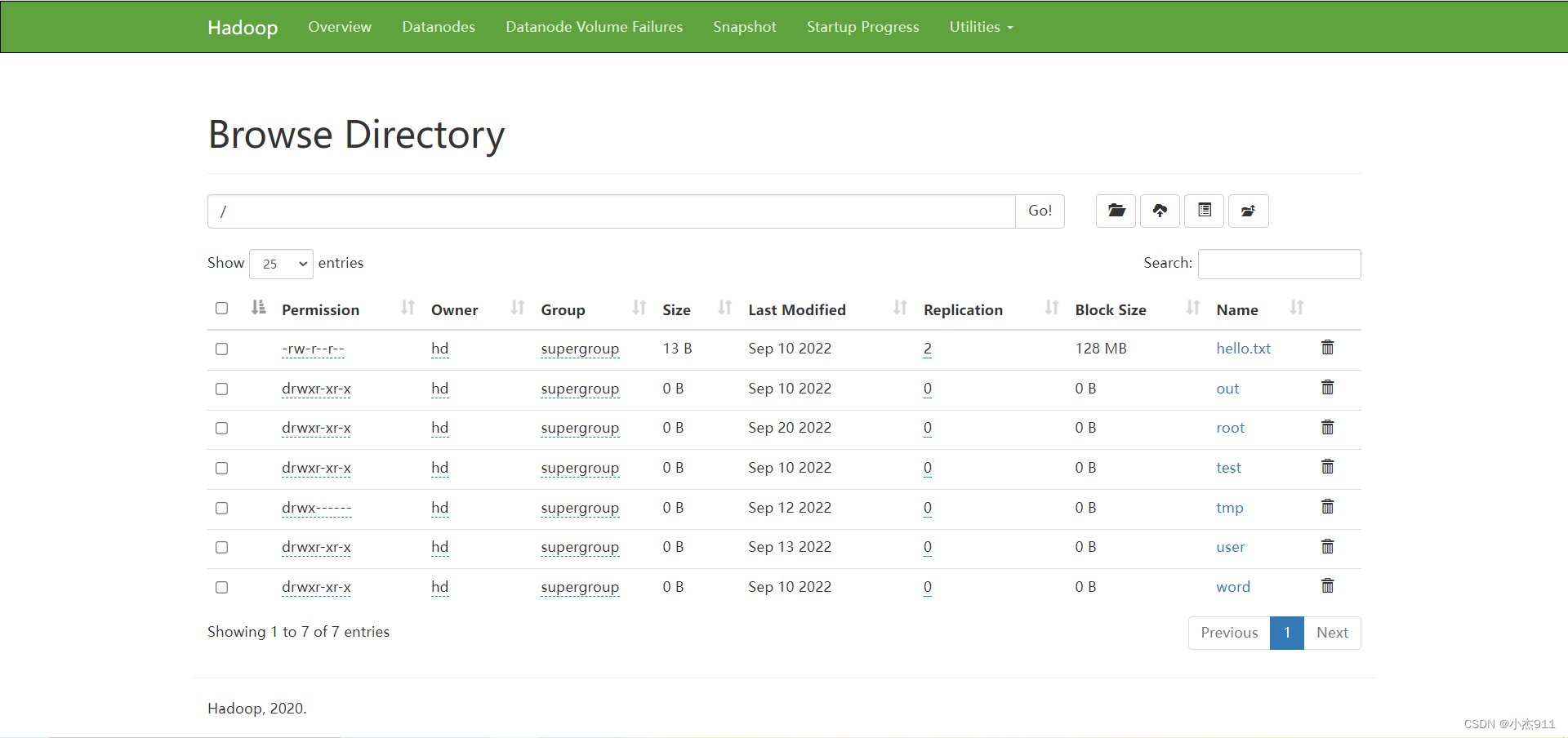

【大数据学习篇3】HDFS命令操作与MR单词统计

1. HDFS命令使用[root@master bin]# su hd[hd@master bin]$ #查看/目录[hd@master bin]$ hdfs dfs -ls /5#在/目录创建一个为test名字的文件夹[hd@master bin]$ hdfs dfs -mkdir /test#查看/目录[hd@master bin]$ hdfs dfs -ls Found 1 itemsdr....

flume学习(三):flume将log4j日志数据写入到hdfs

在第一篇文章中我们是将log4j的日志输出到了agent的日志文件当中。配置文件如下: [plain] view plaincopy tier1.sources=source1 tier1.channels=channel1 tier1.sinks=sink1 tier1.sources.s...

Hadoop学习(2)-java客户端操作hdfs及secondarynode作用

Hadoop学习(2)-java客户端操作hdfs及secondarynode作用首先要在windows下解压一个windows版本的hadoop 然后在配置他的环境变量,同时要把hadoop的share目录下的hadoop下的相关jar包拷贝到esclipe 然后Build Path 下面上代码 复制代码import java.io.BufferedReader;import java.io.....

Hadoop Hive概念学习系列之HDFS、Hive、MySQL、Sqoop之间的数据导入导出(强烈建议去看)(十八)

把MySQL里的数据导入到HDFS 1、使用MySQL工具手工导入 把MySQL的导出数据导入到HDFS的最简单方法就是,使用命令行工具和MySQL语句。 为了导出整个数据表或整个数据库的内容,MySQL提供了mysqldump工具。 比如 SELECT col1,col2 FORM TABLE &nbs...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

文件存储HDFS版您可能感兴趣

- 文件存储HDFS版架构

- 文件存储HDFS版数据

- 文件存储HDFS版数据源

- 文件存储HDFS版集成

- 文件存储HDFS版数据集成

- 文件存储HDFS版功能

- 文件存储HDFS版文件

- 文件存储HDFS版下载

- 文件存储HDFS版文件夹

- 文件存储HDFS版自定义

- 文件存储HDFS版hadoop

- 文件存储HDFS版flink

- 文件存储HDFS版操作

- 文件存储HDFS版大数据

- 文件存储HDFS版集群

- 文件存储HDFS版命令

- 文件存储HDFS版存储

- 文件存储HDFS版api

- 文件存储HDFS版hive

- 文件存储HDFS版java

- 文件存储HDFS版分布式文件系统

- 文件存储HDFS版目录

- 文件存储HDFS版节点

- 文件存储HDFS版文件存储

- 文件存储HDFS版mapreduce

- 文件存储HDFS版配置

- 文件存储HDFS版报错

- 文件存储HDFS版namenode

- 文件存储HDFS版读取

- 文件存储HDFS版原理