深度学习笔记(三):神经网络之九种激活函数Sigmoid、tanh、ReLU、ReLU6、Leaky Relu、ELU、Swish、Mish、Softmax详解

1.什么叫激活函数 激活函数可作用于感知机(wx+b)累加的总和 ,所谓的激活就是把输出值必须要大于,节点才可以被激活,不然就处于睡眠状态。 2.激活函数的作用 提供网络的非线性建模能力。如果没有激活函数,那么该网络仅能够表达线性映射,此时即便有再多的隐藏层,其整个网络跟单层神经网络也是等价的。因此也可以认为,只有加入了激活函数之后,深度神经网络才具备了分层的非线性映射学习能力。由于输出值是有限....

激活函数与神经网络------带你迅速了解sigmoid,tanh,ReLU等激活函数!!!

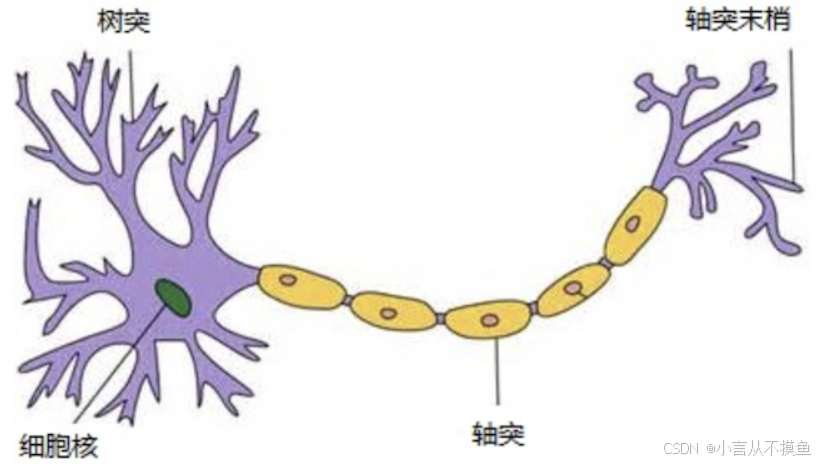

神经网络 什么是神经网络 人工神经网络( Artificial Neural Network, 简写为ANN)也简称为神经网络(NN),是一种模仿生物神经网络结构和功能的 计算模型。人脑可以看做是一个生物神经网络,由众多的神经元连接而成。各个神经元传递复杂的电信号,树突接收到输入信号,然后对信号进行处理,通过轴突输出信号。下图是生物神经元示意图: ...

在神经网络的反向传播中,Tanh和Sigmoid哪个更快

在神经网络的反向传播中,关于Tanh和Sigmoid哪个更快的问题,并没有一个绝对的答案,因为它取决于多个因素,包括网络的具体结构、数据的特性以及训练过程中的其他参数设置等。然而,我们可以从一些普遍性的角度来探讨这个问题。 梯度消失问题Sigmoid函数:当Sigmoid函数的输入值远离0时,其梯度...

【Pytorch神经网络理论篇】 07 激活函数+Sigmoid+tanh+ReLU+Swish+Mish+GELU

同学你好!本文章于2021年末编写,获得广泛的好评!故在2022年末对本系列进行填充与更新,欢迎大家订阅最新的专栏,获取基于Pytorch1.10版本的理论代码(2023版)实现,Pytorch深度学习·理论篇(2023版)目录地址为:CSDN独家 | 全网首发 | Pytorch深度学习·理论篇(2023版)目录本专栏将通过系统的深度学习实例,从可解释性的角度对深度学习的原理进行讲解与分析,通....

AI神经网络激活函数sigmoid及matlab的sigmf

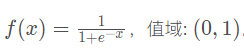

AI神经网络激活函数sigmoid及matlab的sigmf 神经网络中引入激活函数sigmoid作用是逻辑回归(logistic regression),引入非线性化。数学中的标准sigmoid输出范围是(0,1)。sigmoid的数学定义: 在matlab中,对于sigmoid的定义实现是sigmf,但是sigmf包含多个参数: 用MATLAB跑出不同的sigmoid函数曲线: x1=-1.....

神经网络中的激活函数——加入一些非线性的激活函数,整个网络中就引入了非线性部分,sigmoid 和 tanh作为激活函数的话,一定要注意一定要对 input 进行归一话,但是 ReLU 并不需要输入归一化

1 什么是激活函数? 激活函数,并不是去激活什么,而是指如何把“激活的神经元的特征”通过函数把特征保留并映射出来(保留特征,去除一些数据中是的冗余),这是神经网络能解决非线性问题关键。 目前知道的激活函数有如下几个:sigmoid,tanh,ReLu,softmax。 simoid函数也称S曲线:f(x)=11+e−x tanh:f(x)=tanh(x) ReLU:f(x)=max(x...

神经网络常用激活函数对比:sigmoid VS sofmax(附python源码)

首发地址:https://yq.aliyun.com/articles/73661 更多深度文章,请关注:https://yq.aliyun.com/cloud Softmax函数与Sigmoid函数之间的区别 作者介绍: Saimadhu Polamuri:是一名自学成才的数据科学家,对数据科学有热爱和兴趣,他认为学习意味着生活,擅长使用python编程,业余时间在quora上回答问题。 领.....

神经网络常用激活函数对比:sigmoid VS sofmax(附python源码)

更多深度文章,请关注:https://yq.aliyun.com/cloud Softmax函数与Sigmoid函数之间的区别 作者介绍: Saimadhu Polamuri:是一名自学成才的数据科学家,对数据科学有热爱和兴趣,他认为学习意味着生活,擅长使用python编程,业余时间在quora上回答问题。 领英:https://www.linkedin.com/in/saimadhu/ 博客.....

请问人工神经网络中为什么ReLu要好过于tanh和sigmoid function?

请问人工神经网络中为什么ReLu要好过于tanh和sigmoid function?

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

域名解析DNS

关注DNS行业趋势、技术、标准、产品和最佳实践,连接国内外相关技术社群信息,追踪业内DNS产品动态,加强信息共享,欢迎大家关注、推荐和投稿。

+关注