基于ModelScope模型库和GPU实例闲置计费功能低成本快速搭建LLM应用

LLM(Large Language Model)是指大型语言模型,是一种采用深度学习技术训练的具有大量参数的自然语言处理模型。您可以基于ModelScope模型库和函数计算GPU实例的闲置计费功能低成本快速搭建LLM应用实现智能问答。

基于ModelScope模型库和GPU实例闲置计费功能低成本构建Google Gemma服务

Google在2024年02月21日正式推出了首个开源模型族Gemma,并同时上架了2b和7b两个版本。您可以使用函数计算的GPU实例以及函数计算的闲置模式低成本快速部署Gemma模型服务。

函数计算产品使用问题之怎么访问网络附加存储(NAS)存储模型文件

问题一:函数计算在同个应用中,不仅要监听端口实现HTTP,还要接收来自rabbitmq触发器的消息,怎么办? 函数计算在同一个应用中,不仅要监听端口实现HTTP,还要接收来自rabbitmq触发器的消息,怎么办? 参考答案: 要在同一个应用中同时实现HTTP监听和接收来自RabbitMQ触发器的消息,您需要结合Web服务器(如Koa)和消息队列(如Ra...

函数计算产品使用问题之上传模型文件占用的是什么空间

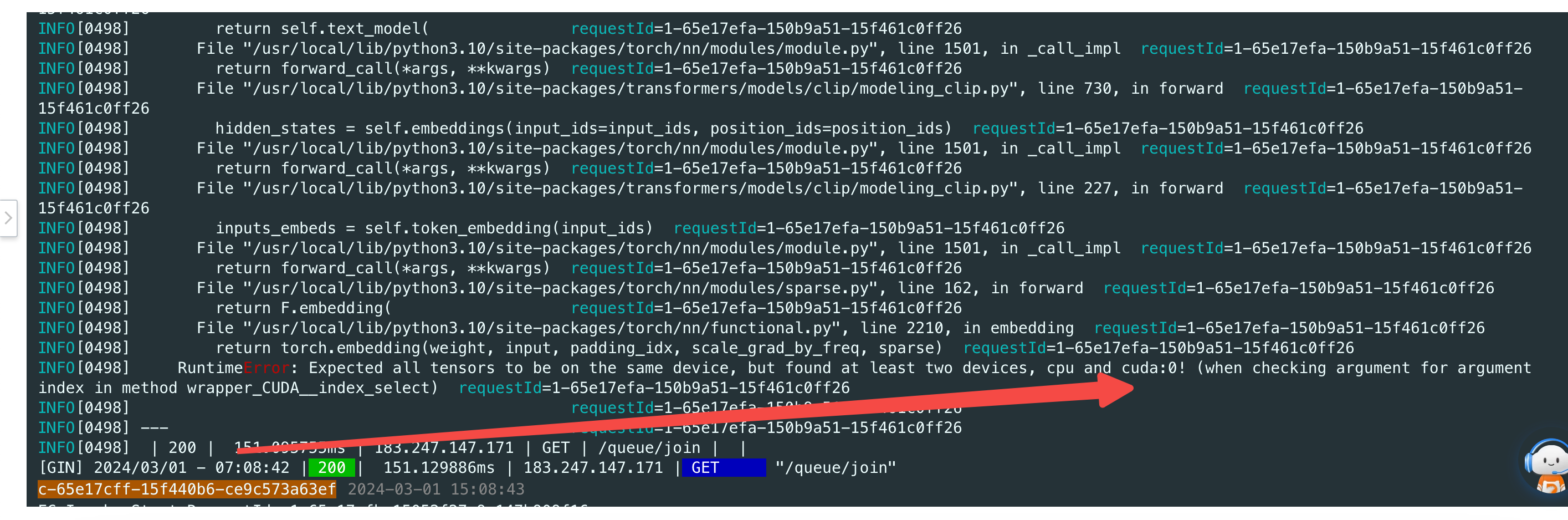

问题一:函数计算FC既存在cpu也存在gpu? 函数计算FC既存在cpu也存在gpu? 参考回答: 运行过程中,部分数据可能会跑到 cpu 上,有可能是 sd 自身问题,也可能是插件问题,建议尽量关...

函数计算产品使用问题之模型存放在NAS中,如何删除NAS中的模型文件

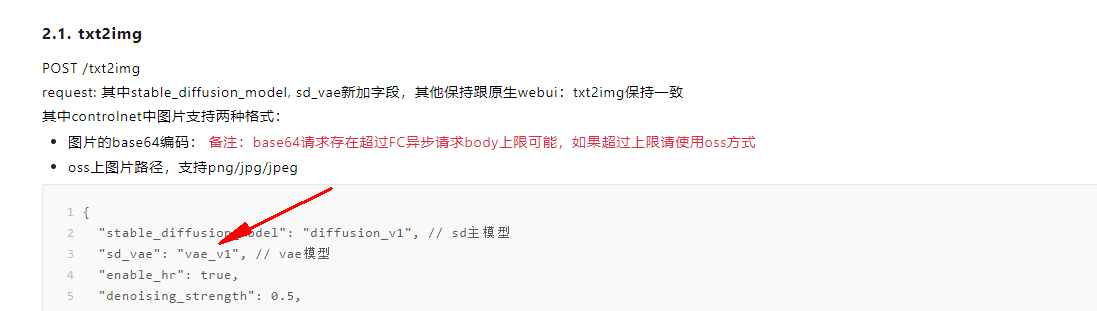

问题一:函数计算FC这个参数都要每次赋值吗? 函数计算FC这个参数都要每次赋值吗?"sd_vae": 参考回答: 不用直接去掉就行,不用传 关于本问题的更多回答可点击原文查看:https://developer.aliyun.com/ask/617855 问题二:函数计算FC的NAS中的模型文件如何删除? ...

安全责任共担模型

安全合规在ACK集群托管架构下遵循责任共担原则,其中容器服务ACK负责集群控制面组件(包括Kubernetes控制平面组件和etcd)以及集群服务相关阿里云基础设施的默认安全性。本文介绍阿里云容器服务ACK的安全责任共担模型。

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

函数计算模型相关内容

- 模型函数计算

- 函数计算部署模型

- 函数计算模型存储

- 函数计算gpu模型

- 模型魔搭函数计算

- 函数计算存储模型文件

- 函数计算文件存储nas模型

- 函数计算产品模型

- 函数计算访问模型

- 函数计算访问模型文件

- 函数计算模型文件

- 函数计算应用重建模型参数

- 函数计算模型参数

- 函数计算安装模型

- 函数计算tagger插件模型

- 函数计算tagger模型下载

- 函数计算文件管理模型

- 函数计算tagger模型

- 函数计算插件模型

- 函数计算模型下载

- 函数计算devs模型

- 函数计算信通院工具链模型

- 模型函数计算计费

- 灵积模型函数计算

- 函数计算代码模型

- 函数计算fc模型函数计算

- 函数计算安装模型插件

- 函数计算模型函数计算

- 训练模型函数计算

- 函数计算模型插件

函数计算更多模型相关

- 函数计算训练模型

- 函数计算模型功能

- 函数计算应用模型

- 函数计算安装模型报错

- 函数计算模型报错

- 函数计算模型运行

- 函数计算模型办法

- 函数计算模型排查

- 函数计算初始化模型

- 函数计算页面加载模型

- 函数计算nas模型

- 函数计算lora模型

- 函数计算模型webui

- 函数计算自定义模型

- 函数计算模型nas

- 函数计算模型目录

- 函数计算模型应用

- 函数计算模型加载

- 函数计算stable-diffusion模型

- 函数计算模型接口

- 函数计算模型费用

- 函数计算模型空间

- 函数计算模型刷新

- 函数计算模型配置

- 函数计算运行模型

- 函数计算页面模型

- 函数计算nas模型文件

- 函数计算模型请求

- 函数计算模型收费

- 函数计算comfyui模型