配置EAS服务使用GPU共享功能

在您使用专属资源组或灵骏智算资源配额部署服务时,EAS提供了GPU共享功能,以便充分利用资源。您只需在部署服务时打开GPU共享开关,系统便会在服务中部署虚拟化的GPU,EAS可以根据您配置的算力占比和使用显存来指定每个实例所需的资源。本文为您介绍如何配置GPU共享功能。

如何配置共享GPU调度节点选卡策略

默认情况,Pod分配GPU资源的顺序为先分配完节点上的一张GPU卡,再分配其他GPU卡,避免出现GPU资源碎片。但是在有的场景中,您希望让Pod调度到节点上时,尽量分散到各个GPU卡上,避免因为某张GPU卡坏掉影响的业务过多。本文介绍如何配置共享GPU调度节点选卡策略。

在GPU实例上启用eRDMA实现高效数据传输

GPU实例绑定弹性RDMA网卡(ERI)后,各GPU实例间在VPC网络下可以实现RDMA直通加速互连,相比传统的RDMA,eRDMA可以提供更高效的数据传输服务,有效提升GPU实例之间的通信效率并缩短任务处理时间。本文介绍如何在GPU实例上启用eRDMA。

配置共享GPU调度仅共享不隔离策略

在某些场景下,您可能不需要GPU隔离模块参与共享GPU调度。例如,有些业务应用自带显存限制能力。在这种情况下,使用GPU隔离模块可能不合适。对此,共享GPU调度支持某些节点不安装GPU隔离模块的选项。本文介绍如何配置共享GPU调度仅共享不隔离策略。

在GPU实例的Docker环境中快速配置eRDMA提升网络性能

eRDMA(Elastic Remote Direct Memory Access)是一种高性能网络通信技术,将eRDMA功能引入容器(Docker)环境可以实现容器应用程序绕过操作系统内核直接访问主机的物理eRDMA设备,从而提供更快的数据传输和通信效率,适用于在容器中需要大规模数据传输和高性能网络通信的应用场景。本文介绍如何使用eRDMA镜像在GPU实例上快速配置eRDMA。

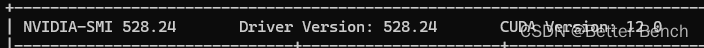

Windows11+CUDA12.0+RTX4090如何配置安装Tensorflow2-GPU环境?

1 引言 电脑配置 Windows 11cuda 12.0RTX4090 由于tensorflow2官网已经不支持cuda11以上的版本了,配置cuda和tensorflow可以通过以下步骤配置实现。 2 步骤 (1)创建conda环境并安装cuda和cudnn,以及安装tensorflow2.10 conda create -n tf39 python=3.9.* nu...

Windows下如何配置TensorFlow?这有个简单明了的教程(支持GPU哦)

首发地址:https://yq.aliyun.com/articles/68435 TensorFlow是谷歌基于DistBelief进行研发的第二代人工智能学习系统,其命名来源于本身的运行原理。Tensor(张量)意味着N维数组,Flow(流)意味着基于数据流图的计算,TensorFlow为张量从流图的一端流动到另一端计算过程。TensorFlow是将复杂的数据结构传输至人工智能神经网中进行分....

Windows下如何配置TensorFlow?这有个简单明了的教程(支持GPU哦)

TensorFlow是谷歌基于DistBelief进行研发的第二代人工智能学习系统,其命名来源于本身的运行原理。Tensor(张量)意味着N维数组,Flow(流)意味着基于数据流图的计算,TensorFlow为张量从流图的一端流动到另一端计算过程。TensorFlow是将复杂的数据结构传输至人工智能神经网中进行分析和处理过程的系统。TensorFlow可被用于语音识别或图像识别等多项机器深度学习....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

GPU云服务器您可能感兴趣

- GPU云服务器服务器

- GPU云服务器显卡

- GPU云服务器查询

- GPU云服务器性能

- GPU云服务器函数计算

- GPU云服务器ai

- GPU云服务器nvidia

- GPU云服务器部署

- GPU云服务器推理

- GPU云服务器程序

- GPU云服务器阿里云

- GPU云服务器实例

- GPU云服务器modelscope

- GPU云服务器cpu

- GPU云服务器模型

- GPU云服务器训练

- GPU云服务器计算

- GPU云服务器版本

- GPU云服务器安装

- GPU云服务器函数计算fc

- GPU云服务器资源

- GPU云服务器深度学习

- GPU云服务器购买

- GPU云服务器参数

- GPU云服务器教程

- GPU云服务器cuda

- GPU云服务器运行

- GPU云服务器应用

- GPU云服务器机器学习

- GPU云服务器价格