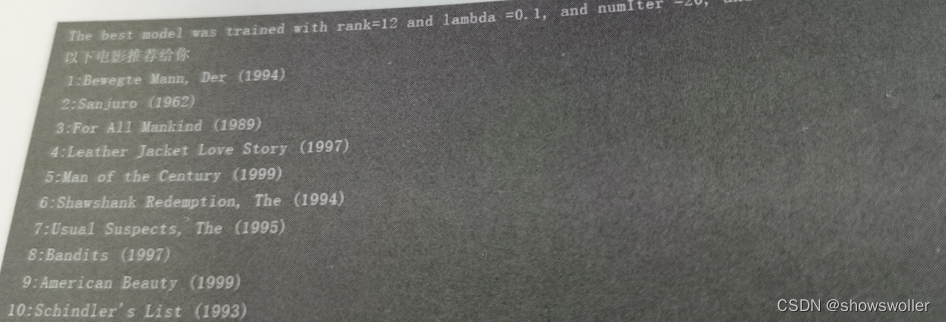

【大数据技术】Spark MLlib机器学习协同过滤电影推荐实战(附源码和数据集)

需要源码和数据集请点赞关注收藏后评论区留言私信~~~协同过滤————电影推荐协同过滤是利用大量已有的用户偏好来估计用户对其未接触过的物品的喜好程度。在协同过滤算法中有着两个分支,分别是基于群体用户的协同过滤(UserCF)和基于物品的协同过滤(ItemCF)。在电影推荐系统中,通常分为针对用户推荐电影和针对电影推荐用户两种方式。若采用基于用户的推荐模型,则会利用相似用户的评级来计算对某个用户的推....

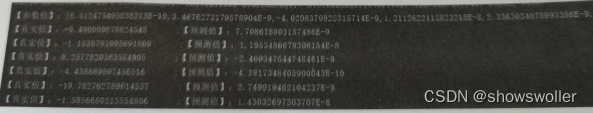

【大数据技术】Spark MLlib机器学习线性回归、逻辑回归预测胃癌是否转移实战(附源码和数据集)

需要源码和数据集请点赞关注收藏后评论区留言私信~~~线性回归过工具类MLUtils加载LIBSVM格式样本文件,每一行的第一个是真实值y,有10个特征值x,用1:double,2:double分别标注,即建立需求函数:y=a_1x_1+a_2x_2+a_3x_3+a_4x_4+…+a_10x_10通过样本数据和梯度下降训练模型,找到10个产生比较合理的参数值(a_1到a_10)回归结果如下部分代....

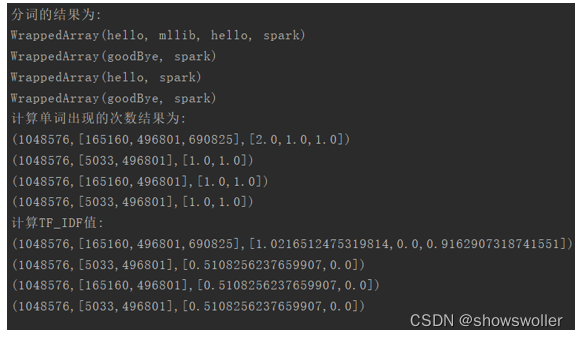

【大数据技术】Spark MLlib机器学习特征抽取 TF-IDF统计词频实战(附源码和数据集)

需要源码和数据集请点赞关注收藏后评论区留言私信~~~特征抽取 TF-IDFTF-IDF是两个统计量的乘积,即词频(Term Frequency, TF)和逆向文档频率(Inverse Document Frequency, IDF)。它们各自有不同的计算方法。TF是一个文档(去除停用词之后)中某个词出现的次数。它用来度量词对文档的重要程度,TF越大,该词在文档中就越重要。IDF逆向文档频率,是指....

【大数据技术】Spark+Flume+Kafka实现商品实时交易数据统计分析实战(附源码)

需要源码请点赞关注收藏后评论区留言私信~~~Flume、Kafka区别和侧重点1)Kafka 是一个非常通用的系统,你可以有许多生产者和消费者共享多个主题Topics。相比之下,Flume是一个专用工具被设计为旨在往HDFS,HBase等发送数据。它对HDFS有特殊的优化,并且集成了Hadoop的安全特性。如果数据被多个系统消费的话,使用kafka;如果数据有多个生产者场景,或者有写入Hbase....

【大数据技术Spark】DStream编程操作讲解实战(图文解释 附源码)

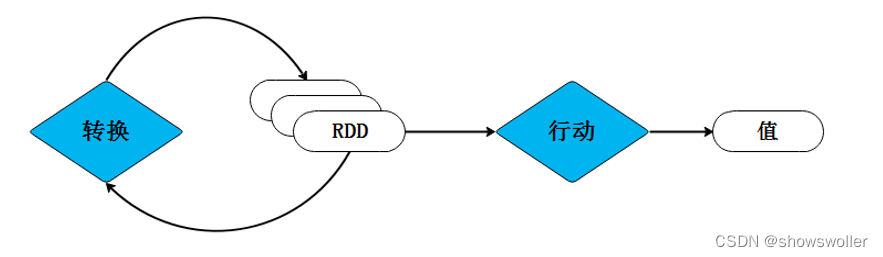

DStream编程批处理引擎Spark Core把输入的数据按照一定的时间片(如1s)分成一段一段的数据,每一段数据都会转换成RDD输入到Spark Core中,然后将DStream操作转换为RDD算子的相关操作,即转换操作、窗口操作以及输出操作。RDD算子操作产生的中间结果数据会保存在内存中,也可以将中间的结果数据输出到外部存储系统中进行保存。转换操作1:无状态转换操作无状态转化操作每个批次的....

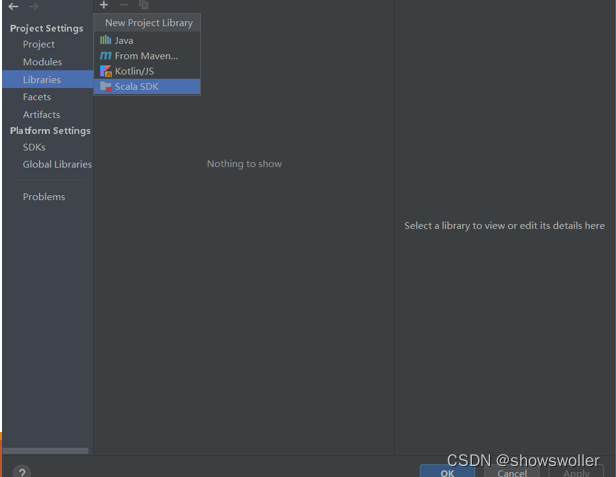

【大数据技术Spark】Spark SQL操作Dataframe、读写MySQL、Hive数据库实战(附源码)

需要源码和依赖请点赞关注收藏后评论区留言私信~~~一、Dataframe操作步骤如下1)利用IntelliJ IDEA新建一个maven工程,界面如下2)修改pom.XML添加相关依赖包3)在工程名处点右键,选择Open Module Settings4)配置Scala Sdk,界面如下5)新建文件夹scala,界面如下:6) 将文件夹scala设置成Source Root,界面如下:7) 新建....

【大数据技术Hadoop+Spark】Spark RDD创建、操作及词频统计、倒排索引实战(超详细 附源码)

需要源码和数据集请点赞关注收藏后评论区留言私信~~~一、RDD的创建Spark可以从Hadoop支持的任何存储源中加载数据去创建RDD,包括本地文件系统和HDFS等文件系统。我们通过Spark中的SparkContext对象调用textFile()方法加载数据创建RDD。1、从文件系统加载数据创建RDD从运行结果反馈的信息可以看出,wordfile是一个String类型的RDD,或者以后可以简单....

【大数据技术Hadoop+Spark】MapReduce之单词计数和倒排索引实战(附源码和数据集 超详细)

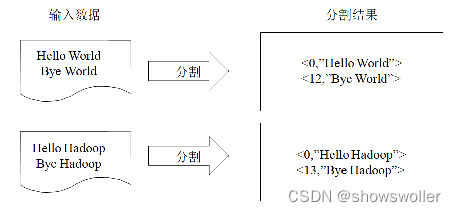

源码和数据集请点赞关注收藏后评论区留言私信~~~一、统计单词出现次数单词计数是最简单也是最能体现MapReduce思想的程序之一,可以称为MapReduce版“Hello World。其主要功能是统计一系列文本文件中每个单词出现的次数程序解析首先MapReduce将文件拆分成splits,由于测试用的文件较小,只有二行文字,所以每个文件为一个split,并将文件按行分割形成<key, va....

【大数据技术Hadoop+Spark】HDFS Shell常用命令及HDFS Java API详解及实战(超详细 附源码)

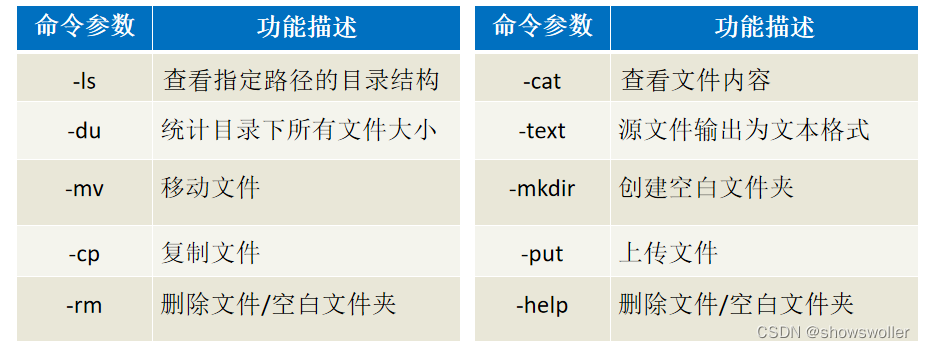

需要源码请点赞关注收藏后评论区留言私信~~~一、HDFS的Shell介绍Shell在计算机科学中俗称“壳”,是提供给使用者使用界面的进行与系统交互的软件,通过接收用户输入的命令执行相应的操作,Shell分为图形界面Shell和命令行式Shell。文件系统(FS)Shell包含了各种的类Shell的命令,可以直接与Hadoop分布式文件系统以及其他文件系统进行交互。常用命令如下 二、案例-Shel....

【云计算与大数据技术】流计算讲解及集群日志文件实时分析实战(附源码)

需要源码请点赞关注收藏后评论区留言私信~~一、流计算概述在传统的数据处理流程中总是先收集数据,然后将数据放到 DB中。当人们需要的 时候通过DB对数据做query,得到答案或进行相关的处理。这样看起来虽然非常合理,采用类似于 MapReduce方式的离线处理并不能很好地解决问题,结果却不理想,尤其是对一些实时搜索应用环境中的某些具体问题,这就引出了一种新的数据计算结构--流计算方式流计算可以很好....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

云原生大数据计算服务 MaxCompute技术相关内容

- 云原生大数据计算服务 MaxCompute技术解析

- 云原生大数据计算服务 MaxCompute技术方法论

- 云原生大数据计算服务 MaxCompute项目技术

- spark云原生大数据计算服务 MaxCompute技术

- 云计算云原生大数据计算服务 MaxCompute技术虚拟化

- 云原生大数据计算服务 MaxCompute技术团队

- 云原生大数据计算服务 MaxCompute工程技术入选

- 技术云原生大数据计算服务 MaxCompute

- 轻量级云原生大数据计算服务 MaxCompute技术

- 云原生大数据计算服务 MaxCompute数据处理技术

- 云原生大数据计算服务 MaxCompute技术融合

- 云原生大数据计算服务 MaxCompute技术企业决策

- 云原生大数据计算服务 MaxCompute技术企业

- 数据湖技术云原生大数据计算服务 MaxCompute

- 云原生大数据计算服务 MaxCompute技术工具

- 云原生大数据计算服务 MaxCompute技术服务

- 云原生大数据计算服务 MaxCompute技术智能

- 云原生大数据计算服务 MaxCompute技术智能决策

- 云原生大数据计算服务 MaxCompute技术场景

- 云原生大数据计算服务 MaxCompute技术应用场景

- 云原生大数据计算服务 MaxCompute技术就业

- 云原生大数据计算服务 MaxCompute技术专业

- 云原生大数据计算服务 MaxCompute技术多元

- 云原生大数据计算服务 MaxCompute技术医疗

- 云原生大数据计算服务 MaxCompute maxcompute技术

- 云原生大数据计算服务 MaxCompute场景技术

- 云原生大数据计算服务 MaxCompute实践技术

- 云原生大数据计算服务 MaxCompute系统技术

- 云原生大数据计算服务 MaxCompute技术分布式计算

- 云原生大数据计算服务 MaxCompute技术优化

云原生大数据计算服务 MaxCompute更多技术相关

- ots云原生大数据计算服务 MaxCompute物联网系统技术重构

- 飞天云原生大数据计算服务 MaxCompute技术

- mapreduce云原生大数据计算服务 MaxCompute技术

- 阿里云云原生大数据计算服务 MaxCompute工程技术入选

- 云原生大数据计算服务 MaxCompute技术pdf

- 云原生大数据计算服务 MaxCompute技术组件

- 云原生大数据计算服务 MaxCompute技术jdbc

- 云原生大数据计算服务 MaxCompute技术智能系统

- 云原生大数据计算服务 MaxCompute技术系统

- 云原生大数据计算服务 MaxCompute技术交通

- 云原生大数据计算服务 MaxCompute技术公开课

- 云原生大数据计算服务 MaxCompute技术实验

- 云原生大数据计算服务 MaxCompute技术简介

- 云原生大数据计算服务 MaxCompute技术spark

- 云原生大数据计算服务 MaxCompute技术hdfs

- 云原生大数据计算服务 MaxCompute产品技术特性

- 云原生大数据计算服务 MaxCompute云计算技术

- 云原生大数据计算服务 MaxCompute技术项目

- 云原生大数据计算服务 MaxCompute技术概述

- 云原生大数据计算服务 MaxCompute技术hbase

- 云原生大数据计算服务 MaxCompute技术阿里云

- 阿里云原生大数据计算服务 MaxCompute技术

- 云原生大数据计算服务 MaxCompute技术工程

- 云原生大数据计算服务 MaxCompute技术实践

- 云原生大数据计算服务 MaxCompute技术mapreduce

- 技术专家云原生大数据计算服务 MaxCompute

- 云原生大数据计算服务 MaxCompute技术在线教育

- 云原生大数据计算服务 MaxCompute技术峰会

- 技术云原生大数据计算服务 MaxCompute公开课

- 云原生大数据计算服务 MaxCompute实战技术

云原生大数据计算服务 MaxCompute您可能感兴趣

- 云原生大数据计算服务 MaxCompute解析

- 云原生大数据计算服务 MaxCompute操控

- 云原生大数据计算服务 MaxCompute工具

- 云原生大数据计算服务 MaxCompute较量

- 云原生大数据计算服务 MaxCompute温度

- 云原生大数据计算服务 MaxCompute数据链路

- 云原生大数据计算服务 MaxCompute预测性维护

- 云原生大数据计算服务 MaxCompute故障

- 云原生大数据计算服务 MaxCompute设备

- 云原生大数据计算服务 MaxCompute移动应用

- 云原生大数据计算服务 MaxCompute MaxCompute

- 云原生大数据计算服务 MaxCompute大数据计算

- 云原生大数据计算服务 MaxCompute数据

- 云原生大数据计算服务 MaxCompute dataworks

- 云原生大数据计算服务 MaxCompute sql

- 云原生大数据计算服务 MaxCompute分析

- 云原生大数据计算服务 MaxCompute报错

- 云原生大数据计算服务 MaxCompute应用

- 云原生大数据计算服务 MaxCompute表

- 云原生大数据计算服务 MaxCompute阿里云

- 云原生大数据计算服务 MaxCompute spark

- 云原生大数据计算服务 MaxCompute产品

- 云原生大数据计算服务 MaxCompute任务

- 云原生大数据计算服务 MaxCompute同步

- 云原生大数据计算服务 MaxCompute计算

- 云原生大数据计算服务 MaxCompute开发

- 云原生大数据计算服务 MaxCompute大数据

- 云原生大数据计算服务 MaxCompute查询

- 云原生大数据计算服务 MaxCompute hadoop

- 云原生大数据计算服务 MaxCompute odps