RAGEN:RL训练LLM推理新范式!开源强化学习框架让Agent学会多轮决策

❤️ 如果你也关注 AI 的发展现状,且对 AI 应用开发感兴趣,我会每日分享大模型与 AI 领域的开源项目和应用,提供运行实例和实用教程,帮助你快速上手AI技术! AI 在线答疑 -> 智能检索历史文章和开源项目 -> 丰富的 AI 工具库 -> 每日更新 -> 尽在微信公众号 -> 搜一搜:蚝油菜花 「RL训练LLM推理新范式!开源框架让Agent学会多...

关于LLM-as-a-judge范式,终于有综述讲明白了

在人工智能(AI)和自然语言处理(NLP)领域,评估和判断一直都是关键性难题。传统方法,无论是基于匹配还是基于嵌入,在处理细微属性和提供满意结果方面都存在不足。然而,随着大型语言模型(LLM)的最新进展,一种名为"LLM-as-a-ju...

企业级LLM推理部署新范式:基于ACK的DeepSeek蒸馏模型生产环境落地指南

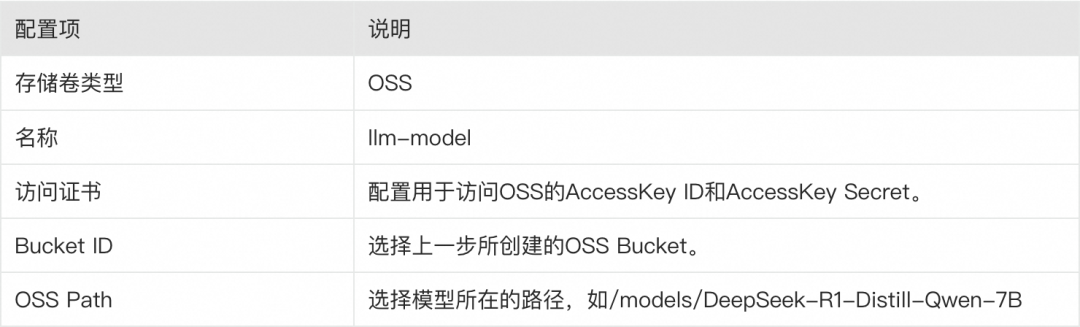

DeepSeek凭借其出色的推理表现在春节期间火爆全网,本文重点介绍如何在阿里云容器服务ACK中使用KServe部署生产可用的DeepSeek模型推理服务。 背景介绍 1. DeepSeek R1模型 DeepSeek-R1[1]模型是DeepSeek推出的第一代推理模型,旨在通过大规模强化学习提升大语言模型的推理能力。实验结果表明,Deep...

企业级LLM推理部署新范式:基于ACK的DeepSeek蒸馏模型生产环境落地指南

【阅读原文】戳:企业级LLM推理部署新范式:基于ACK的DeepSeek蒸馏模型生产环境落地指南 DeepSeek凭借其出色的推理表现在春节期间火爆全网,本文重点介绍如何在阿里云容器服务ACK中使用KServe部署生产可用的DeepSeek模型推理服务。 背景介绍 ...

CPU反超NPU,llama.cpp生成速度翻5倍!LLM端侧部署新范式T-MAC开源

随着大型语言模型(LLM)在智能设备上的广泛应用,如何在资源受限的边缘设备上高效部署LLM成为了一个关键问题。最近,微软研究院提出了一种名为T-MAC的创新方法,通过查表法(LUT)在CPU上实现低比特LLM(即权重量化LLM)的高效推理。T-MAC直接支持混合精度矩阵乘...

谈谈LLM在推荐域的渗透,探索推荐新范式

来源|阿里开发者公众号作者|葬青前言最近大模型真的很火,从个人到公司,各行各业都在学习大模型、总结大模型和尝试应用大模型。大模型其实不是一个新的产物,已经在NLP发展了很多年。ChatGPT的诞生,经验的效果震惊了所有人,虽然也有一些瑕疵,但是瑕不掩瑜。微软投资OpenAI看到了它的未来。微软快速围绕ChatGPT对相关的产品进行了产品升级,从搜索到微软365各种产品。5.29号有机会和部门的一....

仅使用解码器实现语音翻译,字节跳动提出基于LLM的新范式PolyVoice

近年来,大规模语言模型(LLMs)建模在 NLP 领域取得了许多突破,特别是 ChatGPT 的成功,正引领大家迈入一个新的 AI 时代。截止目前,基于 encoder-decoder 框架的模型在语音处理任务中仍占主导地位,而基于语言模型(LM)的方法还处于初期探索阶段。AudioLM 和 VALL-E 作为前期工作已经证明了利用离散语义单元(Semantic Units)和离散声学单元(Ac....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。