如何通过Python SDK V2进行日志转存

访问OSS的过程中会产生大量的访问日志。您可以通过日志转存功能将这些日志按照固定命名规则,以小时为单位生成日志文件写入您指定的存储空间(Bucket)。

如何通过Python sdk查询Logstore中的日志数据

调用GetLogsV2接口查询指定Project下某个Logstore中的原始日志数据,返回结果显示某时间区间中的原始日志(返回结果压缩后传输)。

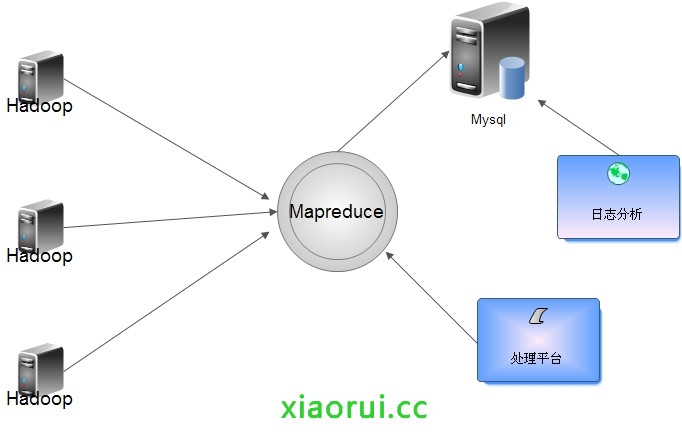

使用python构建基于hadoop的mapreduce日志分析平台

出处:http://rfyiamcool.blog.51cto.com/1030776/1340057 流量比较大的日志要是直接写入Hadoop对Namenode负载过大,所以入库前合并,可以把各个节点的日志凑并成一个文件写入HDFS。 根据情况定期合成,写入到hdfs里面。 咱们看看日志的大小,200G的dns日志...

使用python构建基于hadoop的mapreduce日志分析平台

原创rfyiamcool2013-12-12 23:51:47评论(11)4411人阅读 流量比较大的日志要是直接写入Hadoop对Namenode负载过大,所以入库前合并,可以把各个节点的日志凑并成一个文件写入HDFS。 根据情况定期合成,写入到hdfs里面。 咱们看看日志的大小,200G的dns日志文件,我压缩到了18G,要是用awk perl当然也可以,但是处理速度肯定...

python调用mrjob实现hadoop的mapreduce日志解析

咱们一般写mapreduce是通过java和streaming来写的,身为pythoner的我, java不会,没办法就用streaming来写mapreduce日志分析。 这里要介绍一个 模块,是基于streaming搞的东西。 mrjob 可以让用 Python 来编写 MapReduce 运算,并在多个不同平台上运行,你可以: 使用纯 Python 编写多步的 MapReduce 作...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

Python日志相关内容

- azure service Python日志

- Python自动化日志

- Python日志loguru

- Python日志最佳实践

- 函数计算Python日志

- Python日志模块

- Python请求日志

- Python多进程日志

- 大数据计算maxcompute Python日志

- Python日志实战

- loguru Python日志

- Python配置文件日志

- Python logging日志

- Python日志调试

- Python日志logging

- 日志Python

- Python日志库日志

- Python loguru日志

- Python nginx日志

- Python任务日志

- Python日志自定义

- Python log日志

- Python正则日志

- Python日志采集详细

- Python日志平台

- Python邮件日志

- Python日志服务大规模数据分析处理

- Python handler自动上传日志