实时计算Flink读写OSS或者OSS-HDFS

阿里云实时计算Flink支持通过连接器读写OSS以及OSS-HDFS数据。通过配置OSS或者OSS-HDFS连接器的输入属性,实时计算Flink会自动从指定的路径读取数据,并将其作为实时计算Flink的输入流,然后将计算结果按照指定格式写入到OSS或者OSS-HDFS的指定路径。

在挂载文件存储HDFS版的Hadoop集群上安装及使用ApacheFlink

本文介绍如何在挂载文件存储 HDFS 版的Hadoop集群上安装及使用Apache Flink。

实时计算 Flink版操作报错合集之Hadoop在将文件写入HDFS时,无法在所有指定的数据节点上进行复制,该如何解决

问题一:Flink CDC里flinkcdc写hudi的时候这个错误怎么弄? Flink CDC里flinkcdc写hudi的时候这个错误怎么弄? own Source) at org.apache.hadoop.hdfs.DF...

Flink报错:是不是必须要指向HDFS的目录?

Flink报错:The "yarn.provided.lib.dirs" should only contain dirs accessible from all worker nodes, while the "file:/etlApp/etl-dw-flink/lib/*" is local,是不是必须要指向HDFS的目录

开源版本Flink如何使用JindoSDK处理OSS HDFS服务的数据

开源Flink不支持流式写入OSS-HDFS服务,也不支持以EXACTLY_ONCE语义写入存储介质。当您希望开源Flink以EXACTLY_ONCE语义流式写入OSS-HDFS服务,需要结合JindoSDK。

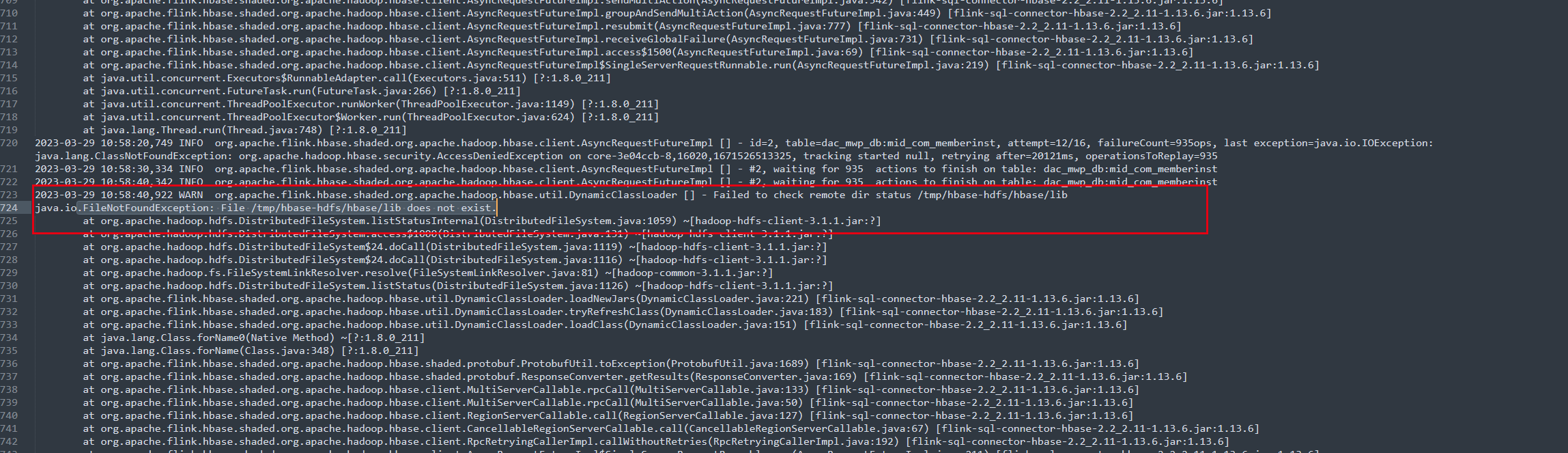

Flink报错问题之flink-sql写hdfs报错如何解决

问题一:在使用flink-sql-connnect-hbase的时候老是出现这个报错是什么原因呢 问下我在使用flink-sql-connnect-hbase的时候老是出现这个报错是什么原因呢 ...

请教下 flink 报错 hdfs dfs -ls 可以正常执行吗?

请教下 flink on yarn 模式 跑wordcount run ./examples/batch/WordCount.jar --input hdfs://node1:8020/flink1.16.3/input/wordcount.txt --output hdfs://node1:8020/flink1.16.3/ouput 报错 hdfs dfs -ls 可以...

Flink如何以EMR集群的方式可恢复性写入OSS-HDFS服务

可恢复性写入功能支持将数据以EXACTLY_ONCE语义写入存储介质。本文介绍Flink如何通过EMR集群的方式可恢复性写入OSS-HDFS服务。

大佬们有见过flink 1.17.0写hive报错hdfs路劲不存在的问题吗,多跑几次就可以成功?

问题1:大佬们有见过flink 1.17.0写hive报错hdfs路劲不存在的问题吗,多跑几次就可以成功? SYNC 问题2:不会有其他作业操作这个表

大佬们有见过flink 1.17.0写hive报错hdfs路劲不存在的问题吗,多跑几次就可以成功?

大佬们有见过flink 1.17.0写hive报错hdfs路劲不存在的问题吗,多跑几次就可以成功?

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

文件存储HDFS版您可能感兴趣

- 文件存储HDFS版架构

- 文件存储HDFS版数据

- 文件存储HDFS版数据源

- 文件存储HDFS版集成

- 文件存储HDFS版数据集成

- 文件存储HDFS版功能

- 文件存储HDFS版文件

- 文件存储HDFS版下载

- 文件存储HDFS版文件夹

- 文件存储HDFS版自定义

- 文件存储HDFS版hadoop

- 文件存储HDFS版操作

- 文件存储HDFS版大数据

- 文件存储HDFS版集群

- 文件存储HDFS版命令

- 文件存储HDFS版存储

- 文件存储HDFS版api

- 文件存储HDFS版hive

- 文件存储HDFS版java

- 文件存储HDFS版分布式文件系统

- 文件存储HDFS版目录

- 文件存储HDFS版节点

- 文件存储HDFS版文件存储

- 文件存储HDFS版mapreduce

- 文件存储HDFS版配置

- 文件存储HDFS版报错

- 文件存储HDFS版namenode

- 文件存储HDFS版读取

- 文件存储HDFS版原理

- 文件存储HDFS版访问