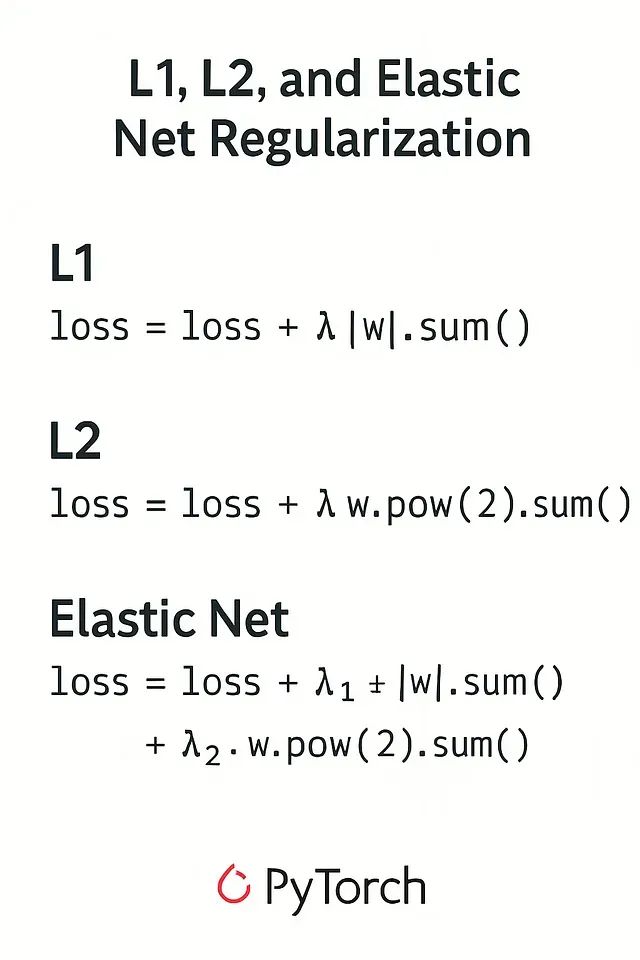

提升模型泛化能力:PyTorch的L1、L2、ElasticNet正则化技术深度解析与代码实现

神经网络训练过程中,模型优化与过拟合防控之间的平衡是一个核心挑战。过拟合的模型虽然在训练数据上表现优异,但由于其复杂性导致模型将训练数据集的特定特征作为映射函数的组成部分,在实际部署环境中往往表现不佳,甚至出现性能急剧下降的问题。正则化技术是解决此类问题的有效方法。本文将深入探讨L1、L2和ElasticNet正则化技术,重点关注其在PyTorch框架中的具体实现。关于这些技术的理论基础,建议读....

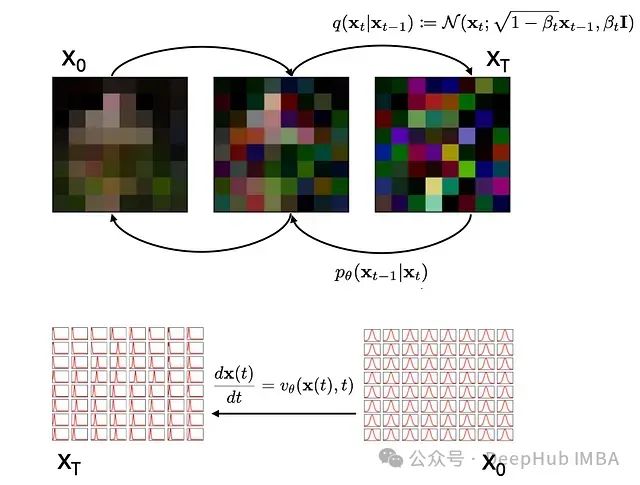

比扩散策略更高效的生成模型:流匹配的理论基础与Pytorch代码实现

扩散模型(Diffusion Models)和流匹配(Flow Matching)是用于生成高质量、连贯性强的高分辨率数据(如图像和机器人轨迹)的先进技术。在图像生成领域,扩散模型的代表性应用是Stable Diffusion,该技术已成功迁移至机器人学领域,形成了所谓的"扩散策略"(Diffusion Policy)。值得注意的是,扩散实际上是流匹配的特例,流匹配作为一种更具普适性的方法,已被....

从零实现基于扩散模型的文本到视频生成系统:技术详解与Pytorch代码实现

本文详细介绍了基于扩散模型构建的文本到视频生成系统,展示了在MSRV-TT和Shutterstock视频标注数据集上训练的模型输出结果。以下是模型在不同提示词下的生成示例。首先展示一些模型生成效果展示 提示词:"A person holding a camera"(训练10K步) 拿相机的人物场景 提示词:"Spaceship crossing the bridge"(训练10K步) 飞船穿过桥....

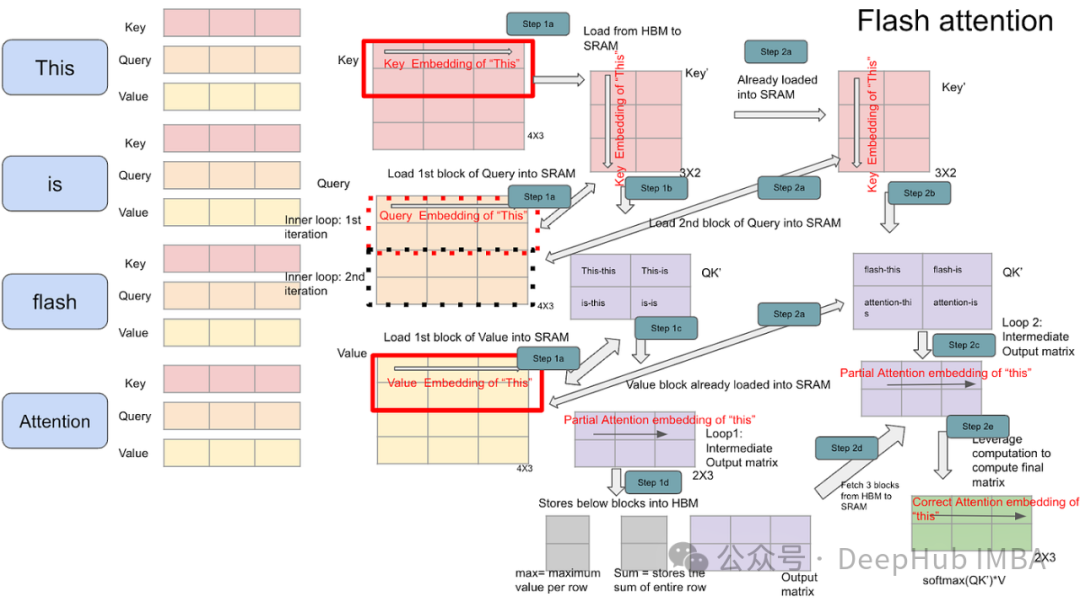

Transformer模型变长序列优化:解析PyTorch上的FlashAttention2与xFormers

随着生成式AI(genAI)模型在应用范围和模型规模方面的持续扩展,其训练和部署所需的计算资源及相关成本也呈现显著增长趋势,模型优化对于提升运行时性能和降低运营成本变得尤为关键。作为现代genAI系统核心组件的Transformer架构及其注意力机制,由于其计算密集型的特性,成为优化的重点对象。 在前面的文章中,我们已经介绍了优化注意力核函数能够显著提升Transformer模型的性能。本文将进....

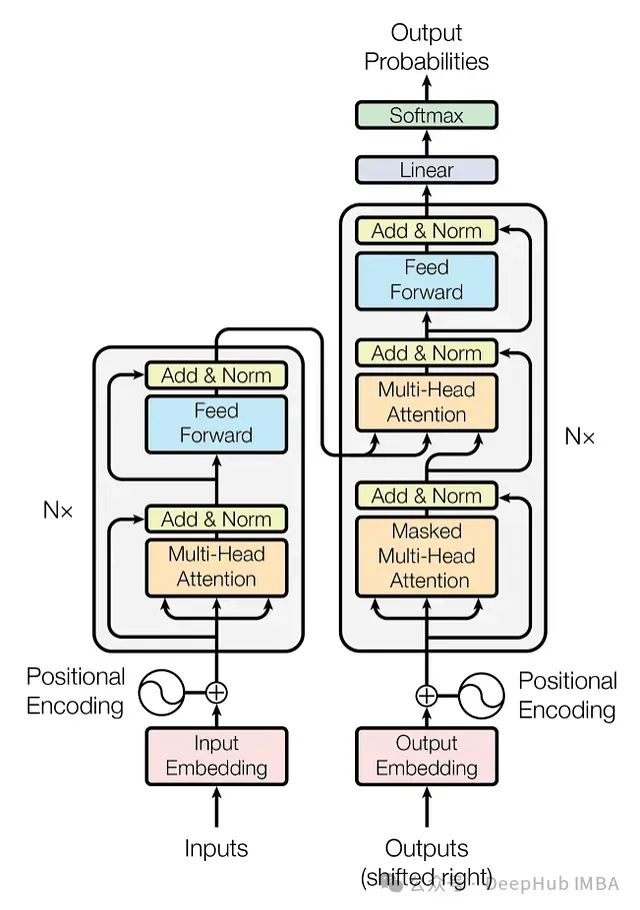

三种Transformer模型中的注意力机制介绍及Pytorch实现:从自注意力到因果自注意力

本文深入探讨Transformer模型中三种关键的注意力机制:自注意力、交叉注意力和因果自注意力。这些机制是GPT-4、Llama等大型语言模型(LLMs)的核心组件。通过理解这些注意力机制,我们可以更好地把握这些模型的工作原理和应用潜力。 我们不仅会讨论理论概念,还将使用Python和PyTorch从零开始实现这些注意力机制。通过实际编码,我们可以更深入地理解这些机制的内部工作原理。 文章目录....

AI智能体研发之路-模型篇(五):pytorch vs tensorflow框架DNN网络结构源码级对比

一、引言 本文是上一篇AI智能体研发之路-模型篇(四):一文入门pytorch开发的番外篇,对上文中pytorch的网络结构和tensorflow的模型结构部分进一步详细对比与说明(水一篇为了得到当天的流量卷哈哈,如果想更详细的了解pytorch,辛苦移步上一篇哈。 二、pytorch模型结构定义 ...

在深度学习中,数据增强是一种常用的技术,用于通过增加训练数据的多样性来提高模型的泛化能力。`albumentations`是一个强大的Python库,用于图像增强,支持多种图像变换操作,并且可以与深度学习框架(如PyTorch、TensorFlow等)无缝集成。

一、引言 在深度学习中,数据增强是一种常用的技术,用于通过增加训练数据的多样性来提高模型的泛化能力。albumentations是一个强大的Python库,用于图像增强,支持多种图像变换操作,并且可以与深度学习框架(如PyTorch、TensorFlow等)无缝集成。 二、albumentation...

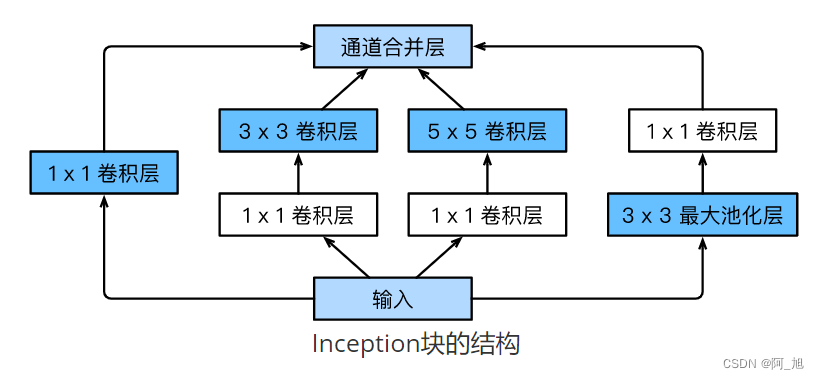

【从零开始学习深度学习】29.卷积神经网络之GoogLeNet模型介绍及用Pytorch实现GoogLeNet模型【含完整代码】

GoogLeNet网络架构于2014年由Google团队提出,并且在2014年的ImageNet图像识别挑战赛中大放异彩 。GoogLeNet吸收了NiN中网络串联网络的思想,并在此基础上做了很大改进。在随后几年GoogLeNet经历了从v1、v2、v3、v4几个版本的改进过程。本文主要介绍最基础的GoogLeNet v1网络架构。 1. Inception 块的基础结构 **G...

【从零开始学习深度学习】28.卷积神经网络之NiN模型介绍及其Pytorch实现【含完整代码】

前几篇文章介绍的LeNet、AlexNet和VGG在设计上的共同之处是:先以由卷积层构成的模块充分抽取空间特征,再以由全连接层构成的模块来输出分类结果。其中,AlexNet和VGG对LeNet的改进主要在于如何对这两个模块加宽(增加通道数)和加深。本文我们介绍网络中的网络(NiN)。它提出了另外一个思路,即串联多个由卷积层和“全连接”层构成的小网络来构建一个深层网络。 1. N...

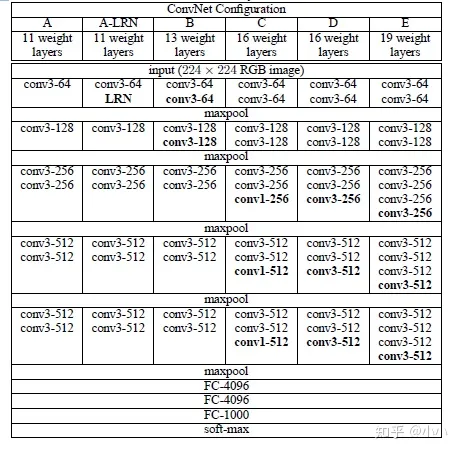

【从零开始学习深度学习】27.卷积神经网络之VGG11模型介绍及其Pytorch实现【含完整代码】

AlexNet在LeNet的基础上增加了3个卷积层。但AlexNet对卷积窗口、输出通道数和构造顺序均做了大量的调整。虽然AlexNet模型表明深度卷积神经网络可以取得出色的结果,但并没有提供相应规则以指导后来的研究者如何设计新的网络。我们将在后续介绍几种不同的深度网络设计思路。 本文将介绍VGG网络模型,VGG主要思路是通过重复使用简单的基础块来构建深度模型。 1. VGG块介...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

pytorch模型相关内容

- 模型pytorch代码

- pytorch ctr模型

- pytorch模型性能

- pytorch训练模型部署

- pytorch训练模型

- pytorch moe模型

- pytorch专家模型

- pytorch代码模型

- pytorch构建模型

- transformer模型pytorch

- pytorch学习笔记模型

- pytorch模型定义

- pytorch优化模型

- pytorch学习率模型

- pytorch transformers模型

- pytorch huggingface模型

- 构建pytorch模型

- pytorch模型优化

- 模型pytorch tensorflow

- modelscope pytorch模型

- 人工智能平台 pai pytorch模型

- pai pytorch模型

- 平台pytorch模型

- pytorch定义模型

- pytorch线性回归模型

- 学习pytorch案例模型

- pytorch实战案例模型

- pytorch预训练模型

- pytorch模型数据集

- 卷积神经网络模型pytorch代码

pytorch更多模型相关

- pytorch模型module

- pytorch模型初始化

- pytorch模型参数

- pytorch模型训练

- pytorch模型加载

- pytorch框架模型

- pytorch模型调优

- pytorch迁移模型

- pytorch学习模型

- 模型pytorch代码实现

- pytorch模型超参数

- pytorch卷积模型

- pytorch模型分类

- pytorch gan模型

- 优化pytorch模型

- 实战pytorch模型

- 代码pytorch模型

- pytorch alexnet模型

- pytorch模型教程

- 机器学习pai pytorch模型

- pytorch案例模型图片

- pytorch模型图像

- pytorch模型超参数调优

- pytorch模型数据

- onnx pytorch模型部署

- pytorch模块模型

- 模型pytorch版本

- 阿里云pytorch模型

- 工具pytorch模型

- pytorch翻译模型

pytorch您可能感兴趣

- pytorch l2

- pytorch代码

- pytorch解析

- pytorch技术

- pytorch图像

- pytorch gat

- pytorch昇腾

- pytorch gemotric

- pytorch vggnet

- pytorch interest

- pytorch神经网络

- pytorch教程

- pytorch实战

- pytorch训练

- pytorch学习

- pytorch数据集

- pytorch tensorflow

- pytorch官方教程

- pytorch安装

- pytorch卷积

- pytorch构建

- pytorch gpu

- pytorch卷积神经网络

- pytorch分类

- pytorch数据

- pytorch源码

- pytorch框架

- pytorch案例

- pytorch学习笔记

- pytorch版本