AIGC使用问题之GPT-1如何优化目标函数,如何做模型微调

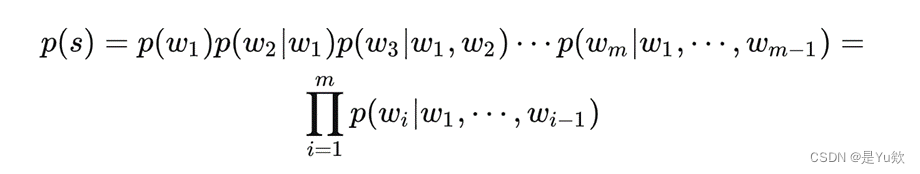

问题一:GPT-1如何优化目标函数?如何做模型微调? GPT-1如何优化目标函数?如何做模型微调? 参考回答: 使用对数最大似然函数来计算loss,并使用transformer的解码器来处理文本数据,其中引入了position embedding来编码位置信息。 GPT-1在微调时使用的是带有标号的数据集。模型根据输入的序列x预测其标号y,对于...

`transformers`库是Hugging Face提供的一个开源库,它包含了大量的预训练模型和方便的API,用于自然语言处理(NLP)任务。在文本生成任务中,`transformers`库提供了许多预训练的生成模型,如GPT系列、T5、BART等。这些模型可以通过`pipeline()`函数方便地加载和使用,而`generate()`函数则是用于生成文本的核心函数。

一、引言 transformers库是Hugging Face提供的一个开源库,它包含了大量的预训练模型和方便的API,用于自然语言处理(NLP)任务。在文本生成任务中,transformers库提供了许多预训练的生成模型,如GPT系列、T5、BART等。这些模型可以通过pipeline()函数方便地加载和使用&...

【网安AIGC专题10.11】论文1:生成式模型GPT\CodeX填充式模型CodeT5\INCODER+大模型自动程序修复(生成整个修复函数、修复代码填充、单行代码生产、生成的修复代码排序和过滤)

写在最前面本文为邹德清教授的《网络安全专题》课堂笔记系列的文章,本次专题主题为大模型。10.11分享论文1:Automated Program Repair in the Era of Large Pre-trained Language Models《llm在程序修复中的应用》马兴宇学长分享论文,深入浅出,简洁明了写博客记录这篇论文的分享论文总结主要是将主流的预训练代码专项的大模型应用到了代码....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。