使用Check节点检查数据源或实时同步任务是否可用

DataWorks的Check节点可用于检查目标对象(MaxCompute分区表、FTP文件、OSS文件、HDFS文件、OSS_HDFS文件以及实时同步任务)是否可用,当Check节点满足检查策略后会返回运行成功状态。如果某任务的运行依赖目标对象,您可使用Check节点检查目标对象,并设置该任务为Check节点的下游任务,当Check节点满足检查策略后,便会运行成功并触发下游任务执行。本文为您介绍...

无需解冻直接实时读取OSS-HDFS服务归档文件

归档直读是指直接访问OSS-HDFS服务中归档存储类型的文件,而无需先对其解冻。归档直读适用于实时读取极少需要访问的数据场景。

访问权限的概念、使用方式及其相关注意事项

文件存储 HDFS 版为目录和文件提供了一种访问权限,该访问权限类似于POSIX文件系统的权限模型。本文简要介绍访问权限的概念、使用方式及其相关注意事项。

实时计算 Flink版操作报错合集之Hadoop在将文件写入HDFS时,无法在所有指定的数据节点上进行复制,该如何解决

问题一:Flink CDC里flinkcdc写hudi的时候这个错误怎么弄? Flink CDC里flinkcdc写hudi的时候这个错误怎么弄? own Source) at org.apache.hadoop.hdfs.DF...

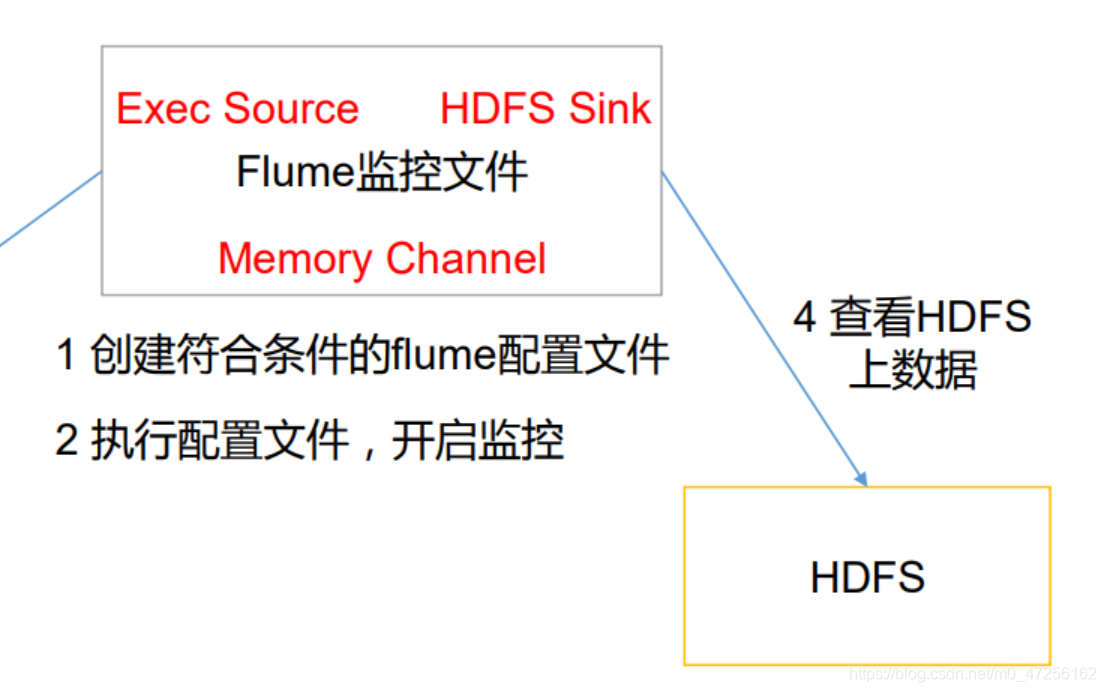

64 Flume采集文件到HDFS

采集需求:比如业务系统使用log4j生成的日志,日志内容不断增加,需要把追加到日志文件中的数据实时采集到hdfs。根据需求,首先定义以下3大要素采集源,即source——监控文件内容更新 : exec ‘tail -F file’下沉目标,即sink——HDFS文件系统 : hdfs sinkSource和sink之间的传递通道——channel,可用file channel 也可以用 内存ch....

请教个问题,FLINK ON YARN默认会把LOG4J以及JAR文件,传到HDFS的/user/H

请教个问题,FLINK ON YARN默认会把LOG4J以及JAR文件,传到HDFS的/user/HADOOP_USER_NAME目录,这个可以修改吗?

实时计算 Flink版keytab文件能放到hdfs吗 还是要放在每个hadoop节点同一目录?

实时计算 Flink版keytab文件能放到hdfs吗 还是要放在每个hadoop节点同一目录?

【Flume中间件】(3)实时监听文件到HDFS系统

实时监听文件到HDFS系统之前测试了监听一个文件的新内容,然后打印到了控制台,现在我们需要将监控到的内容放到HDFS中进行存储,其实和控制台一样,只不过是将sink源改到HDFS,修改一下相关的配置。a1.sources = r1 a1.sinks = k1 a1.channels = c1 a1.sources.r1.type = exec a1.sources.r1.command=tail....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

文件存储HDFS版文件相关内容

- 文件存储HDFS版文件路径

- 文件存储HDFS版下载文件

- 文件存储HDFS版文件文件夹

- java文件存储HDFS版文件

- 文件存储HDFS版读写文件

- 文件存储HDFS版文件put

- 文件存储HDFS版代码文件

- 文件存储HDFS版命令行文件

- 文件存储HDFS版文件列表

- 文件存储HDFS版集群文件

- 客户端访问文件存储HDFS版文件

- 访问文件存储HDFS版文件

- 客户端文件存储HDFS版文件

- mapreduce文件存储HDFS版文件

- 文件存储HDFS版接口文件

- 文件存储HDFS版文件方法

- hive文件存储HDFS版文件

- 文件存储HDFS版core-site.xml文件

- 文件存储HDFS版文件读写

- 文件存储HDFS版文件mapreduce

- flume目录文件文件存储HDFS版

- 文件存储HDFS版文件设置

- 文件存储HDFS版文件映射

- 文件存储HDFS版文件hive

- flume文件文件存储HDFS版

- 阿里云文件存储HDFS版文件

- 文件存储HDFS版文件配置

- 开发文件存储HDFS版文件

- 技术文件存储HDFS版文件

- 技术实验文件存储HDFS版文件

文件存储HDFS版更多文件相关

- 文件存储HDFS版parquet文件

- 分布式文件系统文件存储HDFS版文件

- 文件存储HDFS版导入文件

- 文件存储HDFS版目录文件

- 文件存储HDFS版文件part

- 文件文件存储HDFS版目录

- 文件存储HDFS版文件策略

- 文件存储HDFS版清理文件

- 文件文件存储HDFS版系统

- flume文件存储HDFS版文件

- 文件存储HDFS版文件解决方案

- spark文件存储HDFS版文件

- 文件存储HDFS版文件学习笔记

- 文件存储HDFS版文件oss

- 文件存储HDFS版文件流程

- 文件存储HDFS版存储文件

- 运行文件存储HDFS版文件

- 文件存储HDFS版文件数据

- 文件存储HDFS版文件步骤

- flume实时监控文件文件存储HDFS版

- 配置文件存储HDFS版文件

- 文件存储HDFS版fsimage文件

- 文件存储HDFS版文件分块

- 文件存储HDFS版文件代码

- 目录文件文件存储HDFS版文件

- 迁移文件存储HDFS版文件

- 文件存储HDFS版文件对象

- 文件文件存储HDFS版文件系统

- 文件存储HDFS版文件yarn

- 文件存储HDFS版文件磁盘

文件存储HDFS版您可能感兴趣

- 文件存储HDFS版数据

- 文件存储HDFS版数据源

- 文件存储HDFS版集成

- 文件存储HDFS版数据集成

- 文件存储HDFS版功能

- 文件存储HDFS版下载

- 文件存储HDFS版文件夹

- 文件存储HDFS版自定义

- 文件存储HDFS版路径

- 文件存储HDFS版架构

- 文件存储HDFS版hadoop

- 文件存储HDFS版flink

- 文件存储HDFS版操作

- 文件存储HDFS版大数据

- 文件存储HDFS版集群

- 文件存储HDFS版命令

- 文件存储HDFS版存储

- 文件存储HDFS版api

- 文件存储HDFS版hive

- 文件存储HDFS版java

- 文件存储HDFS版分布式文件系统

- 文件存储HDFS版目录

- 文件存储HDFS版节点

- 文件存储HDFS版文件存储

- 文件存储HDFS版mapreduce

- 文件存储HDFS版配置

- 文件存储HDFS版报错

- 文件存储HDFS版namenode

- 文件存储HDFS版读取

- 文件存储HDFS版原理