【自然语言处理NLP】Bert预训练模型、Bert上搭建CNN、LSTM模型的输入、输出详解

一、BertModel的输入和输出 from transformers import BertModel bert=BertModel.from_pretrained('bert-base-chinese') out=bert(context, attention_mask=mask)...

【自然语言处理NLP】Bert中的特殊词元表示

在BERT中,<cls>和<sep>是特殊的词元(token),用于在输入序列中标记特定的位置和边界。 <cls>:它是表示序列开头的特殊词元,全称为"classification"。在BERT中,输入序列的第一个位置被标记为<cls>,用于表示整个序列的概括信息。在训练过程中,BERT模型学习使用<cls>...

训练你自己的自然语言处理深度学习模型,Bert预训练模型下游任务训练:情感二分类

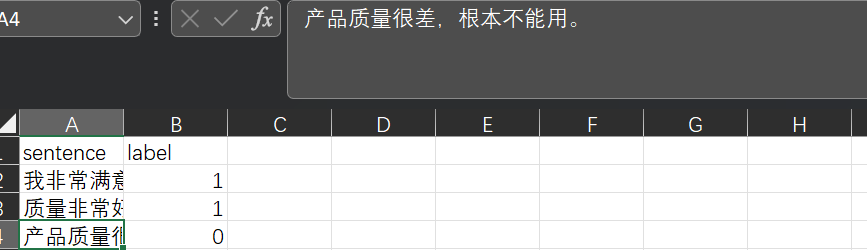

基础介绍:Bert模型是一个通用backbone,可以简单理解为一个句子的特征提取工具更直观来看:我们的自然语言是用各种文字表示的,经过编码器,以及特征提取就可以变为计算机能理解的语言了下游任务:提取特征后,我们便可以自定义其他自然语言处理任务了,以下是一个简单的示例(效果可能不好,但算是一个基本流程)数据格式:模型训练:我们来训练处理句子情感分类的模型,代码如下import torch fro....

掌握 BERT:自然语言处理 (NLP) 从初级到高级的综合指南(2)

BERT的先进技术 当您精通 BERT 后,就该探索先进技术以最大限度地发挥其潜力。在本章中,我们将深入研究微调、处理词汇外单词、领域适应,甚至从 BERT 中提取知识的策略。 微调策略:掌握适应 微调 BERT 需要仔细考虑。您不仅可以微调最终分类层,还可以微调中间层。这使得 BERT 能够更有效地适应您的特定任务。尝试不同...

掌握 BERT:自然语言处理 (NLP) 从初级到高级的综合指南(1)

简介 BERT(来自 Transformers 的双向编码器表示)是 Google 开发的革命性自然语言处理 (NLP) 模型。它改变了语言理解任务的格局,使机器能够理解语言的上下文和细微差别。在本文中,我们将带您踏上从 BERT 基础知识到高级概念的旅程,并配有解释、示例和代码片段。 BERT简介 什么是 BERT? 在不断发展的自然语言处理 (NLP) 领域,一项名为 BERT 的突...

用于自然语言处理的BERT-双向Transformers的直观解释

在这篇文章中,我们将使用一种直观的方法来理解NLP的发展,包括BERT。预训练策略使BERT如此强大和流行,并且BERT可针对大多数NLP任务进行微调。自然语言处理(NLP)算法的发展考虑一下如果你想学习一门新的语言,印地语。而且你很懂英语。首先是要在已知语言的上下文中理解新语言中每个单词的含义。您还将了解该语言的同义词和反义词,以获得更多的词汇量。这将帮助您理解语义或含义相关关系。这是Word....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。