StockMixer:上海交大推出预测股票价格的 MLP 架构,通过捕捉指标、时间和股票间的复杂相关性,预测下一个交易日的收盘价

❤️ 如果你也关注 AI 的发展现状,且对 AI 应用开发非常感兴趣,我会每日跟你分享最新的 AI 资讯和开源应用,也会不定期分享自己的想法和开源实例,欢迎关注我哦! 微信公众号|搜一搜:蚝油菜花 快速阅读 架构:基于多层感知器(MLP),通过指标、时间和股票混合处理股票数据。 功能:捕捉股票指标、时间和股票间的复杂相关性,预测下一个交易日的收盘价。 应用:适用于量化投资、风险管...

TSMixer:谷歌发布的用于时间序列预测的全新全mlp架构

研究人员将TSMixer与各种Transformer模型进行了比较(后者输给了TSMixer)。但是当引入一个令人尴尬的简单线性模型DLinear作为Dynamic Model Selection (DMS), 预测基线进行比较。结果表明,在大多数情况下,DLinear在9个广泛使用的基准测试中也优于现有的基于transformer的解决方案,并且通常有很大的优势,所以目前来看Transform....

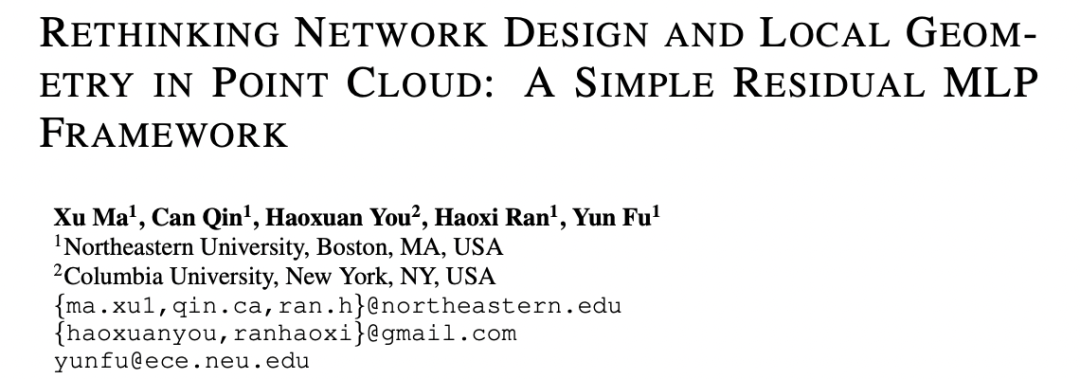

ICLR 2022 | 纯MLP的点云网络:新架构PointMLP大幅提高点云分类准确率和推理速度

来自美国东北大学 SmileLab,哥伦比亚大学的研究者提出一种纯 MLP 的点云网络架构 PointMLP,在 ModelNet40、ScanObjectNN 等点云数据集上取得了非常好的结果,并大幅提升了推理速度。3D 点云数据由于其无序性 (unorderness)、稀疏性(sparisity)和不规则性(irregularity)等特点,往往难以处理。为了描述 3D 数据的几何特征,研究....

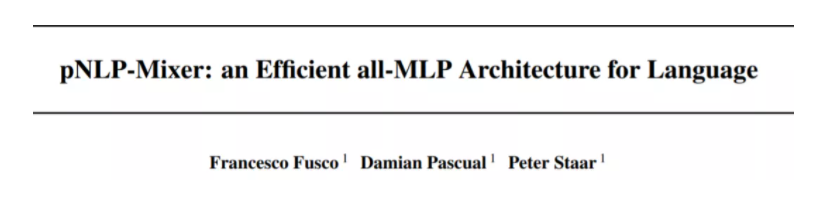

CV之后,纯MLP架构又来搞NLP了,性能媲美预训练大模型

搞不起大模型,试一下超高性能的纯 MLP 架构?去年来自谷歌大脑的研究团队在网络架构设计方面挖出新坑,提出 MLP-Mixer ,这是一个纯 MLP 构建的视觉架构。该架构无需卷积、注意力机制,仅需 MLP,在 ImageNet 数据集上就实现了媲美 CNN 和 ViT 的性能表现。之后清华大学等机构的研究者先后将纯 MLP 用于构建视觉架构和新的注意力机制,这些研究将 CV 的研究重心重新指向....

CycleMLP:一种用于密集预测的mlp架构

MLP-Mixer, ResMLP和gMLP,其架构与图像大小相关,因此在目标检测和分割中是无法使用的。而CycleMLP有两个优点。(1)可以处理各种大小的图像。(2)利用局部窗口实现了计算复杂度与图像大小的线性关系。Cycle FCCycle Fully-Connected Layer (Cycle FC) 和 Channel FC 、Spatial FC比较Channel FC:在空间大小....

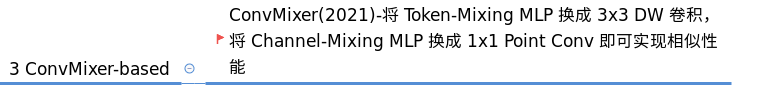

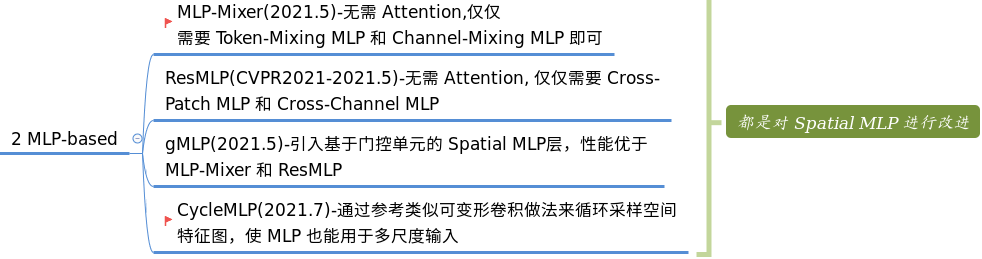

Vision Transformer 必读系列之图像分类综述(三): MLP、ConvMixer 和架构分析(下)

2. ConvMixer-basedConvMixer 的含义是:不包括自注意力层不包括 Spatial Mixer MLP 层包括 Channel Mixer 层,这个层可以是 1x1 的点卷积,或者 MLP 层因为 Channel Mixer MLP 层和 1x1 卷积完全等价,所以这里所说的 ConvMixer-based 是强调 Spatial Mixer 层模块可以替换为 DW 卷积(....

Vision Transformer 必读系列之图像分类综述(三): MLP、ConvMixer 和架构分析(上)

1. MLP-based在 Vision Transformer 大行其道碾压万物的同时,也有人在尝试非注意力的 Transformer 架构(如果没有注意力模块,那还能称为 Transformer 吗)。这是一个好的现象,总有人要去开拓新方向。相比 Attention-based 结构,MLP-based 顾名思义就是不需要注意力了,将 Transformer 内部的注意力计算模块简单替换为 ....

CV之后,纯MLP架构又来搞NLP了,性能媲美预训练大模型

去年来自谷歌大脑的研究团队在网络架构设计方面挖出新坑,提出 MLP-Mixer ,这是一个纯 MLP 构建的视觉架构。该架构无需卷积、注意力机制,仅需 MLP,在 ImageNet 数据集上就实现了媲美 CNN 和 ViT 的性能表现。之后清华大学等机构的研究者先后将纯 MLP 用于构建视觉架构和新的注意力机制,这些研究将 CV 的研究重心重新指向 MLP。众多研究者纷纷感叹:CV 领域网络架构....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

金融级分布式架构

SOFAStack™(Scalable Open Financial Architecture Stack)是一套用于快速构建金融级分布式架构的中间件,也是在金融场景里锤炼出来的最佳实践。

+关注