MaxCompute产品使用合集之启用hive兼容的时候,某个字段是null,是否会把这个字段当成空白连起来

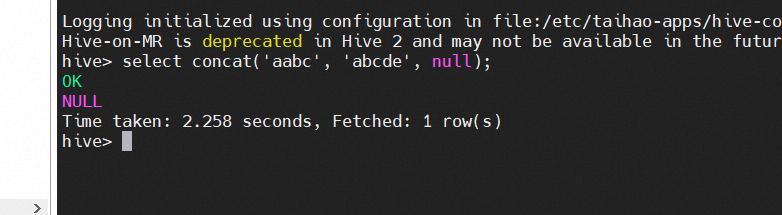

问题一:大数据计算MaxCompute我开启了hive兼容,但是这个和hive、spark的有差异,为什么? 大数据计算MaxCompute我开启了hive兼容,但是这个和hive、spark的有差异,这个函数我其它两个产品都用过,别人都是连起来的字段如果中间某个字段是null,是用空白替换,整个字段数量是不变的,结果MC这里导致字段数量少了,非得加nvl判断下。。。 ...

Hive操作超时错误:Session 0x0 for server null

1 Hive错误[HiveServer2-Background-Pool: Thread-69-SendThread(quickstart.cloudera:2181)]: Session 0x0 for server null, unexpected error, closing socket connection and attempting reconnect java.net.Con...

hive get_json_object解析json结果为null咋办?

前言最近一位开发的同学在使用get_json_object函数对json数据解析的时候,出现了结果为null的问题,问题原因是sql语法导致的,那么今天就来详细介绍一下解析json函数的用法!一、了解hive中处理json的两个函数1. get_json_object函数先看看这个函数具体是如何定义的:执行命令:desc function extended get_json_object;执行结....

Hive分区表的新增字段数据为null的问题解决方法

问题背景假如我们有一个分区表名为partition_table,对该表执行如下添加字段new_c的sql语句:alter table partition_table add columns(new_c STRING);在查询partition_table通过insert overwrite覆写的历史分区数据时,发现新增字段new_c为null数据!问题原因修改Hive分区表结构以后,元数据库中的....

Hdfs 导入Hive,时间相关的字段 导入后为NULL

CREATE TABLE OFFER_${day_id} ( OFFER_ID BIGINT, ATOM_ACTION_ID BIGINT, PARTY_ID BIGINT, OFFER_SPEC_ID BIGINT, OFFER_NBR STRING, AREA_ID INT, MKT_ACTIVITY_ID BIGINT, START_DT STRING, EN...

【大数据开发运维解决方案】sqoop增量导入oracle/mysql数据到hive时时间字段为null处理

前面几篇文章详细介绍了sqoop全量增量导入数据到hive,大家可以看到我导入的数据如果有时间字段的话我都是在hive指定成了string类型,虽然这样可以处理掉时间字段在hive为空的问题,但是在kylin创建增量cube时需要指定一个时间字段来做增量,所以上面那种方式不行,这里的处理方式为把string改成timestamp类型,看实验:一、源库创建测试表创建测试表:create table....

Hive-加载数据与数据null值处理

Hive加载数据与数据null值处理背景:load数据文件的数据流转的雏形通常是: 业务库 -> 数据文件 -> load进hive -> ods层 这里会面临最基础的两个问题:通常我们需要一个跳板层,即将数据文件Load进stage层(text),然后通过查询加载进ODS层(ORC);数据文件生成时,如果直接使用命令行的形式,字段null值将被直接赋值为'NULL'字符串...

请问一下 从hdfs load数据到hive中 hive数据全部为null是什么情况呢,hdfs数据

请问一下 从hdfs load数据到hive中 hive数据全部为null是什么情况呢,hdfs数据为json格式,hive中只有一个字段

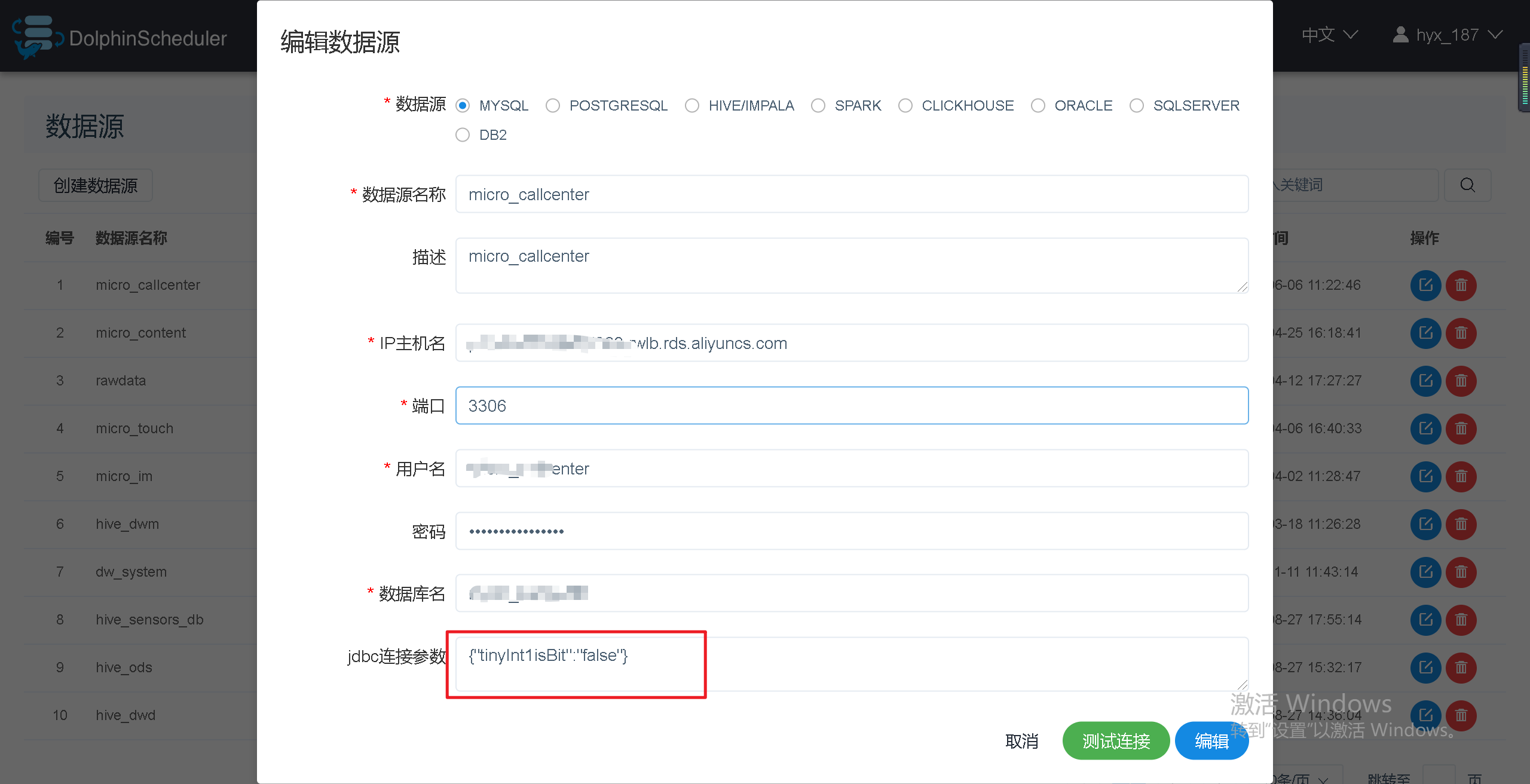

巨坑:Sqoop任务中从MySQL导入tinyint(1)类型数据到hive(tinyint),数据为null

问题描述从Sqoop导入MySQL导入TINYINT(1)类型数据到hive(tinyint),数据为null。问题原因Sqoop在抽取数据到Hive或者HDFS时,会自动将类型为tinyint(1)的列转为boolean类型,这就是导致抽取到Hive或HDFS中的数据中只有0和1的原因。因为默认情况下,MySQL JDBC connector 会将tinyint(1)映射为java.sql.T....

如果采用jdbc连接hive的reader方式不会存在null值转换问题,但是采用jdbc连接介绍里

如果采用jdbc连接hive的reader方式不会存在null值转换问题,但是采用jdbc连接介绍里有说不能自定义并发度;那这个还有设置界面,所以即使改了并发度参数也不生效吗?

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

null您可能感兴趣

- null name

- null图标

- null内存

- null区别

- null空格

- null方法

- null values

- null parameter

- null at

- null优化

- null数据库

- null spring

- null springboot

- null前端

- null产品

- null linux

- null hologres

- null list

- null type

- null实时计算

- null default

- null reference

- null .net

- null数据类型

- null notnull

- null isnull

- null primitive

- null void

- null字符

- null模式