如何配置Kafka输出组件用于向数据源写入数据

Kafka输出组件可以将外部数据库中读取数据写入到Kafka,或从大数据平台对接的存储系统中将数据复制推送至Kafka,进行数据整合和再加工。本文为您介绍如何配置Kafka输出组件。

使用Cluster Linking复制Kafka集群数据

Cluster Linking是Confluent Platform提供的一种功能,用于将多个Kafka集群连接在一起。该功能允许不同的Kafka集群之间进行数据的镜像和复制。Cluster Linking将在数据目标(Destination)集群启动,并复制数据源(Source)集群的数据到目标集群。本文将向您介绍如何使用云消息队列 Confluent 版的Cluster Linking。主要包...

Spark Structured Streaming 和 Kafka 在数据完整性推理上有何不足?

Spark Structured Streaming 和 Kafka Streams 在数据完整性推理上有何不足?

使用Confluent Replicator复制数据

Kafka MirrorMaker是一款用于在两个Apache Kafka集群之间复制数据的独立工具。它将Kafka消费者和生产者连接在一起。从源集群的Topic读取数据,并写入目标集群的同名Topic。相比于Kafka MirrorMaker,Confluent Replicator是一个更完整的解决方案,它能复制Topic的配置和数据,还能与Kafka Connect和Control Cent...

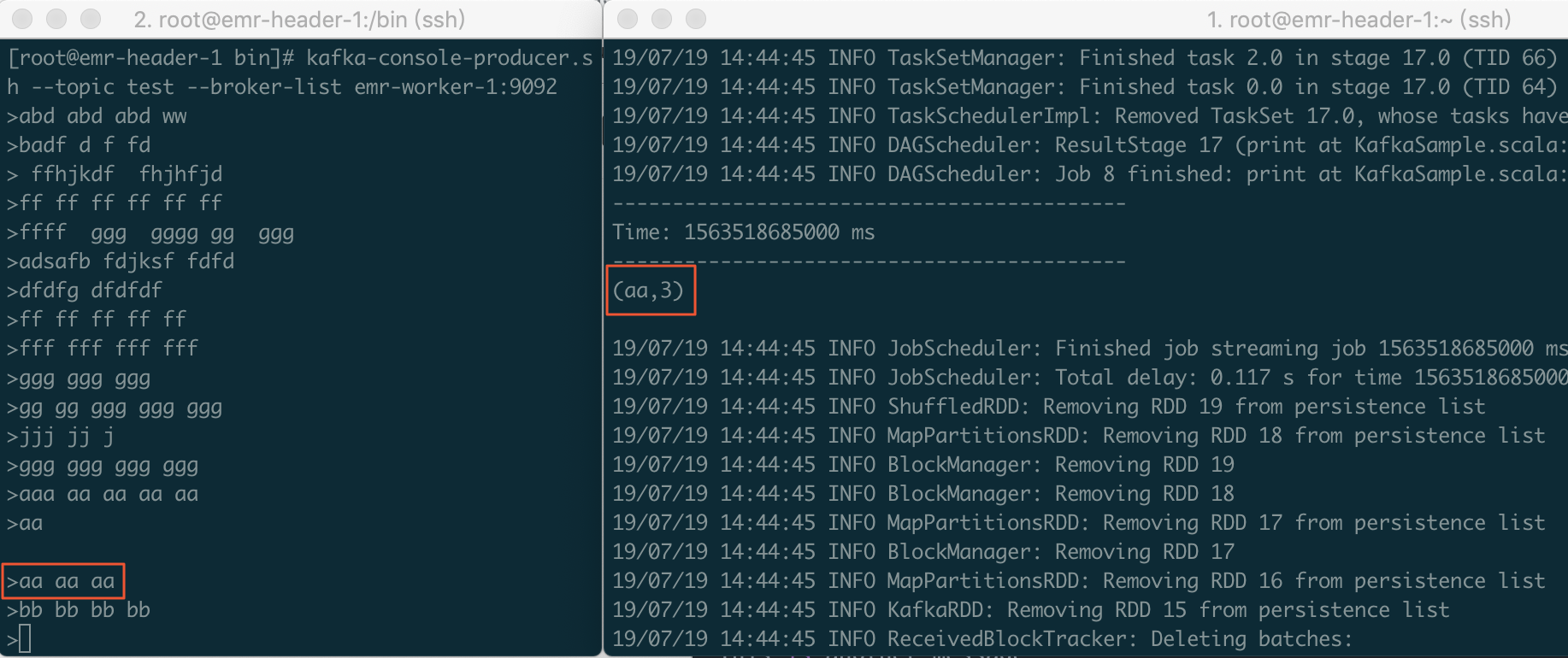

Streaming 消费 kafka 数据的两种方式|学习笔记

开发者学堂课程【大数据实战项目:反爬虫系统(Lua+Spark+Redis+Hadoop框架搭建):Streaming消费kafka数据的两种方式】学习笔记与课程紧密联系,让用户快速学习知识课程地址:https://developer.aliyun.com/learning/course/670/detail/11626Streaming 消费 kafka 数据的两种方式 内容介绍:一....

通过Spark Streaming作业处理Kafka数据

本节介绍如何使用阿里云E-MapReduce部署Hadoop集群和Kafka集群,并运行Spark Streaming作业消费Kafka数据。 前提条件 已注册阿里云账号,详情请参见注册云账号。 已开通E-MapReduce服务。 已完成云账号的授权,详情请参见角色授权。 背景信息 在开发过程中,通常会遇到消费Kafka数据的场景。在阿里云E-MapReduce中,您可通过运行Spark S...

Spark Streaming kafka实现数据零丢失的几种方式

在使用Spark streaming消费kafka数据时,程序异常中断的情况下发现会有数据丢失的风险,本文简单介绍如何解决这些问题。 在问题开始之前先解释下流处理中的几种可靠性语义: 1、At most once - 每条数据最多被处理一次(0次或1次),这种语义下会出现数据丢失的问题; 2、At least once - 每条数据最少被处理一次 (1次或更多),这个不会出现数据丢失,...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

云消息队列 Kafka 版数据相关内容

- 云消息队列 Kafka 版数据磁盘

- 云消息队列 Kafka 版数据计算

- flinksql云消息队列 Kafka 版数据

- 产品云消息队列 Kafka 版数据

- 实时计算flink版云消息队列 Kafka 版数据

- 实时计算云消息队列 Kafka 版数据

- 云消息队列 Kafka 版connector数据

- 云消息队列 Kafka 版数据数组

- 云消息队列 Kafka 版数据调节

- 数据云消息队列 Kafka 版分区有序

- cdc数据云消息队列 Kafka 版

- 数据云消息队列 Kafka 版

- 数据云消息队列 Kafka 版分区

- 同步数据云消息队列 Kafka 版

- 数仓云消息队列 Kafka 版数据

- python云消息队列 Kafka 版数据

- 报错云消息队列 Kafka 版数据

- 云消息队列 Kafka 版数据策略

- 云消息队列 Kafka 版机制数据

- 云消息队列 Kafka 版producer数据

- flinksql数据云消息队列 Kafka 版

- cdc云消息队列 Kafka 版数据配置

- 数据云消息队列 Kafka 版报错

- 云消息队列 Kafka 版数据配置

- 同步云消息队列 Kafka 版数据

- mysql云消息队列 Kafka 版数据

- 云消息队列 Kafka 版数据排查

- 阿里云云消息队列 Kafka 版数据

- 配置云消息队列 Kafka 版数据

- cdc同步云消息队列 Kafka 版数据

云消息队列 Kafka 版更多数据相关

- 云消息队列 Kafka 版数据报错

- 云消息队列 Kafka 版数据格式格式数据

- 云消息队列 Kafka 版格式数据

- 库云消息队列 Kafka 版数据

- 云消息队列 Kafka 版流处理数据

- 云消息队列 Kafka 版数据代码

- 云消息队列 Kafka 版任务数据

- spark云消息队列 Kafka 版数据

- 数据云消息队列 Kafka 版snapshot

- 实时计算flink版数据云消息队列 Kafka 版

- flink云消息队列 Kafka 版数据

- 采集数据云消息队列 Kafka 版

- 云消息队列 Kafka 版数据mysql

- canal数据云消息队列 Kafka 版

- canal云消息队列 Kafka 版数据

- flink云消息队列 Kafka 版同步数据

- 实时计算flink云消息队列 Kafka 版数据

- canal同步数据云消息队列 Kafka 版

- 云消息队列 Kafka 版数据字段

- 云消息队列 Kafka 版数据参数

- 云消息队列 Kafka 版topic数据

- 云消息队列 Kafka 版数据清理

- 云消息队列 Kafka 版订阅数据

- 云消息队列 Kafka 版数据乱序

- 云消息队列 Kafka 版数据延迟

- 捕获数据云消息队列 Kafka 版

- 云消息队列 Kafka 版数据hive

- 连接云消息队列 Kafka 版数据

- flume云消息队列 Kafka 版数据

- 云消息队列 Kafka 版消费数据

云消息队列 Kafka 版您可能感兴趣

- 云消息队列 Kafka 版应用

- 云消息队列 Kafka 版架构

- 云消息队列 Kafka 版场景

- 云消息队列 Kafka 版消费者

- 云消息队列 Kafka 版生产者

- 云消息队列 Kafka 版平台

- 云消息队列 Kafka 版分析

- 云消息队列 Kafka 版分布式

- 云消息队列 Kafka 版实战

- 云消息队列 Kafka 版flink

- 云消息队列 Kafka 版cdc

- 云消息队列 Kafka 版分区

- 云消息队列 Kafka 版集群

- 云消息队列 Kafka 版报错

- 云消息队列 Kafka 版topic

- 云消息队列 Kafka 版配置

- 云消息队列 Kafka 版同步

- 云消息队列 Kafka 版消息队列

- 云消息队列 Kafka 版消费

- 云消息队列 Kafka 版mysql

- 云消息队列 Kafka 版apache

- 云消息队列 Kafka 版安装

- 云消息队列 Kafka 版消息

- 云消息队列 Kafka 版日志

- 云消息队列 Kafka 版sql

- 云消息队列 Kafka 版原理

- 云消息队列 Kafka 版连接

- 云消息队列 Kafka 版解析

- 云消息队列 Kafka 版java

- 云消息队列 Kafka 版入门