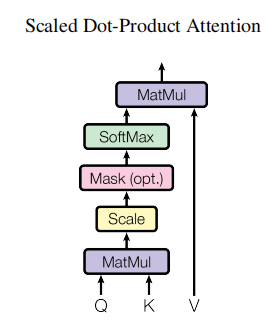

自注意力机制全解析:从原理到计算细节,一文尽览!

引言 自注意力机制的历史背景与发展 自注意力机制(Self-Attention)的概念最早可以追溯到20世纪70年代的神经网络研究,但直到近年来才在深度学习领域得到广泛关注和发展。现代意义上的自注意力机制首次出现在2017年的论文《Attention is All You Need》中,该论文由Google Brain团队提出,...

解码注意力Attention机制:从技术解析到PyTorch实战

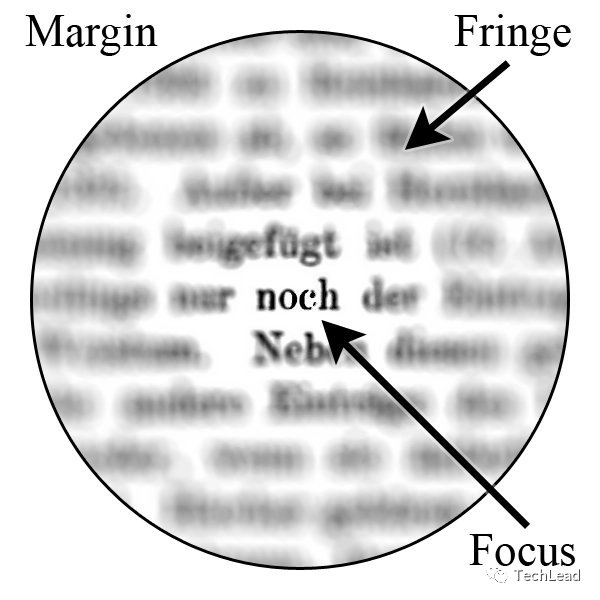

在本文中,我们深入探讨了注意力机制的理论基础和实际应用。从其历史发展和基础定义,到具体的数学模型,再到其在自然语言处理和计算机视觉等多个人工智能子领域的应用实例,本文为您提供了一个全面且深入的视角。通过Python和PyTorch代码示例,我们还展示了如何实现这一先进的机制。关注TechLead,分享AI技术的全维度知识。作者拥有10+年互联网服务架构、AI产品研发经验、团队管理经验,同济本复旦....

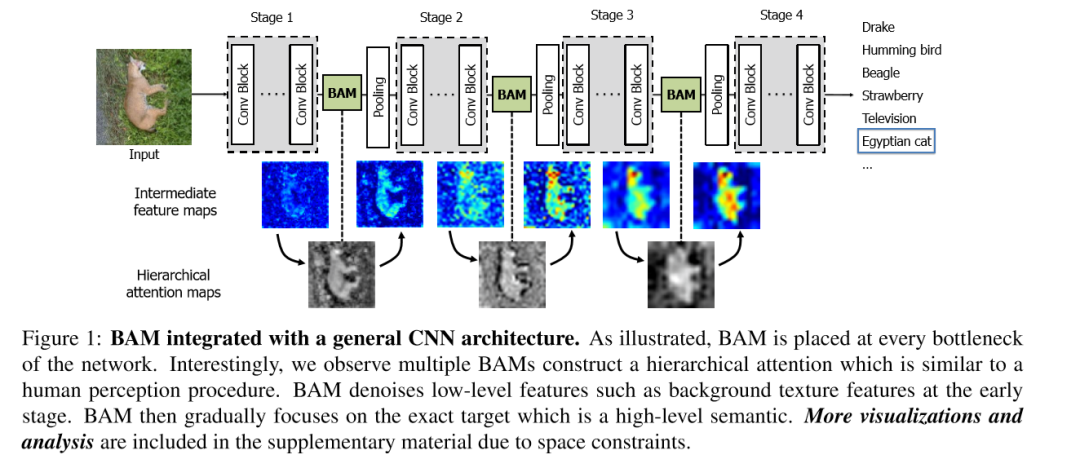

注意力机制BAM和CBAM详细解析(附代码)

论文题目①:BAM: Bottleneck Attention Module论文题目②:CBAM:CBAM: Convolutional Block Attention ModuleBottlenet attention Module(BAM)依据人看东西时不可能把注意力放在所有的图像上,会把焦点目光聚集在图像的重要物体上。因此,作者提出了BAM注意力机制,仿照人的眼睛聚焦在图像几个重要的点上。....

注意力的动画解析(以机器翻译为例)

本文为 AI 研习社编译的技术博客,原标题 : Attn: Illustrated Attention 作者 | Raimi Karim 翻译 | yata 校对 | 邓普斯•杰弗 审核 | 酱番梨 整理 | Pita 原文链接: https...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

云解析DNS您可能感兴趣

- 云解析DNS go语言

- 云解析DNS go

- 云解析DNS ip

- 云解析DNS大模型

- 云解析DNS文档

- 云解析DNS上线

- 云解析DNS防火墙

- 云解析DNS软件

- 云解析DNS图片

- 云解析DNS环境变量

- 云解析DNS域名

- 云解析DNS源码

- 云解析DNS java

- 云解析DNS阿里云

- 云解析DNS解析

- 云解析DNS服务器

- 云解析DNS dns

- 云解析DNS应用

- 云解析DNS json

- 云解析DNS备案

- 云解析DNS配置

- 云解析DNS网站

- 云解析DNS数据

- 云解析DNS linux

- 云解析DNS访问

- 云解析DNS设置

- 云解析DNS xml

- 云解析DNS android

- 云解析DNS原理

- 云解析DNS python