经典神经网络论文超详细解读(五)——ResNet(残差网络)学习笔记(翻译+精读+代码复现)

前言《Deep Residual Learning for Image Recognition》这篇论文是何恺明等大佬写的,在深度学习领域相当经典,在2016CVPR获得best paper。今天就让我们一起来学习一下吧!论文原文:https://arxiv.org/abs/1512.03385前情回顾:经典神经网络论文超详细解读(一)——AlexNet学习笔记(翻译+精读)经典神经网络论文超详....

计算机视觉论文速递(四)Dynamic Sparse R-CNN:Sparse R-CNN升级版,使用ResNet50也能达到47.2AP

Dynamic Sparse R-CNN论文:Dynamic Sparse R-CNN代码目前未开源1. 摘要 Sparse R-CNN是最近的一种强目标检测Baseline,通过对稀疏的、可学习的proposal boxes和proposal features进行集合预测。在这项工作中提出了2个动态设计来改进Sparse R-CNN。 首先,Sparse R-CNN采用....

深度学习论文阅读图像分类篇(五):ResNet《Deep Residual Learning for Image Recognition》

Abstract 摘要 Deeper neural networks are more difficult to train. We present a residual learning framework to ease the training of networks that are substantially deeper than those used previousl....

【论文泛读】 ResNeXt:深度神经网络的聚合残差变换(ResNet的改进,提出了一种新的维度)

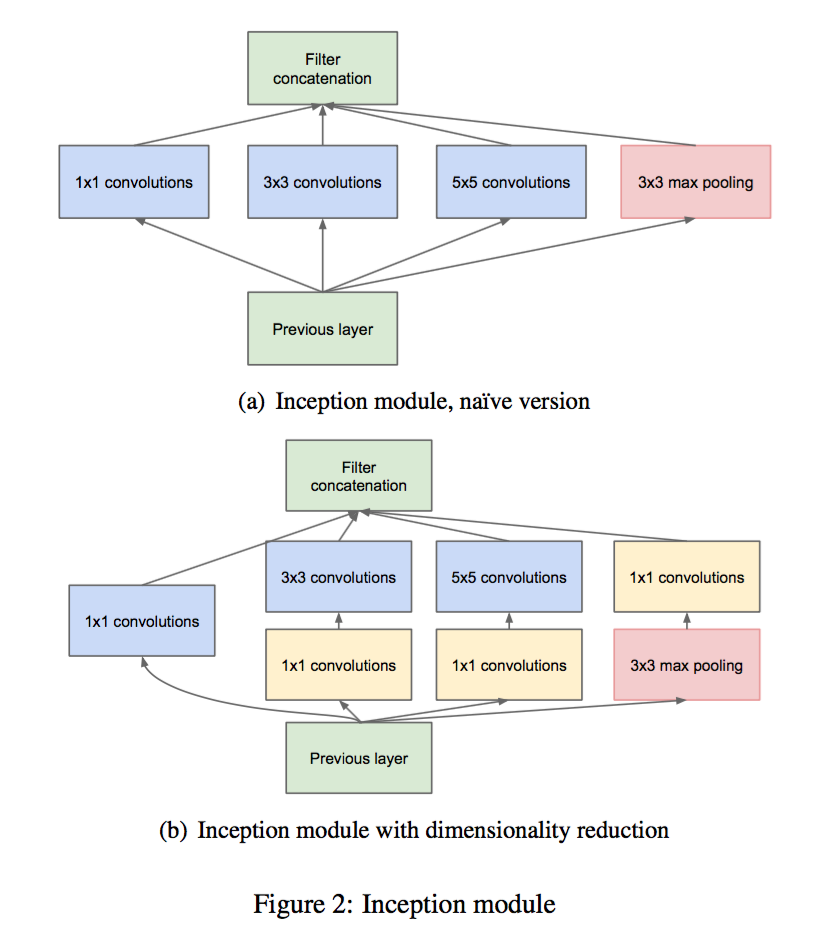

主要思想简单来说呢,随着很多SOTA模型的出现,从一开始的“特征工程”慢慢地转入了一些“网络工程”,引入了一些新的结构和方法。在前面说过的网络中呢,VGG作为一种经典的模型,他提出了堆叠相同块(stacking block)的策略,在VGG中是3x3卷积核不断堆叠,并且也通过增加深度提高了准确率。除此之外,Inception系列网络提出了split-transform-merge的策略,通过多分....

【论文泛读】 ResNet:深度残差网络

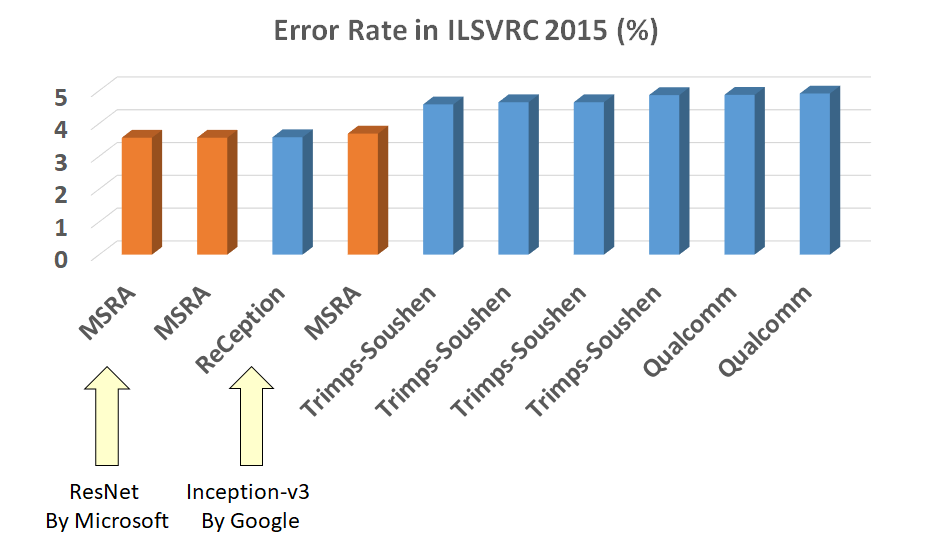

当大家还在惊叹 GoogLeNet 的 inception 结构的时候,微软亚洲研究院的研究员已经在设计更深但结构更加简单的网络 ResNet,并且凭借这个网络子在 2015 年 ImageNet 比赛上大获全胜,除此之外,在那时的五个比赛都拿了第一名接下来我们仔细阅读以下这篇论文摘要 Abstract更深的神经网络更难训练。我们提出了一个残差学习框架,以简化比以前使用的网络更深的网络的训练。我....

论文笔记系列:主干网络(一)-- ResNet

论文结构摘要: 深度网络训练难;残差网络可训练1000层网络;成就。1. Introduction: 提出深层网络存在模型退化问题;分析问题并提出残差学习策略、2. Related Work: 列举残差学习应用例子;单独用一段对比Highway Network。3. Deep Residual Learning: Residual learning; identity learning;Netw....

深度学习第19讲:CNN经典论文研读之残差网络ResNet及其keras实现

在 VGG 网络论文研读中,我们了解到卷积神经网络也可以进行到很深层,VGG16 和 VGG19 就是证明。但卷积网络变得更深呢?当然是可以的。深度神经网络能够从提取图像各个层级的特征,使得图像识别的准确率越来越高。但在2014年和15年那会儿,将卷积网络变深且取得不错的训练效果并不是一件容易的事。 深度卷积网络一开始面临的最主要的问题是梯度消失和梯度爆炸。那什么是梯度消失和梯度爆炸呢?所谓梯.....

AI论文激增,出现引用10万+的ResNet是好是坏?这研究有结论了

当一个领域的规模越来越大,每年发表的论文越多越多时,对于该领域来说,是好事还是坏事呢?一周前,计算机视觉领域经典之作、何恺明的 ResNet 论文的被引次数突破了 10 万 +,而这距离他提交这篇论文仅过去六年。这一工作的热度如此之高,既显示出了 ResNet 本身的久经考验,也印证了 AI 领域,特别是计算机视觉如今的火热程度。然而,ResNet 高被引的背后也让我们看到了一个问题,那就是计算....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

ResNet您可能感兴趣

- ResNet模型

- ResNet图像

- ResNet分类

- ResNet networks

- ResNet resnet

- ResNet深度学习

- ResNet应用

- ResNet原理

- ResNet网络

- ResNet图像识别

- ResNet pytorch

- ResNet训练

- ResNet入门

- ResNet图像分类

- ResNet神经网络

- ResNet结构

- ResNet数据集

- ResNet mobilenet

- ResNet densenet

- ResNet部署

- ResNet复现

- ResNet任务

- ResNet优化

- ResNet算法

- ResNet vit

- ResNet参数

- ResNet块

- ResNet机器学习

- ResNet代码

- ResNet简介