使用Hadoop命令操作OSS/OSS-HDFS

在使用阿里云EMR Serverless Spark的Notebook时,您可以通过Hadoop命令直接访问OSS或OSS-HDFS数据源。本文将详细介绍如何通过Hadoop命令操作OSS/OSS-HDFS。

如何通过ES-Hadoop实现Spark读写阿里云Elasticsearch数据

Spark是一种通用的大数据计算框架,拥有Hadoop MapReduce所具有的计算优点,能够通过内存缓存数据为大型数据集提供快速的迭代功能。与MapReduce相比,减少了中间数据读取磁盘的过程,进而提高了处理能力。本文介绍如何通过ES-Hadoop实现Hadoop的Spark服务读写阿里云Elasticsearch数据。

如何在EMR的Hadoop集群中运行Spark作业对接DataHub数据_EMR on ECS_开源大数据平台 E-MapReduce(EMR)

本文介绍如何在E-MapReduce的Hadoop集群,运行Spark作业消费DataHub数据、统计数据个数并打印出来。

Hadoop概念学习系列之2分钟读懂大数据框架Hadoop和Spark的异同(十七)

谈到大数据,相信大家对Hadoop和Apache Spark这两个名字并不陌生。但我们往往对它们的理解只是提留在字面上,并没有对它们进行深入的思考,下面不妨跟我一块看下它们究竟有什么异同。 解决问题的层面不一样 首先,Hadoop和Apache Spark两者都是大数据框架,但是各自存在的目的不尽相同。Hadoop实质上更多是一个分布式数据基础设施: 它将巨大的数据...

Hadoop概念学习系列之Java调用Shell命令和脚本,致力于hadoop/spark集群(三十六)

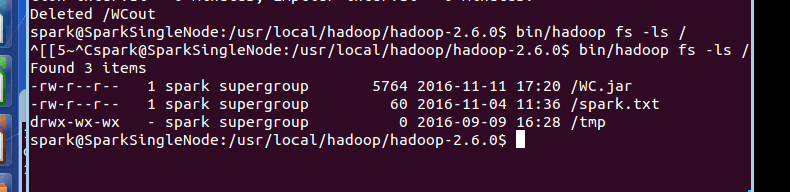

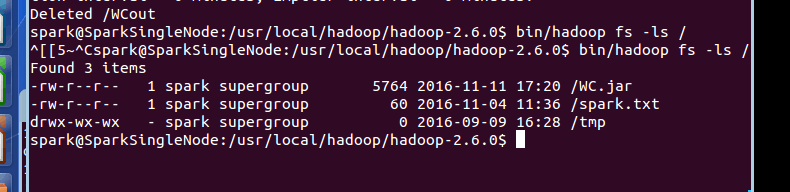

第一种:普通做法 首先,编号写WordCount.scala程序。 然后,打成jar包,命名为WC.jar。比如,我这里,是导出到windows桌面。 其次,上传到linux的桌面,再移动到hdfs的/目录。 最后,在spark安装目录的bin下,执行 spark-submit \ > --class cn.spark.stud...

Hadoop概念学习系列之Java调用Shell命令和脚本,致力于hadoop/spark集群(三十六)

前言 说明的是,本博文,是在以下的博文基础上,立足于它们,致力于我的大数据领域! http://kongcodecenter.iteye.com/blog/1231177 http://blog.csdn.net/u010376788/article/details/51337312 http://blog.csdn.net/arkblue/article/details/7897396 &n...

Hadoop概念学习系列之为什么hadoop/spark执行作业时,输出路径必须要不存在?(三十九)

很多人只会,但没深入体会和想为什么要这样? 拿Hadoop来说,当然,spark也一样的道理。 输出路径由Hadoop自己创建,实际的结果文件遵守part-nnnn的约定。 如何指定一个已有目录作为Hadoop作业的输出路径,作业将无法进行,并会抛出异常抗议一个已经存在的目录。如果想让Hadoop将输出存储到一个目录,它必须是不存的目录。其实,我们可以把这个特点当做Hadoop的一....

Hadoop概念学习系列之谈hadoop/spark里为什么都有,键值对呢?(四十)

很少有人会这样来自问自己?只知道,以键值对的形式处理数据并输出结果,而没有解释为什么要以键值对的形式进行。 包括hadoop的mapreduce里的键值对,spark里的rdd里的map等。 这是为什么呢? 1、键值对的具体含义 首先,我们会通过强调Java标准库中的类似概念,来阐明我们所说的键值对的含义。 java.util.Map接口是常用类,如HashMap,甚至原始Ha....

Hadoop概念学习系列之谈hadoop/spark里为什么都有,YARN呢?(四十一)

在Hadoop集群里,有三种模式: 1、本地模式 2、伪分布模式 3、全分布模式 在Spark集群里,有四种模式: 1、local单机模式 结果xshell可见: ./bin/spark-submit --class org.apache.spark.examples.SparkPi --master local[1] ./lib/spark-exam...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

hadoop spark相关内容

- hadoop spark大数据处理

- 数据湖hadoop spark

- 技术hadoop spark

- spark模式hadoop

- 大数据spark hadoop

- spark部署hadoop

- spark hadoop mapreduce

- spark hadoop wordcount单词计数实例

- 大数据技术hadoop spark

- maxcompute spark hadoop

- hadoop spark flink

- 分布式hadoop spark

- hadoop spark数据处理

- spark hadoop分布式

- hadoop hive spark

- hadoop spark数据

- hadoop spark hive

- hadoop spark组件

- hadoop spark概念

- hadoop spark安装

- hadoop spark实战源码

- hadoop spark原理

- hadoop spark hbase

- 云计算hadoop spark

- spark hadoop pdf

- hadoop spark异同

- spark编译hadoop

- spark hadoop scala

- hadoop spark hive数据

- storm spark hadoop

hadoop更多spark相关

- spark hadoop框架

- hadoop zookeeper spark

- hadoop spark步骤

- hadoop spark分布式

- hadoop spark standalone

- hadoop实战spark

- hadoop spark案例

- hadoop summit tokyo apache spark

- spark summit hadoop

- spark hadoop参数

- spark与hadoop大数据分析hadoop spark

- hadoop学习spark

- hadoop storm spark

- hadoop ha spark

- hadoop spark mesos

- hadoop大数据平台spark

- hadoop summit tokyo spark扩展

- hadoop yarn spark

- spark学习hadoop

- spark hadoop解决方案

hadoop您可能感兴趣

- hadoop开发环境

- hadoop hbase

- hadoop集群

- hadoop数据处理

- hadoop数据分析

- hadoop入门

- hadoop系统

- hadoop技术

- hadoop大数据

- hadoop集群管理

- hadoop hdfs

- hadoop安装

- hadoop配置

- hadoop mapreduce

- hadoop分布式

- hadoop数据

- hadoop文件

- hadoop学习

- hadoop yarn

- hadoop hive

- hadoop命令

- hadoop运行

- hadoop节点

- hadoop搭建

- hadoop部署

- hadoop报错

- hadoop实战

- hadoop概念

- hadoop启动

- hadoop操作