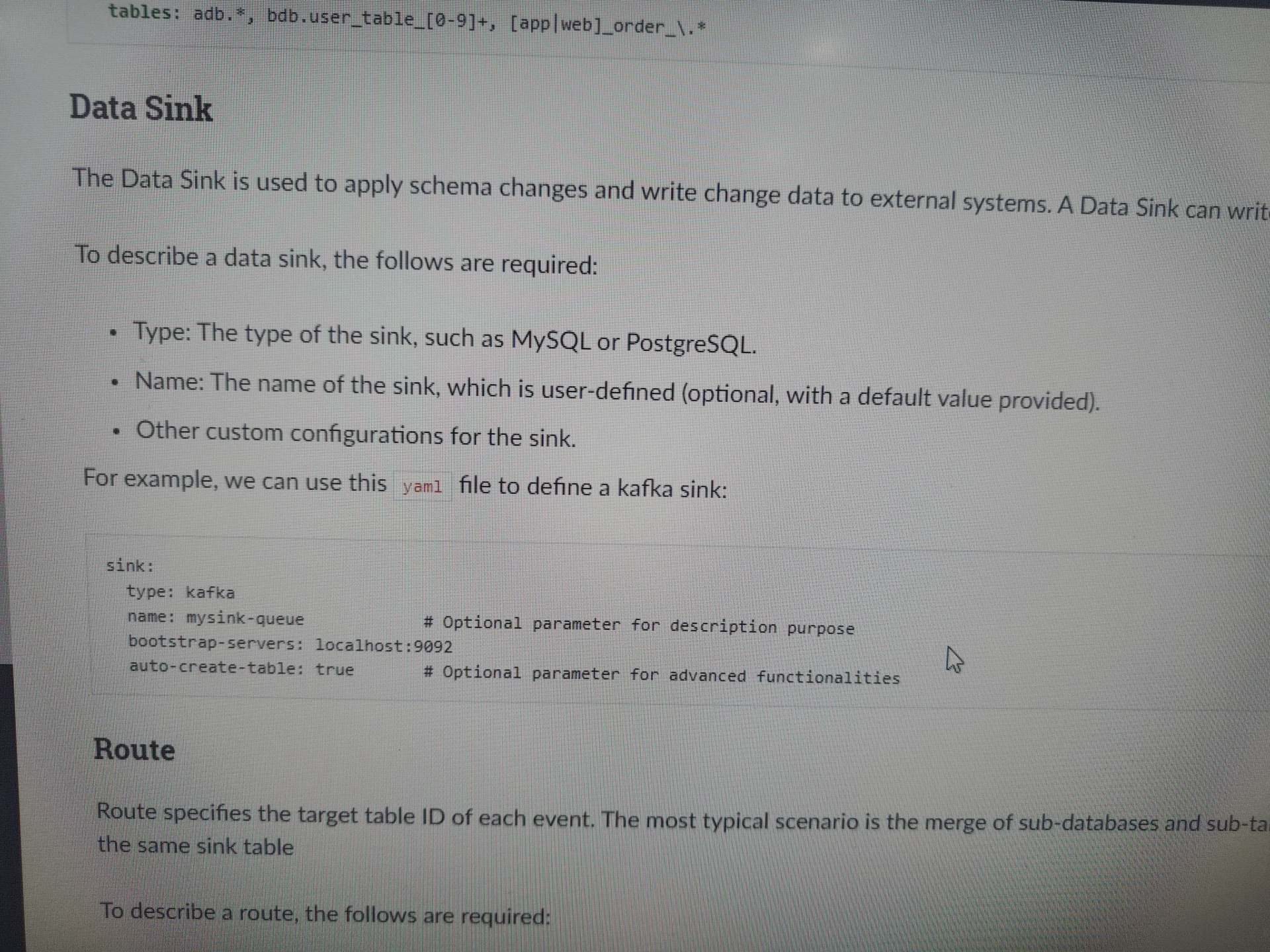

如何配置Kafka输出组件用于向数据源写入数据

Kafka输出组件可以将外部数据库中读取数据写入到Kafka,或从大数据平台对接的存储系统中将数据复制推送至Kafka,进行数据整合和再加工。本文为您介绍如何配置Kafka输出组件。

实时计算 Flink版产品使用问题之如何使用Kafka Connector将数据写入到Kafka

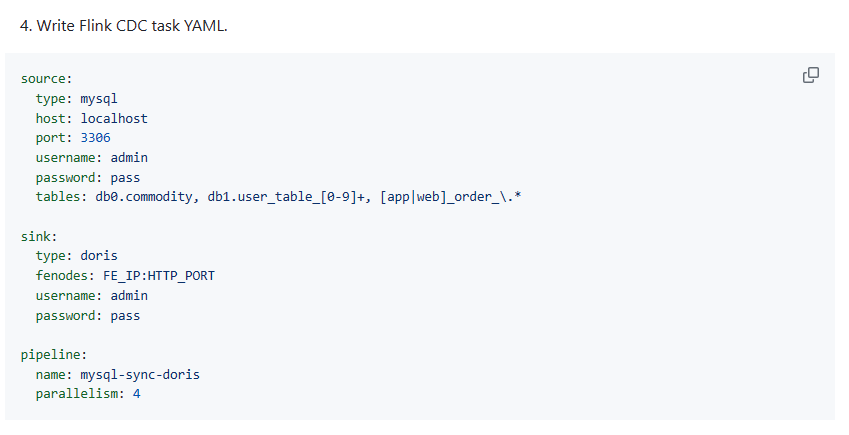

问题一:Flink CDC里之前用mysql数据库join比较慢,这种join性能会比较好吗? Flink CDC里之前用mysql数据库join比较慢,所以才改成同步宽表到es,不知道doris,starorcks 这种join性能会比较好吗? 参考答案: Flink CDC 主要用于捕获和处理数据库变更数据流,而不是直接优化JOIN操作。MySQL...

实时计算 Flink版产品使用问题之处理Kafka数据顺序时,怎么确保事件的顺序性

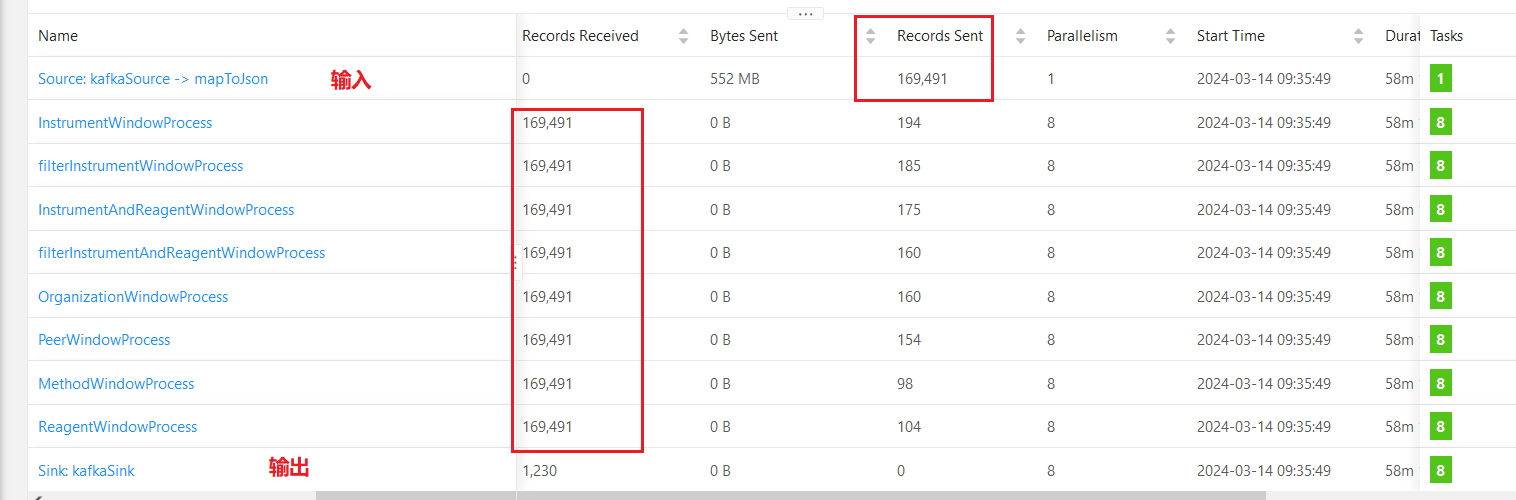

问题一:Flink CDC里从kafka消费的时候顺序会乱,这时候就无法区分顺序了,这种情况有办法处理吗? Flink CDC里从kafka消费的时候顺序会乱,这时候就无法区分顺序了,这种情况有办法处理吗?flink开窗排序可以解决,但遇到两个操作时间在同一时刻的咋办呢,有其它字段可以作标识区分吗?flink cdc到kafka是顺序的,但如果其中一条消息出现失败后重试,不会出现顺序问题...

实时计算 Flink版产品使用问题之建了一张upsert-kafka的flink表,但是数据为空,该如何排查

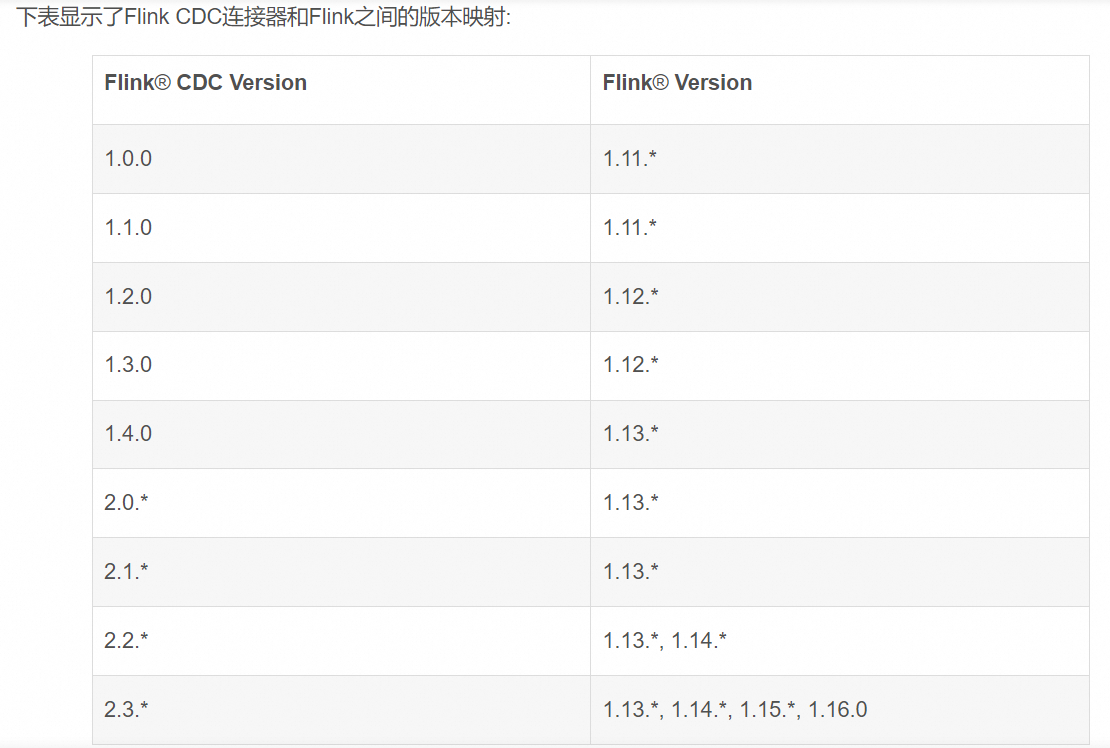

问题一:FlinkCDC版本映射的图有吗? FlinkCDC版本映射的图有吗? 参考答案: 如下图 关于本问题的更多回答可点击进行查看: https:/...

实时计算 Flink版产品使用问题之如何实现两个阿里云账号下的Kafka进行数据的互相传输

问题一:大佬们,flink怎么使用呢?项目空间创建好了,点进去啥也没有。 大佬们,flink怎么使用呢?项目空间创建好了,点进去啥也没有。 参考答案: 参考这个找 owner 授权使用 ...

实时计算 Flink版产品使用问题之配置了最大连续失败数不为1,在Kafka的精准一次sink中,如果ck失败了,这批数据是否会丢失

问题一:Flink如果我配置了最大连续失败数不为 1 那么如果我 ck 失败了 我这批数据会丢失吗? Flink中kafka 的精准一次 sink 如果我配置了最大连续失败数不为 1 那么如果我 ck 失败了 我这批数据会丢失吗? 参考答案: 如果你配置了最大连续失败数不为1,那么在Flink中Kafka的精准一次sink中,如果ck失败了,这批数据不...

实时计算 Flink版产品使用问题之kafka2hive同步数据时,如何回溯历史数据

问题一:flink中,join如果不指定窗口,会把join结果一直存储下来吗? flink中,join如果不指定窗口,会把join结果一直存储下来吗? 参考答案: Apache Flink 中,如果不指定窗口进行 join,join 结果不会无限期地存储下来。在无窗口的情况下进行 join,Flink 会根据数据流的到达顺序和关联键进行即时 join。...

实时计算 Flink版产品使用问题之 从Kafka读取数据,并与两个仅在任务启动时读取一次的维度表进行内连接(inner join)时,如果没有匹配到的数据会被直接丢弃还是会被存储在内存中

问题一:Flink CDC 里这个配置参数有文档吗?哪里有全部的配置参数可以查到? Flink CDC 里这个配置参数有文档吗?哪里有全部的配置参数可以查到? https://github.com/apache/flink-cdc ...

实时计算 Flink版产品使用问题之通过flink同步kafka数据进到doris,decimal数值类型的在kafka是正常显示数值,但是同步到doris表之后数据就变成了整数,该如何处理

问题一:Flink如果sink表建表字段过短,有数据不能插入,有啥策略配置能丢弃这些不合格的数据吗? Flink如果sink表建表字段过短,有数据不能插入,有啥策略配置能丢弃这些不合格的数据吗? configuration.set(ExecutionConfigOptions.TABLE_EXEC_SINK_TYPE_LENGTH_ENFORCER, ExecutionConfi...

实时计算 Flink版产品使用合集之如何批量读取Kafka数据

问题一:Flink sql支持批量读kafka么? Flink sql支持批量读kafka么? 参考答案: 是的,Flink SQL支持批量读取Kafka数据。您可以使用TABLE语句和FROM子句来指定Kafka作为数据源,并使用GROUP BY或JOIN等操作对数据进行处理。 以下是一个示例Flink SQL查询,演示如何从Kafka中批量...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

云消息队列 Kafka 版数据相关内容

- 云消息队列 Kafka 版数据磁盘

- 云消息队列 Kafka 版数据计算

- flinksql云消息队列 Kafka 版数据

- 产品云消息队列 Kafka 版数据

- 实时计算云消息队列 Kafka 版数据

- 云消息队列 Kafka 版connector数据

- 云消息队列 Kafka 版数据数组

- 云消息队列 Kafka 版数据调节

- 数据云消息队列 Kafka 版分区有序

- cdc数据云消息队列 Kafka 版

- 数据云消息队列 Kafka 版

- 数据云消息队列 Kafka 版分区

- 同步数据云消息队列 Kafka 版

- 数仓云消息队列 Kafka 版数据

- python云消息队列 Kafka 版数据

- 报错云消息队列 Kafka 版数据

- 云消息队列 Kafka 版数据策略

- 云消息队列 Kafka 版机制数据

- 云消息队列 Kafka 版producer数据

- flinksql数据云消息队列 Kafka 版

- cdc云消息队列 Kafka 版数据配置

- 数据云消息队列 Kafka 版报错

- 云消息队列 Kafka 版数据配置

- 同步云消息队列 Kafka 版数据

- mysql云消息队列 Kafka 版数据

- 云消息队列 Kafka 版数据排查

- 阿里云云消息队列 Kafka 版数据

- 配置云消息队列 Kafka 版数据

- cdc同步云消息队列 Kafka 版数据

- 云消息队列 Kafka 版数据报错

云消息队列 Kafka 版更多数据相关

- 云消息队列 Kafka 版数据格式格式数据

- 云消息队列 Kafka 版格式数据

- 库云消息队列 Kafka 版数据

- 云消息队列 Kafka 版流处理数据

- 云消息队列 Kafka 版数据代码

- 云消息队列 Kafka 版任务数据

- streaming云消息队列 Kafka 版数据

- spark云消息队列 Kafka 版数据

- 数据云消息队列 Kafka 版snapshot

- 实时计算flink版数据云消息队列 Kafka 版

- flink云消息队列 Kafka 版数据

- 采集数据云消息队列 Kafka 版

- 云消息队列 Kafka 版数据mysql

- canal数据云消息队列 Kafka 版

- canal云消息队列 Kafka 版数据

- flink云消息队列 Kafka 版同步数据

- 实时计算flink云消息队列 Kafka 版数据

- canal同步数据云消息队列 Kafka 版

- 云消息队列 Kafka 版数据字段

- 云消息队列 Kafka 版数据参数

- 云消息队列 Kafka 版topic数据

- 云消息队列 Kafka 版数据清理

- 云消息队列 Kafka 版订阅数据

- 云消息队列 Kafka 版数据乱序

- 云消息队列 Kafka 版数据延迟

- 捕获数据云消息队列 Kafka 版

- 云消息队列 Kafka 版数据hive

- 连接云消息队列 Kafka 版数据

- flume云消息队列 Kafka 版数据

- 云消息队列 Kafka 版消费数据

云消息队列 Kafka 版您可能感兴趣

- 云消息队列 Kafka 版应用

- 云消息队列 Kafka 版架构

- 云消息队列 Kafka 版场景

- 云消息队列 Kafka 版消费者

- 云消息队列 Kafka 版生产者

- 云消息队列 Kafka 版平台

- 云消息队列 Kafka 版分析

- 云消息队列 Kafka 版分布式

- 云消息队列 Kafka 版实战

- 云消息队列 Kafka 版flink

- 云消息队列 Kafka 版cdc

- 云消息队列 Kafka 版分区

- 云消息队列 Kafka 版集群

- 云消息队列 Kafka 版报错

- 云消息队列 Kafka 版topic

- 云消息队列 Kafka 版配置

- 云消息队列 Kafka 版同步

- 云消息队列 Kafka 版消息队列

- 云消息队列 Kafka 版消费

- 云消息队列 Kafka 版mysql

- 云消息队列 Kafka 版apache

- 云消息队列 Kafka 版安装

- 云消息队列 Kafka 版消息

- 云消息队列 Kafka 版日志

- 云消息队列 Kafka 版sql

- 云消息队列 Kafka 版原理

- 云消息队列 Kafka 版连接

- 云消息队列 Kafka 版解析

- 云消息队列 Kafka 版java

- 云消息队列 Kafka 版入门