本地部署通义千问QwQ-32B模型

通义千问QwQ-32B是阿里云开源的320亿参数推理模型,通过大规模强化学习在数学推理、编程及通用任务中实现性能突破,支持消费级显卡本地部署,兼顾高效推理与低资源消耗。本文将介绍如何利用vLLM作为通义千问QwQ-32B模型的推理框架,在一台阿里云GPU实例上构建通义千问QwQ-32B的推理服务。

双机分布式部署满血版Deepseek模型

DeepSeek-V3/R1是一个具有超过600亿参数的专家混合(MoE)模型,且已开源其模型权重。本文将介绍如何利用vllm作为DeepSeek模型的推理框架,在两台ebmgn8v实例上构建DeepSeek-V3/R1的推理服务。您无需进行额外配置,即可实现开箱即用。

双机分布式部署满血版Deepseek模型

DeepSeek-V3/R1是一个具有超过600亿参数的专家混合(MoE)模型,且已开源其模型权重。本文将介绍如何利用vllm作为DeepSeek模型的推理框架,在两台ebmgn8v实例上构建DeepSeek-V3/R1的推理服务。您无需进行额外配置,即可实现开箱即用。

本地单机部署满血版DeepSeek模型

DeepSeek-V3/R1是一个具有超过600亿参数的专家混合(MoE)模型,且已开源其模型权重。本文将介绍如何利用SGLang作为DeepSeek模型的推理框架,在一台ebmgn8v实例上构建DeepSeek-V3/R1的推理服务。您无需进行额外配置,即可实现开箱即用。

如何本地部署DeepSeek

DeepSeek-V3/R1是拥有600B以上参数量的专家混合(MoE)模型,并已经开源了模型权重。本文为您介绍在GPU实例上部署DeepSeek-R1蒸馏模型推理服务。

消费级GPU可用,文本转图像开源新模型Stable Diffusion生成宇宙变迁大片

Stable Diffusion 模型无需预处理和后处理,几秒钟内就能创造出令人惊叹的艺术图像。根据文本生成图像是近来大火的一个研究方向。无论是英伟达的 GauGAN,还是 OpenAI 的 DALL·E,都获得了令人印象深刻的结果。但这些模型都是参数量过亿的超大模型,普通的消费级 GPU 根本无法支持。现在,来自慕尼黑大学和 Runway 的研究者基于其 CVPR 2022 的论文《High-....

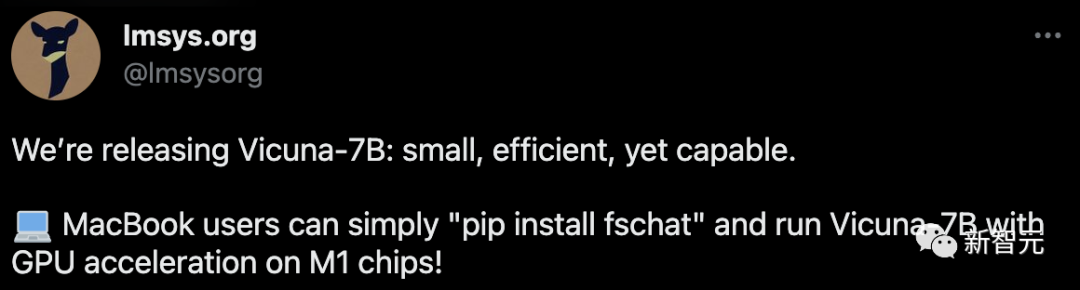

ChatGPT平替「小羊驼」Mac可跑!2行代码单GPU,UC伯克利再发70亿参数开源模型

新智元报道 编辑:桃子 好困【新智元导读】130亿参数模型权重公布不久,UC伯克利LMSys org再次发布了70亿参数「小羊驼」。同在今天,Hugging Face也发布了70亿参数模型StackLLaMA。自从Meta发布「开源版ChatGPT」LLaMA之后,学界可谓是一片狂欢。先是斯坦福提出了70亿参数Alpaca,紧接着又是UC伯克利联手CMU、斯坦福、UCSD....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

GPU云服务器模型相关内容

- 模型GPU云服务器大模型

- 开源模型GPU云服务器

- 模型GPU云服务器

- GPU云服务器模型部署

- ai GPU云服务器模型

- 函数计算GPU云服务器模型

- GPU云服务器运行模型

- modelscope模型GPU云服务器

- modelscope-funasr GPU云服务器服务模型

- modelscope-funasr GPU云服务器模型

- GPU云服务器模型onnx

- GPU云服务器部署模型

- 模型部署GPU云服务器

- 模型下载GPU云服务器

- modelscope模型GPU云服务器运行

- GPU云服务器文本模型

- 深度学习模型GPU云服务器

- pytorch模型GPU云服务器

- 加载模型GPU云服务器

- 函数计算fc模型GPU云服务器

- 模型GPU云服务器推理

- 导出模型GPU云服务器

- modelscope模型GPU云服务器推理

- 模型设置GPU云服务器

- GPU云服务器模型文件

- modelscope模型GPU云服务器报错

- 模型GPU云服务器报错

- GPU云服务器加载模型

- GPU云服务器训练模型

- 自定义GPU云服务器模型文件

GPU云服务器更多模型相关

GPU云服务器您可能感兴趣

- GPU云服务器部署

- GPU云服务器推理

- GPU云服务器程序

- GPU云服务器查询

- GPU云服务器价格

- GPU云服务器服务器

- GPU云服务器共享

- GPU云服务器方案

- GPU云服务器nvidia

- GPU云服务器收费

- GPU云服务器阿里云

- GPU云服务器实例

- GPU云服务器modelscope

- GPU云服务器cpu

- GPU云服务器函数计算

- GPU云服务器ai

- GPU云服务器性能

- GPU云服务器训练

- GPU云服务器计算

- GPU云服务器版本

- GPU云服务器安装

- GPU云服务器函数计算fc

- GPU云服务器配置

- GPU云服务器资源

- GPU云服务器深度学习

- GPU云服务器购买

- GPU云服务器参数

- GPU云服务器教程

- GPU云服务器cuda

- GPU云服务器运行