如何快速构建一个从Kafka到Hologres的数据同步作业

本文为您介绍如何通过实时计算控制台快速构建从Kafka到Hologres的数据同步作业,实现日志数据的实时入仓部署。

如何创建和使用Kafka JSON Catalog

配置Kafka JSON Catalog后,您可以在Flink全托管作业开发中直接访问Kafka集群中格式为JSON的Topic,无需再定义Schema。本文为您介绍如何在Flink全托管模式下创建、查看及删除Kafka JSON Catalog。

使用Kafka连接器进行Kerberos身份认证

Kerberos是一种网络身份验证协议,用于提供安全的身份验证服务,以保证通信的安全性。只有在Flink开发控制台正确配置Kerberos和Kafka服务的信息,Flink作业才能访问开启Kerberos认证服务的Kafka集群。本文为您介绍如何为Kafka客户端开启Kerberos认证。

实时计算 Flink版产品使用合集之在处理Kafka实时同步时,遇到反压的情况,该怎么办

问题一:Flink CDCSQL jdbc 输出 不支持overwrite 咋办,有处理过这个问题吗? Flink CDCSQL jdbc 输出 不支持overwrite 咋办,有处理过这个问题吗? 参考回答: 对于Flink CDC SQL jdbc输出不支持overwrite的问题,这是因为JD对于Flink CDC SQL jdbc输出不支持ov...

实时计算 Flink版操作报错合集之Flink sql-client 针对kafka的protobuf格式数据建表,报错:java.lang.ClassNotFoundException 如何解决

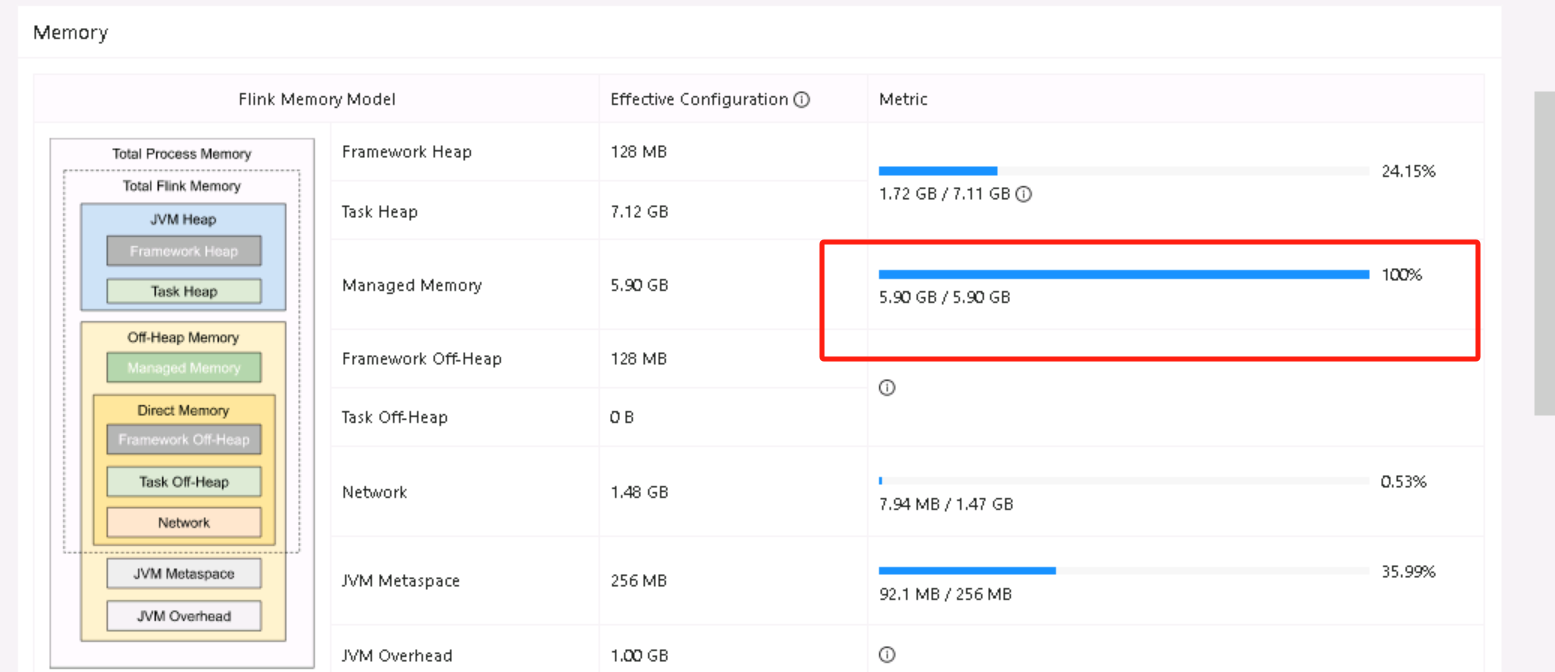

问题一:Flink CDC我task的这个内存满了 在申请资源命令的时候有没有参数可以指定? Flink CDC我task的这个内存满了 除了在flink-conf.yaml中配置 在申请资源命令的时候有没有参数可以指定?./bin/yarn-session.sh -jm 2048 -s 2 -tm 16384 我是这么创建集群 有没有参数能单独指定这个managed memo...

实时计算 Flink版产品使用合集之想要加快消费 Kafka 数据的速度,该怎么配置参数

问题一:flink怎么能够快速消费kafka数据,需要设置什么参数呢? flink怎么能够快速消费kafka数据,需要设置什么参数呢?我现在消费感觉有点慢 参考回答: 要快速消费 Kafka 数据,你可以考虑调整 Flink 中的一些参数来优化性能。以下是一些建议和参数调整: 增加并行度(Parallelism):并行度是 Flin...

实时计算 Flink版产品使用合集之读取kafka数据然后入库到starrocks,出现未知问题如何解决

问题一:我刚刚看了一下Flink文档,好像没有哪里说支持动态topic,所以是不支持? 我刚刚看了一下Flink文档,好像没有哪里说支持动态topic,所以是不支持? 参考回答: 支持的,根据正则来匹配的,new FlinkKafkaConsume时,参数可以是正则匹配 关于本问题的更多回答可点击原文查看:https://develo...

实时计算 Flink版产品使用合集之支持sink到多分区的kafka ,还能保持有序吗

问题一:请教下Flink CDC SQL Server用户定义数据类型该怎么处理? 请教下Flink CDC SQL Server用户定义数据类型该怎么处理?目前错误提示IllegalArgumentException: The column "WARD_CODE" is referenced as PRIMARY KEY, but a matching column is n...

实时计算 Flink版sql如何接受kafka中value是[{},{}]格式的数据?

实时计算 Flink版sql如何接受kafka中value是[{},{}]格式的数据?目前找到的全是{},一条的数据格式

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

云消息队列 Kafka 版您可能感兴趣

- 云消息队列 Kafka 版消费者

- 云消息队列 Kafka 版生产者

- 云消息队列 Kafka 版下载

- 云消息队列 Kafka 版迁移

- 云消息队列 Kafka 版教程

- 云消息队列 Kafka 版topic

- 云消息队列 Kafka 版集群

- 云消息队列 Kafka 版幂等

- 云消息队列 Kafka 版语义

- 云消息队列 Kafka 版once

- 云消息队列 Kafka 版flink

- 云消息队列 Kafka 版数据

- 云消息队列 Kafka 版cdc

- 云消息队列 Kafka 版分区

- 云消息队列 Kafka 版报错

- 云消息队列 Kafka 版配置

- 云消息队列 Kafka 版同步

- 云消息队列 Kafka 版消息队列

- 云消息队列 Kafka 版消费

- 云消息队列 Kafka 版mysql

- 云消息队列 Kafka 版apache

- 云消息队列 Kafka 版安装

- 云消息队列 Kafka 版消息

- 云消息队列 Kafka 版日志

- 云消息队列 Kafka 版sql

- 云消息队列 Kafka 版原理

- 云消息队列 Kafka 版连接

- 云消息队列 Kafka 版解析

- 云消息队列 Kafka 版java

- 云消息队列 Kafka 版入门

云消息队列

涵盖 RocketMQ、Kafka、RabbitMQ、MQTT、轻量消息队列(原MNS) 的消息队列产品体系,全系产品 Serverless 化。RocketMQ 一站式学习:https://rocketmq.io/

+关注