使用Spark Operator运行Spark作业

Apache Spark是一种专门用于大规模数据处理的计算引擎,广泛应用于数据分析和机器学习等场景。Spark Operator提供了一种在Kubernetes集群中自动化部署Spark作业和管理其生命周期的能力。本文介绍如何在ACK集群中使用Spark Operator运行Spark作业,帮助数据工程师快速高效地运行和管理大数据处理作业。

使用BestEffort实例运行Spark应用

阿里云容器计算服务 ACS(Container Compute Service)提供了Serverless形态的容器算力,对于大数据类型的计算任务,使用BestEffort算力质量的实例可以在满足其弹性算力需求的同时,降低任务的计算成本。本文主要为您介绍如何通过ACS提供的BestEffort实例运行Spark应用。

使用ECI弹性资源运行Spark作业

本文介绍如何在ACK集群中使用弹性容器实例ECI运行Spark作业。通过使用ECI弹性资源并配置合适的调度策略,您可以按需创建ECI Pod,并按资源使用量按需付费,从而有效减少资源闲置带来的成本浪费,进而更加经济高效地运行Spark作业。

使用ECI运行Spark作业

在Kubernetes集群中使用ECI来运行Spark作业具有弹性伸缩、自动化部署、高可用性等优势,可以提高Spark作业的运行效率和稳定性。本文介绍如何在ACK Serverless集群中安装Spark Operator,使用ECI来运行Spark作业。

如何新建SparkSQL类型的公共节点并运行_数据资源平台(DRP)

Spark SQL节点是离线节点,运行于Spark类型的云计算资源之上,可通过输入SQL语句处理Spark类型的数据源。本文介绍如何新建Spark SQL类型的公共节点并运行。

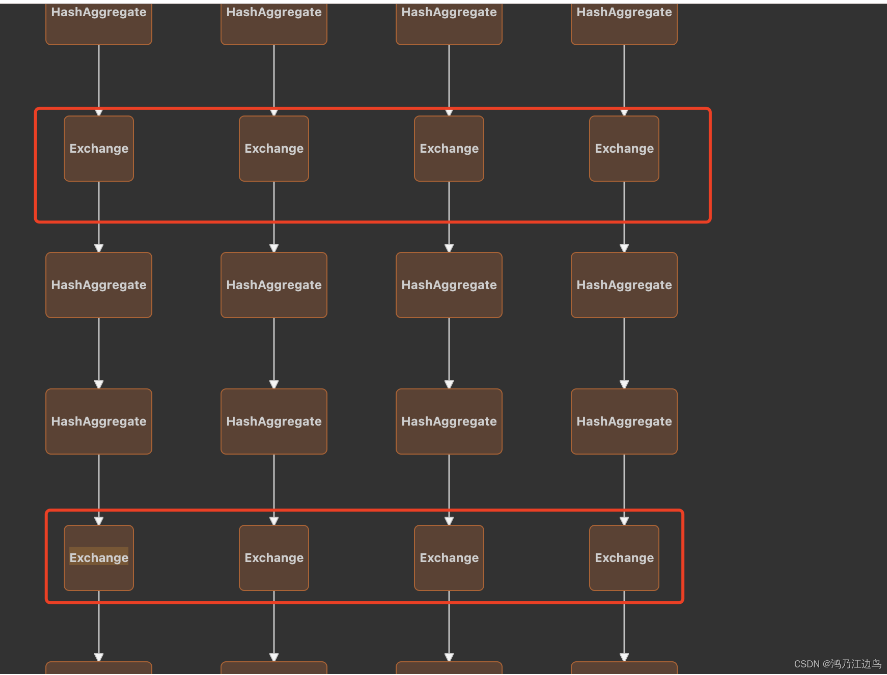

spark shuffle(ExchangeExec)过多导致任务运行过慢甚至超时

背景以及现象本文基于 spark 3.1.2设置spark.driver.memory=2g在调试spark sql任务的时候,发现有任务产生了200多个exchange,而且任务长期运行不出来。分析运行对应的sql(多个连续的join操作,且join的key都不一样),得到如下的物理计划(我们只截取了一部分):和之前的文章spark task过多导致任务运行过慢甚至超时 做法一样(对应的内存都....

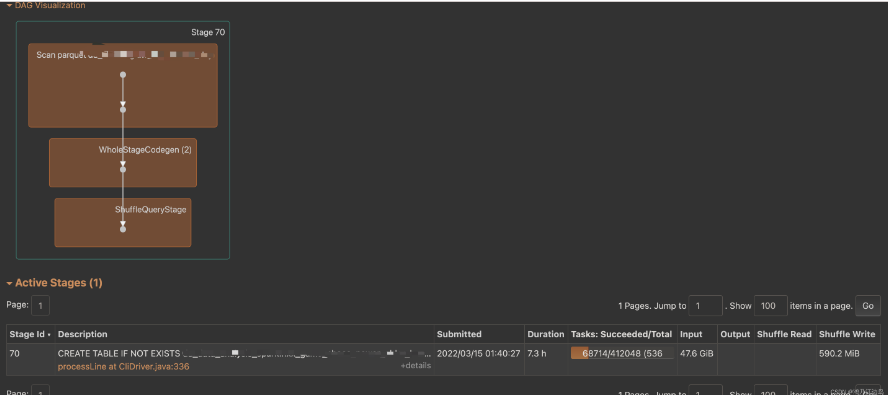

spark task过多导致任务运行过慢甚至超时

背景以及现象本文基于 spark 3.1.2设置spark.driver.memory=2g在调试spark sql任务的时候,发现有几个任务产生了40多万个Task,而且任务长期运行不出来。分析运行此sql,可以得到如下的dag(我们只截取产生Task多的Stage),由此可以看到是scan的文件太大了(scan了日志文件半年的数据)。但是为什么这种情况下会导致任务运行很缓慢甚至会超时呢?找到....

spark程序偶尔会运行超时,怎样才能让sparksql程序如果超过一个小时就自动kill掉?

spark程序偶尔会运行超时,怎样才能让sparksql程序如果超过一个小时就自动kill掉?

【问题】spark运行python写的mapreduce任务,hadoop平台报错,java.net.ConnectException: 连接超时

问题: 用spark-submit以yarn-client方式提交任务,在集群的某些节点上的任务出现连接超时的错误,排查过各种情况后,确定在防火墙配置上出现问题。 原因: 我猜测是python程序启动后,作为Server,hadoop中资源调度是以java程序作为Client端访问, Python启动的Server端需要接受localhost的client访问。 当你从一台linux主机向自身发....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

apache spark运行相关内容

- apache spark集群运行

- apache spark master运行

- apache spark作业运行

- 大数据apache spark运行

- apache spark打包运行

- apache spark编译运行

- bin apache spark master集群运行

- apache spark yarn模式运行

- apache spark运行报错

- emr运行apache spark

- apache spark运行任务

- maxcompute apache spark运行

- apache spark集群模式运行

- apache spark任务运行

- 数据计算apache spark运行

- apache spark运行原理

- 运行apache spark报错

- 集群运行apache spark

- apache spark版本运行

- apache spark原理运行

- apache spark原理运行学习笔记

- apache spark原理运行stage

- 代码apache spark运行

- apache spark组件运行

- apache spark standalone模式运行

- apache spark task运行

- 运行apache spark作业

- yarn运行apache spark

- apache spark程序运行

- apache spark driver运行

apache spark更多运行相关

apache spark您可能感兴趣

- apache spark任务管理

- apache spark SQL

- apache spark训练

- apache spark特征

- apache spark实战

- apache spark学习

- apache spark架构

- apache spark性能

- apache spark游戏

- apache spark驱动

- apache spark streaming

- apache spark数据

- apache spark Apache

- apache spark Hadoop

- apache spark大数据

- apache spark rdd

- apache spark MaxCompute

- apache spark集群

- apache spark任务

- apache spark summit

- apache spark模式

- apache spark分析

- apache spark flink

- apache spark Scala

- apache spark机器学习

- apache spark应用

- apache spark yarn

- apache spark技术

- apache spark操作

- apache spark程序

Apache Spark 中国技术社区

阿里巴巴开源大数据技术团队成立 Apache Spark 中国技术社区,定期推送精彩案例,问答区数个 Spark 技术同学每日在线答疑,只为营造 Spark 技术交流氛围,欢迎加入!

+关注