ambari2.0.0,hadoop2.6重启namenode报错

1、数据量变大后重启namenode失败。 修改 vi /var/lib/ambari-agent/cache/common-services/HDFS/2.1.0.2.0/package/scripts/hdfs_namenode.py 头部添加 import time 添加循环 if leave_safe_mode:上面添加 for i in range(1,90+1,1): ....

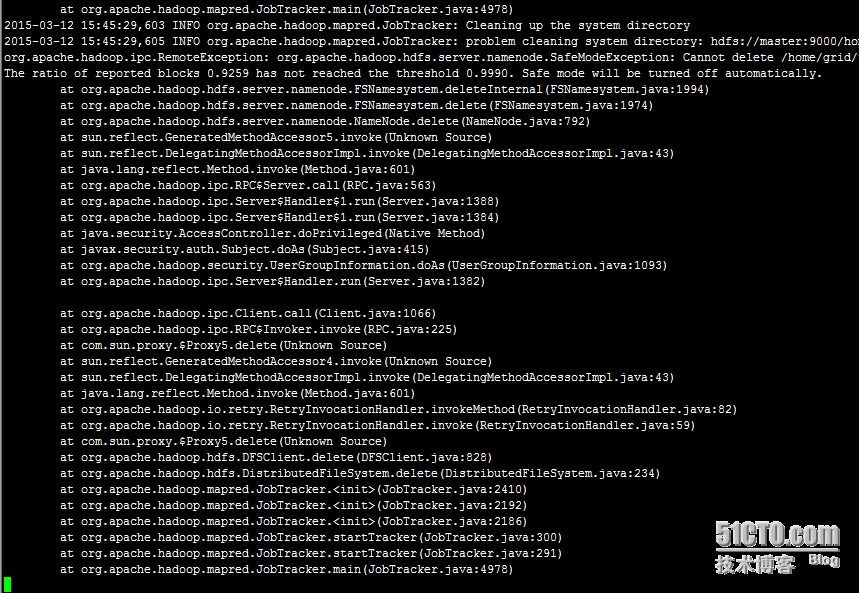

hadoop集群服务重启后出错

hadoop启动时会检查数据的完整性,当数据完整性小于设置的值时,会一直处于安全模式。可通过修改hdfs_site.xml中的以下参数来修改该配置 该参数默认为0.999f <property> <name>dfs.safemode.threshold.pct</name> <value>0.600f</value> 本文转自 j...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

hadoop重启相关内容

hadoop您可能感兴趣

- hadoop数据

- hadoop技术选型

- hadoop分布式

- hadoop系统

- hadoop存储

- hadoop解析

- hadoop大数据处理

- hadoop大数据

- hadoop大规模

- hadoop mapreduce

- hadoop集群

- hadoop hdfs

- hadoop安装

- hadoop配置

- hadoop spark

- hadoop文件

- hadoop学习

- hadoop yarn

- hadoop hive

- hadoop命令

- hadoop运行

- hadoop节点

- hadoop搭建

- hadoop hbase

- hadoop部署

- hadoop报错

- hadoop实战

- hadoop概念

- hadoop启动

- hadoop操作