如何使用新版Flink Connector将数据写入MaxCompute,有哪些参数

MaxCompute提供了新版Flink Connector插件,支持将Flink数据写入至MaxCompute的普通表和Delta Table类型表,以提高Flink数据写入MaxCompute的便捷性。本文为您介绍新版Flink Connector写入MaxCompute的能力支持情况与主要操作流程。

Flink CDC写入MaxCompute

MaxCompute为您提供对接Flink CDC的新版插件Connector连接器。您可以通过对接Flink CDC,将数据源(例如MySQL)数据实时同步至MaxCompute的目标表(普通表或Delta表)。本文为您介绍MaxCompute新版插件的能力支持情况与主要操作流程。

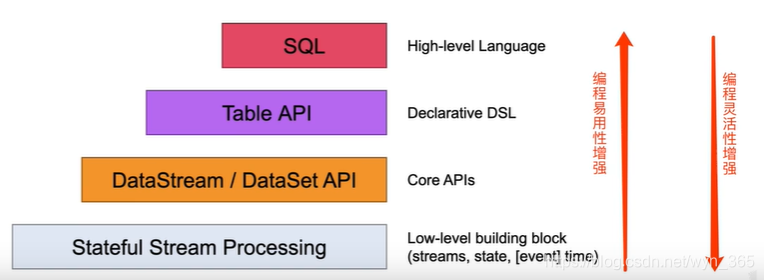

【Flink-API】Table API & SQL 以及自定义UDF函数

一、 Flink Table API & SQL简介1.1 Table API & SQL的背景Flink虽然已经拥有了强大的DataStream/DataSet API,而且非常的灵活,但是需要熟练使用Eva或Scala的编程Flink编程API编写程序,为了满足流计算和批计算中的各种场景需求,同时降低用户使用门槛,Flink供- -种关系型的API来实现流与批的统一,那么这就....

FLINK TABLE API 自定义聚合函数UDAF从check point恢复任务报状态序列

大家好:我在使用flink table api 实现group by 聚合操作的时候,自定义了一个UDAF函数,首次在集群上运行的时候是正确的,但是从check point恢复任务的时候报下面错误,但是使用内置的函数就没问题,不知道我该怎么解决呢? java.lang.RuntimeException: Error while getting state at org.apache.flink.....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

实时计算 Flink版table相关内容

- 实时计算 Flink版table etl

- 实时计算 Flink版sql table

- 实时计算 Flink版dynamic table

- 实时计算 Flink版table op

- 实时计算 Flink版temporal table

- 实时计算 Flink版any table

- 实时计算 Flink版column table

- 实时计算 Flink版select table

- 实时计算 Flink版datastream table

- 实时计算 Flink版table support consuming

- 实时计算 Flink版table store

- 实时计算 Flink版table sql

- 实时计算 Flink版table ddl

- 实时计算 Flink版table算子

- 实时计算 Flink版教程table

- 实时计算 Flink版table权限

- 实时计算 Flink版clickhouse table

- 实时计算 Flink版drop table

- 实时计算 Flink版alter table

- 实时计算 Flink版table source

- 实时计算 Flink版table概念

- 实时计算 Flink版group table

- table实时计算 Flink版

- 实时计算 Flink版table store典型应用场景

- 实时计算 Flink版table tableenvironment类

- 实时计算 Flink版table udaf

- 实时计算 Flink版 Table

- 实时计算 Flink版注册table

- 实时计算 Flink版table流程

实时计算 Flink版您可能感兴趣

- 实时计算 Flink版b站

- 实时计算 Flink版云原生

- 实时计算 Flink版实践

- 实时计算 Flink版CDC

- 实时计算 Flink版kafka

- 实时计算 Flink版数据链路

- 实时计算 Flink版湖仓

- 实时计算 Flink版湖仓一体

- 实时计算 Flink版Hologres

- 实时计算 Flink版batch

- 实时计算 Flink版数据

- 实时计算 Flink版SQL

- 实时计算 Flink版mysql

- 实时计算 Flink版报错

- 实时计算 Flink版同步

- 实时计算 Flink版任务

- 实时计算 Flink版flink

- 实时计算 Flink版实时计算

- 实时计算 Flink版版本

- 实时计算 Flink版oracle

- 实时计算 Flink版表

- 实时计算 Flink版配置

- 实时计算 Flink版产品

- 实时计算 Flink版Apache

- 实时计算 Flink版设置

- 实时计算 Flink版作业

- 实时计算 Flink版模式

- 实时计算 Flink版数据库

- 实时计算 Flink版运行

- 实时计算 Flink版连接