MaxCompute产品使用问题之数据集成任务有脏数据,如何快速定位哪些字段有问题

问题一:大数据计算MaxCompute中,按小时调度的周期任务,选择发布立即生成,发布当天会有问题,能解决? 大数据计算MaxCompute中,按小时调度的周期任务,选择发布立即生成,发布当天会有问题,能解决? 参考回答: 针对大数据计算MaxCompute中按小时调度的周期任务在发布当天出现的问题,以下是一些可能的解决方案和排查步骤: 检查发布时机: ...

DataWorks操作报错合集之在数据集成到MySQL时,遇到特殊字符导致的脏数据如何解决

问题一:DataWorks为啥会创建失败? DataWorks为啥会创建失败?requestid:[0bc5aa2817032405577393844e0ea1],Message:[14 tables failed to create table. Please check the detailed log],Server:[172.26.131.106,iZwz99po4ho...

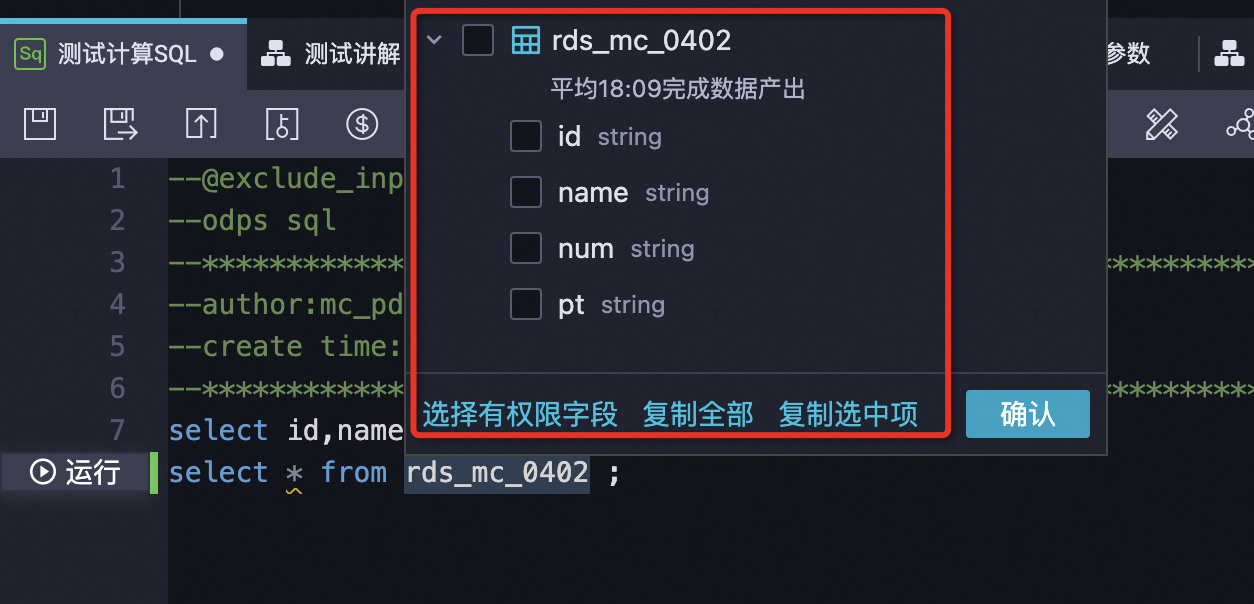

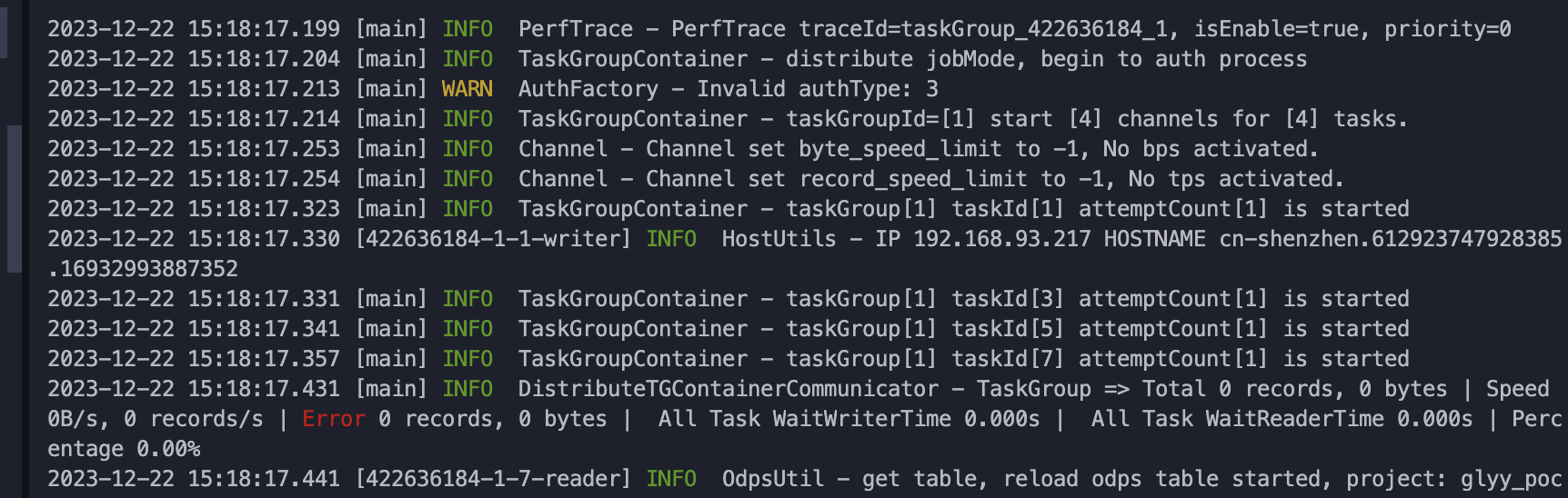

大数据计算MaxCompute中,如何数据集成任务存在脏数据,能快速定位哪些字段有问题么?

大数据计算MaxCompute中,如何数据集成任务存在脏数据,能快速定位哪些字段有问题么?

dataworks数据集成往clickhouse插数据出现dirtydata,这种脏数据会被过滤吗?

dataworks数据集成往clickhouse插数据出现dirtydata,这种脏数据会被过滤吗,还是也会插到ck里?

DataWorks数据集成到mysql 有特殊字符 报脏数据怎么处理比较好?

DataWorks数据集成到mysql 有特殊字符 报脏数据怎么处理比较好? CommonRdbmsWriter$Task - 回滚此次写入, 采用每次写入一行方式提交. 因为:java.sql.BatchUpdateException: Incorrect string value: '\xF0\x9F\x91\x8D\xEF\xBC...' for column 'text' at row 2

DataWorks数据集成脏数据source column number is in valid?

DataWorks数据集成脏数据source column number is in valid?

你好,我在Dataworks中配了数据集成任务自动调度起来观察日志并没有报脏数据,但是存在部分字段?

你好,我在Dataworks中配了数据集成(odps -> elasticsearch update模式),任务自动调度起来观察日志并没有报脏数据,但是存在部分字段没有更新到,我应该怎么判断具体是什么原因导致的?补充:任务运行了好几天了,我指定更新了10个字段,ES中有的10个字段都更新到了,有的可能只更新到了8个字段。并发:2,BatchSize:256

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。