如何使用Blade优化通过TensorFlow训练的BERT模型

BERT(Bidirectional Encoder Representation from Transformers)是一个预训练的语言表征模型。作为NLP领域近年来重要的突破,BERT模型在多个自然语言处理的任务中取得了最优结果。然而BERT模型存在巨大的参数规模和计算量,因此实际生产中对该模型具有强烈的优化需求。本文主要介绍如何使用Blade优化通过TensorFlow训练的BERT模型。

AI加速:使用TorchAcc实现Bert模型分布式训练加速_人工智能平台 PAI(PAI)

阿里云PAI为您提供了部分典型场景下的示例模型,便于您便捷地接入TorchAcc进行训练加速。本文为您介绍如何在BERT-Base分布式训练中接入TorchAcc并实现训练加速。

【多标签文本分类】MSML-BERT模型的层级多标签文本分类方法研究

·阅读摘要: 本文在BERT模型上,提出了利用多任务架构来解决层级多标签文本分类问题。·参考文献: [1] MSML-BERT模型的层级多标签文本分类方法研究[0] 摘要 在摘要中,作者主要给出了本篇论文的创新点: 1、多任务学习架构 2、多尺度特征抽取模块 3、多层级信息传播模块 4、层次化门控机制 最后论文再总结一下,提出的模型在数据集上效果良好。【注一】....

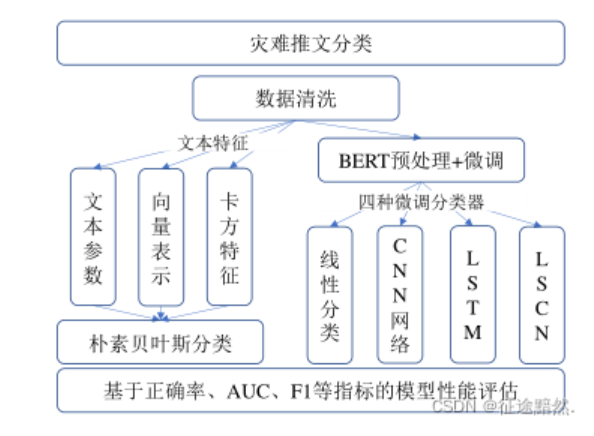

【文本分类】基于BERT预训练模型的灾害推文分类方法、基于BERT和RNN的新闻文本分类对比

·阅读摘要: 两篇论文,第一篇发表于《图学学报》,《图学学报》是核心期刊;第二篇发表于《北京印刷学院学报》,《北京印刷学院学报》没有任何标签。·参考文献: [1]林佳瑞,程志刚,韩宇,尹云鹏.基于BERT预训练模型的灾害推文分类方法[J/OL].图学学报:1-8[2022-01-17].http://kns.cnki.net/kcms/detail/10.1034.T.2022010....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

bert模型相关内容

- bert模型架构

- 模型bert

- 训练bert large模型

- bert模型训练

- 训练模型bert

- nlp bert模型

- bert模型方法

- 部署bert模型

- bert模型文件

- bert文本分类模型

- 模型bert预训练

- bert模型原理

- 预训练语言模型模型bert

- 预训练模型bert

- bert模型配置

- bert模型推理

- transformer模型bert

- 模型推理bert

- 模型推理onnx bert特征抽取

- 模型推理bert方案

- bert模型框架

- 模型xlnet bert

- 任务bert模型

- bert文本分类实战模型

- bert谷歌模型

- 构建bert模型蒸馏textcnn

- 怎么使用构建bert模型蒸馏textcnn

- bert模型nlp