【机器学习】集成学习(Bagging)——随机森林(RandomForest)(理论+图解+公式推导)

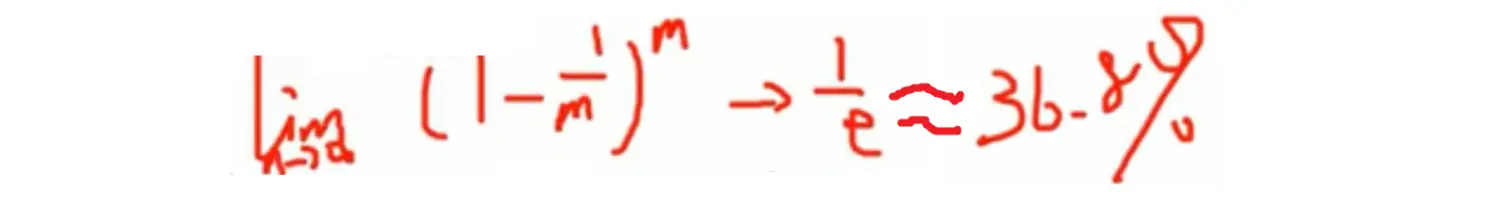

2021人工智能领域新星创作者,带你从入门到精通,该博客每天更新,逐渐完善机器学习各个知识体系的文章,帮助大家更高效学习。一、引言集成学习方式大致分为两种,一种是Boosting架构,采用模型之间串行的方式,典型算法代表为AdaBoost、GBDT等,第二种为Bagging,它是采用模型独立并行的架构,典型算法代表随机森林。我们集成模型是为了提高模型的泛化能力,希望每个学习器能够有各自的特点,而....

01 集成学习 - 概述、Bagging - 随机森林、袋外错误率

这几章我们聊聊集成学习,__集成学习算法__是目前为止我们在__相同特征__条件下做特征工程时,建立模型评分和效果最好的算法。比之前讲过的线性回归、Logist回归、KNN、决策树的评分效果都好。 集成学习的讲解分三个部分:__Bagging-自举汇聚__、__Boosting-提升算法__、__Stacking-模型融合__。注意:Stacking模型是一个很有趣的算法,在比赛中用到有时候效果....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

集成学习相关内容

- 集成学习性能

- 学习集成swagger

- 学习集成

- 机器学习集成学习

- 模型集成学习

- 集成学习stacking

- 集成学习随机森林

- 集成学习梯度

- 集成学习机器学习

- 集成学习learning

- 集成学习分类

- 机器学习集成学习模型

- 分类集成学习

- 集成学习bagging boosting

- 机器学习集成学习boosting

- 集成学习boosting

- 集成学习原理

- 集成学习树

- 集成学习gradient

- 集成学习梯度树

- 集成学习决策树

- 集成学习gradient boosting

- scikit-learn集成学习

- 教程集成迁移学习

- 教程集成学习

- 集成迁移学习

- xgboost集成学习

- 集成学习模型

- 学习集成gitlab

- 集成学习task1