设置日志收集至Kafka

Serverless 应用引擎 SAE(Serverless App Engine)支持将应用实例的标准输出(stdout),以及将应用实例指定路径的日志采集到云消息队列 Kafka 版中。在此基础上,您可以结合自身的业务场景,将Kafka的数据投递到例如Elasticsearch等其他持久化库中,便于集中管理和分析日志。本文介绍在SAE控制台设置日志收集到Kafka的使用场景、操作步骤与采集格式...

使用日志管理查询和分析消息操作日志

您可以使用云消息队列 Confluent 版的日志管理功能将云消息队列 Confluent 版实例的消息操作日志推送到日志服务。您可通过开通该服务,查询客户端的所有请求日志。

【Azure 事件中心】开启 Apache Flink 制造者 Producer 示例代码中的日志输出 (连接 Azure Event Hub Kafka 终结点)

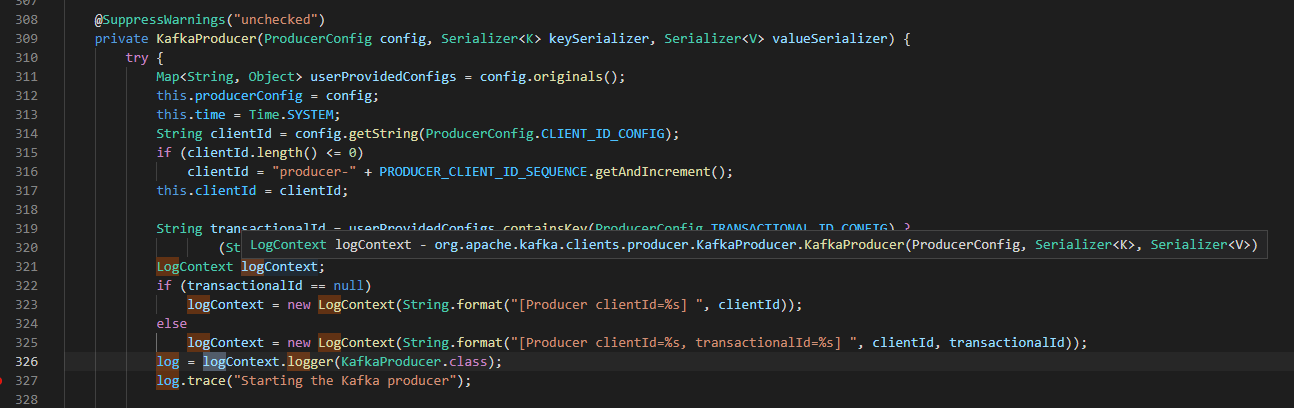

问题描述 Azure Event Hub 在标准版以上就默认启用的Kafka终结点,所以可以通过Apache Kafka协议连接到Event Hub进行消息的生产和消费。通过示例代码下载到本地运行后,发现没有 Kafka Producer 的详细日志输出。当查看SDK源码中,发现使用的是 org.slf4j.Logger 输出日志,如: ...

日志收集平台项目nginx、kafka、zookeeper、filebeat搭建的基本配置(2)

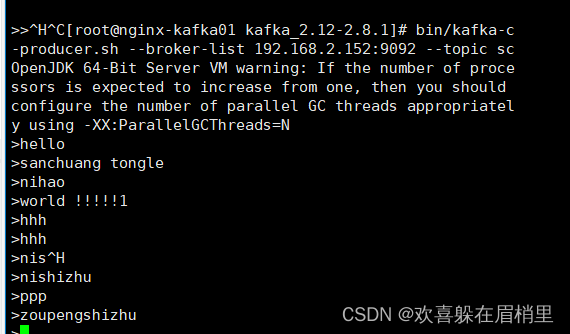

日志收集平台项目nginx、kafka、zookeeper、filebeat搭建的基本配置(1)+https://developer.aliyun.com/article/1557824 3、kafka搭建 使用kafka来收集日志的原因:收集nginx的日志,将nginx日志提取关键字段进行分析,将日志分析清洗后的数据再存入mysql数据库。可以方便业务解耦,流量。...

日志收集平台项目nginx、kafka、zookeeper、filebeat搭建的基本配置(1)

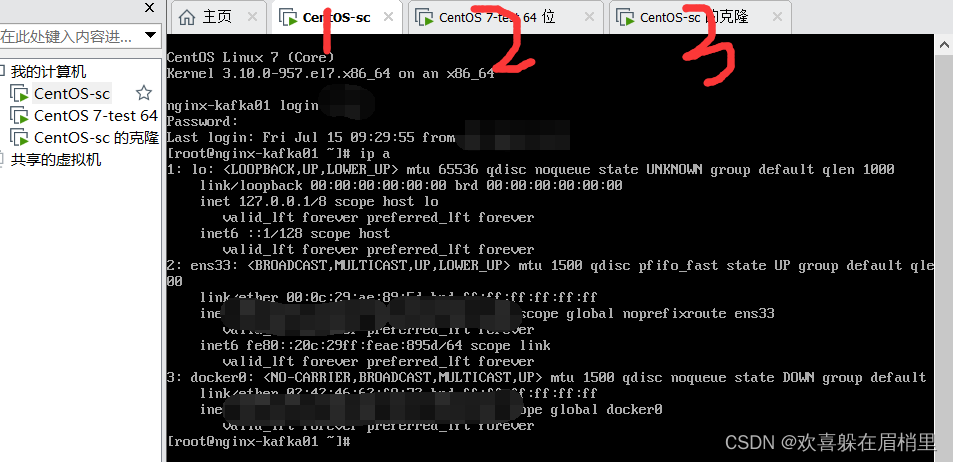

1、环境准备 1.1 准备好三台虚拟机搭建nginx和kafka集群。 1.2 配置好静态ip地址(尽量使用NAT模式) 为了统一,我的使用的是桥接模式。 1、先准备三台虚拟机: ...

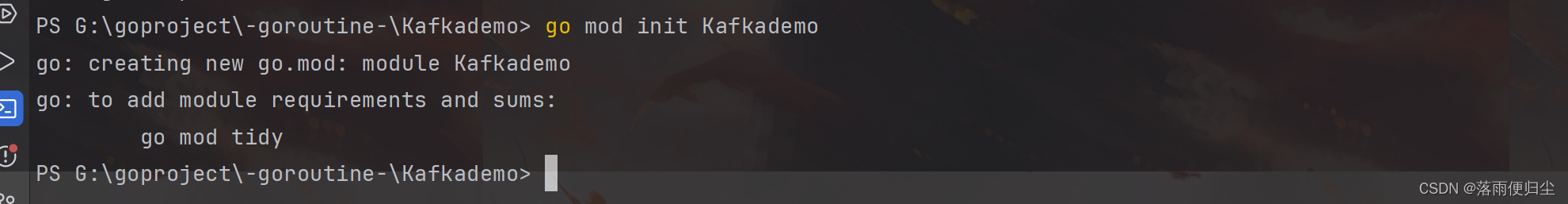

go语言并发实战——日志收集系统(三) 利用sarama包连接KafKa实现消息的生产与消费

环境的搭建 Kafka以及相关组件的下载 我们要实现今天的内容,不可避免的要进行对开发环境的配置,Kafka环境的配置比较繁琐,需要配置JDK,Scala,ZoopKeeper和Kafka,这里我们不做赘述,如果大家不知道如何配置环境,这里我们个大家找了一篇博文供大家参考: sarama包的安装 今天我们所时机的内容需要用到go语言的第三方包sarama...

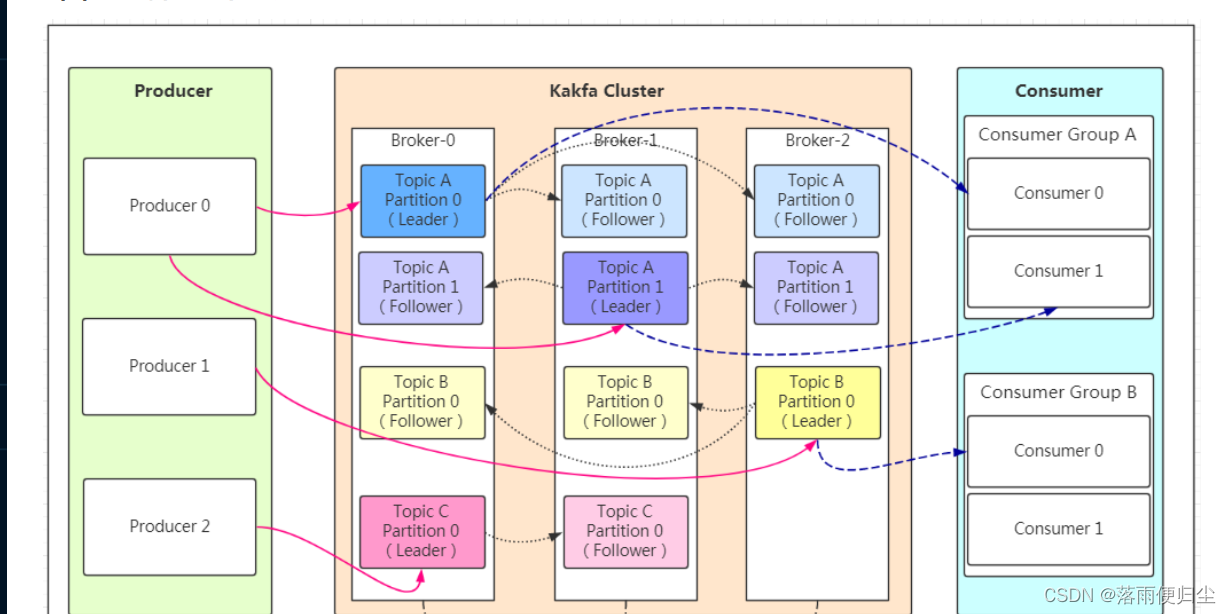

go语言并发实战——日志收集系统(二) Kafka简介

消息队列的通信模式 点对点模式 消息生产者生产消息发送到消息队列(queue),消费者从queue中取出并且消费信息,而这条信息被消费后queue中就没有了这条信息,不存在重复消费 发布/订阅 基本概念发布者发布消息发送到消息队列(topic),订阅者从topic中取出并且消费信息,而这条信息被消费后topic中还存在这条信息,存在重复消费 ...

Flink CDC里binlogs日志读到kafka.每修改一次啊?

Flink CDC里binlogs日志读到kafka.每修改一次会读到3条日志,而且顺序可能不通,字段还有丢失是为啥?如果最后一条没有丢,数据正确,但是如果没丢的在前面,那么字段值就丢了。{"id":1,"long_txt_value":"d","name":"1","varchar_value":"9"}{"id":1,"long_txt_value":"d","name":"1"}{"id"....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

云消息队列 Kafka 版您可能感兴趣

- 云消息队列 Kafka 版生产者

- 云消息队列 Kafka 版hub

- 云消息队列 Kafka 版event

- 云消息队列 Kafka 版并发

- 云消息队列 Kafka 版spring

- 云消息队列 Kafka 版springcloud

- 云消息队列 Kafka 版stream

- 云消息队列 Kafka 版报错

- 云消息队列 Kafka 版接收

- 云消息队列 Kafka 版镜像

- 云消息队列 Kafka 版flink

- 云消息队列 Kafka 版数据

- 云消息队列 Kafka 版cdc

- 云消息队列 Kafka 版分区

- 云消息队列 Kafka 版集群

- 云消息队列 Kafka 版topic

- 云消息队列 Kafka 版配置

- 云消息队列 Kafka 版同步

- 云消息队列 Kafka 版消息队列

- 云消息队列 Kafka 版消费

- 云消息队列 Kafka 版mysql

- 云消息队列 Kafka 版apache

- 云消息队列 Kafka 版安装

- 云消息队列 Kafka 版消费者

- 云消息队列 Kafka 版消息

- 云消息队列 Kafka 版sql

- 云消息队列 Kafka 版原理

- 云消息队列 Kafka 版连接

- 云消息队列 Kafka 版解析

- 云消息队列 Kafka 版java

云消息队列

涵盖 RocketMQ、Kafka、RabbitMQ、MQTT、轻量消息队列(原MNS) 的消息队列产品体系,全系产品 Serverless 化。RocketMQ 一站式学习:https://rocketmq.io/

+关注