基于ChatGPT的API的C#接入研究

今年开年,最火的莫过于ChatGPT的相关讨论,这个提供了非常强大的AI处理,并且整个平台也提供了很多对应的API进行接入的处理,使得我们可以在各种程序上无缝接入AI的后端处理,从而实现智能AI的各种应用。ChatGPT的API可以在前端,以及一些后端进行API的接入,本篇随笔主要介绍基于ChatGPT的API的C#接入研究。 1、ChatGPT的介绍 ChatGPT(全名:Ch...

【人工智能】第六部分:ChatGPT的进一步发展和研究方向

在探讨了ChatGPT的技术实现、实际应用案例和未来发展方向后,接下来我们将深入探讨一些具体的进一步发展和研究方向,这些方向可能会塑造未来几年内的ChatGPT及其相关技术。 6.1 多模态模型的发展 6.1.1 现状和挑战 目前的ChatGPT主要处理文本数据,而人类的交流往往是多模态的,包含了文本、语音、图像、视频等多种信息。多模态模型的发展旨在使得语言模型能够理解和...

斯坦福最新研究:ICLR/NeurIPS等竟有16.9%评审是ChatGPT生成

在人工智能技术的飞速发展下,AI与人类互动的边界日益模糊。近期,斯坦福大学的研究团队通过深入分析,揭示了一个引人深思的现象:在人工智能领域的顶级学术会议上,有相当一部分的评审内容可能由大型语言模型(LLM)如ChatGPT生成或大幅修改。这一发现不仅展示了AI在学术领域的深远影响,也引发了对学术诚信和评审质量的广泛关注。 研究团队通过开发一种名为“分布式GPT量化”的新框架,对AI在学术评审中.....

南加州大学最新研究:ChatGPT或只有70亿参数规模

在人工智能领域,大型语言模型(LLM)的发展一直是研究的热点。南加州大学的研究团队近期发表的一篇论文,为我们提供了对这些模型更深入理解的可能性。该研究团队发现,即使是通过API保护的LLM,也能通过少量的查询推断出模型的关键信息,这一发现对于理解LLM的内部工作机制具有重要意义。 LLM的商业化使得许多公司和组织选择通过API来限制对模型的访问,以保护其专有技术。然而,南加州大学的研究发现,这.....

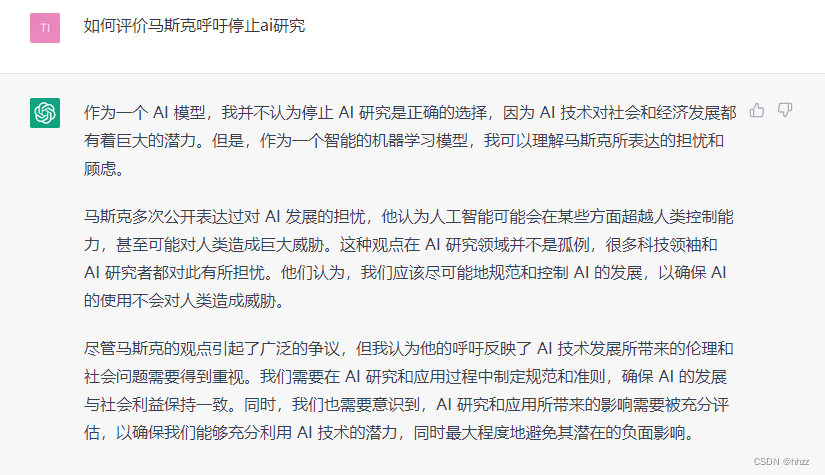

看看OpenAI(ChatGPT)怎么回答马斯克呼吁停止ai研究的?

me:如何评价马斯克呼吁停止ai研究 ChatGPT:作为一个 AI 模型,我并不认为停止 AI 研究是正确的选择,因为 AI 技术对社会和经济发展都有着巨大的潜力。但是,作为一个智能的机器学习模型,我可以理解马斯克所表达的担忧和顾虑。 马斯克多次公开表达过对 AI 发展的担忧,他认为人工智能可能会在某些方面超越人类控制能力,甚至可能对人类造成巨大威胁。这种观点在 AI 研究领域...

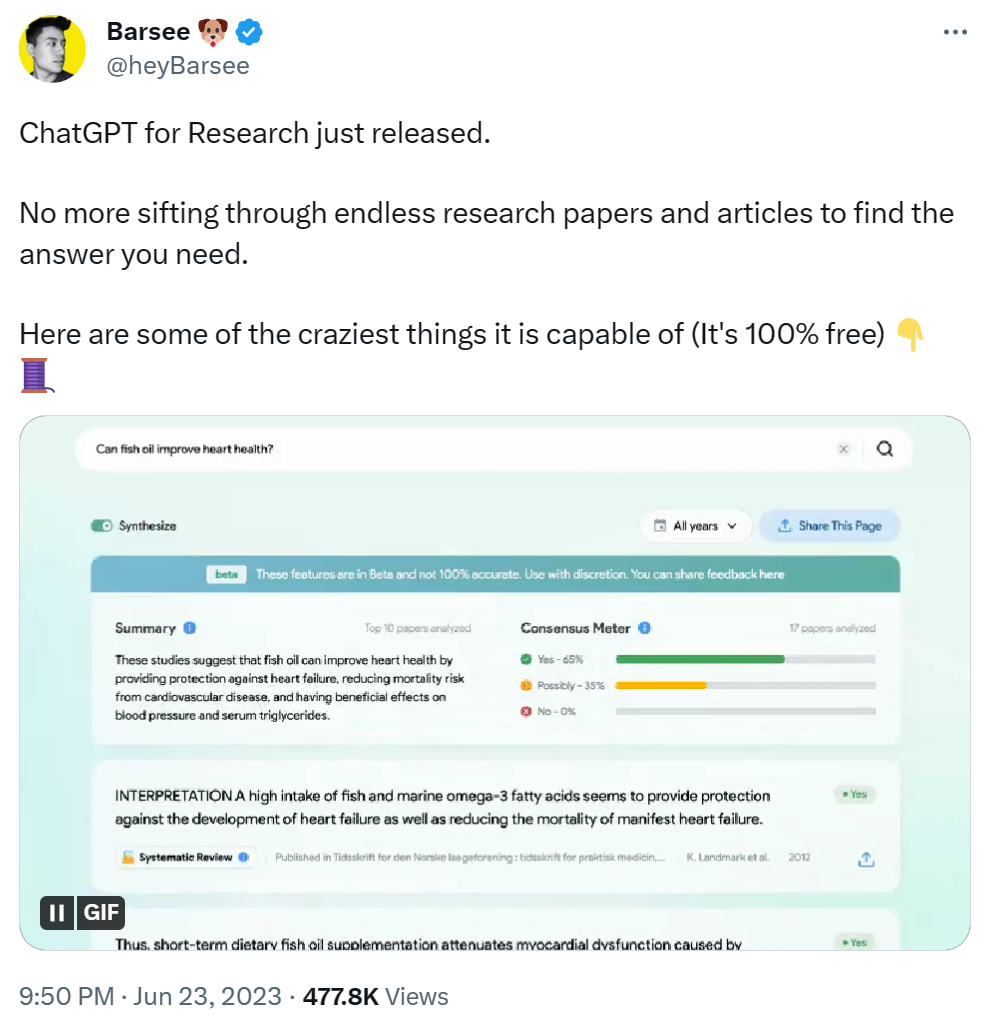

专门做研究的ChatGPT平台:你的答案完全来自论文,免费使用

还在为查阅文献而烦恼吗?试试这个 ChatGPT 平台。 当你需要获取较为专业的信息时,查阅文献往往是一件令人「头秃」的事情,毕竟文献是海量的,查阅的人确实有限的。寻找相关的文章、进行浏览阅读、摘取主要观点、总结文章、判断是否能够使用,这一套流程下来,时间与精力都耗费的七七八八了。如果在这个过程中,AI 能够帮助你完成大部分工作,会不会使你的工作更加有效率呢?可能有人会怀疑 AI 的准确...

OpenAI重磅研究:ChatGPT可能影响80%工作岗位,收入越高影响越大

ChatGPT 的影响涵盖所有收入阶层,且高收入工作可能面临更大的风险。ChatGPT 来了,失业还会远吗?上星期在 GPT-4 发布时,ChatGPT 第一时间上线了新版本,OpenAI 首席执行官 Sam Altman 表示他对自家这种技术「有点害怕」。和很多专家一样,Altman 担心人工智能技术的强大能力会制造过多虚假信息,另一方面,新技术也将改变经济、劳动力和教育环境。有人开玩笑说 S....

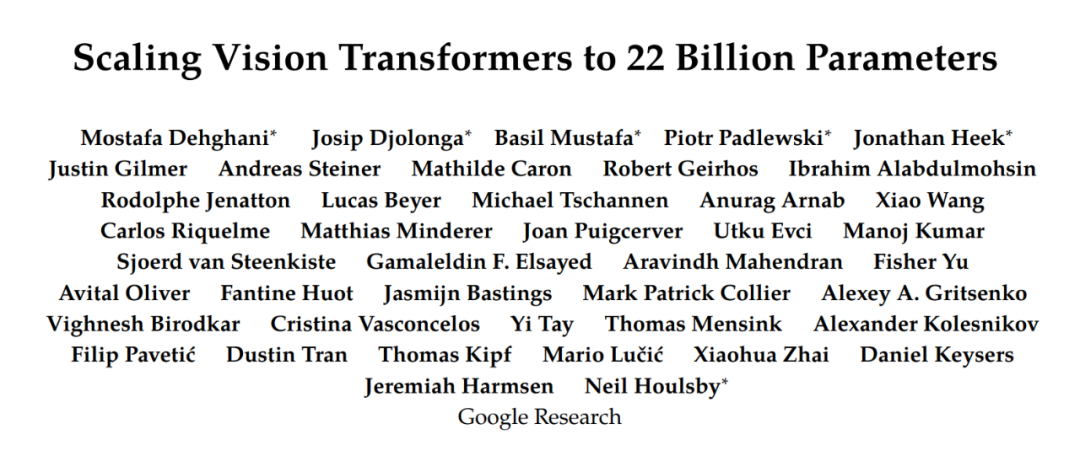

ChatGPT爆火之后,视觉研究者坐不住了?谷歌将ViT参数扩大到220亿

视觉模型有很大的提升空间,研究者们在以往的 LLM 中学到经验教训,认为扩展是一个很有前途的方法。来自谷歌的研究者将 ViT 扩展到 22B 参数量,这是迄今为止报道的最大的视觉主干。与自然语言处理类似,对预训练视觉主干的迁移提高了模型在各种视觉任务上的性能。更大的数据集、可扩展的架构和新的训练方法都推动了模型性能的提升。然而,视觉模型仍然远远落后于语言模型。具体来说,迄今为止最大的视觉模型 V....

从BERT到ChatGPT,北航等9大顶尖研究机构全面综述:那些年一起追过的「预训练基础模型」

新智元报道 编辑:LRS【新智元导读】2023年了,还有人从头开始训模型吗?追踪一下从Bert以来的那些预训练模型。ChatGPT在few-shot和zero-shot场景下展现出的惊人性能,让研究人员们更坚定「预训练」是一条正确的路线。 预训练基础模型(Pretrained Foundation Models, PFM)被认为是不同数据模式下各种下游任务的基础....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

ChatGPT研究相关内容

ChatGPT您可能感兴趣

- ChatGPT技能

- ChatGPT ai

- ChatGPT sora

- ChatGPT appstore

- ChatGPT谷歌

- ChatGPT搜索功能

- ChatGPT修复

- ChatGPT宕机

- ChatGPT api

- ChatGPT漏洞

- ChatGPT提问

- ChatGPT大模型

- ChatGPT测试

- ChatGPT工程

- ChatGPT面试

- ChatGPT开发

- ChatGPT数据分析

- ChatGPT分析

- ChatGPT python

- ChatGPT软件测试

- ChatGPT架构

- ChatGPT方法

- ChatGPT功能

- ChatGPT产品

- ChatGPT编程

- ChatGPT能力

- ChatGPT用法

- ChatGPT文件

- ChatGPT团队

- ChatGPT网络