揭示Transformer周期建模缺陷!北大提出新型神经网络FAN,填补周期性特征建模能力缺陷

在人工智能和机器学习领域,神经网络模型的发展日新月异。其中,Transformer模型因其在自然语言处理等领域的卓越表现而备受瞩目。然而,近期来自北京大学的研究团队发现,包括Transformer在内的一些主流神经网络模型在周期特征建模方面存在缺陷。 周期特征是自然界和工程系统中普遍存在的现象,如季节变化、股票市场波动等。在机...

RT-DETR改进策略【Conv和Transformer】| TPAMI-2024 Conv2Former 利用卷积调制操作和大核卷积简化自注意力机制,提高网络性能

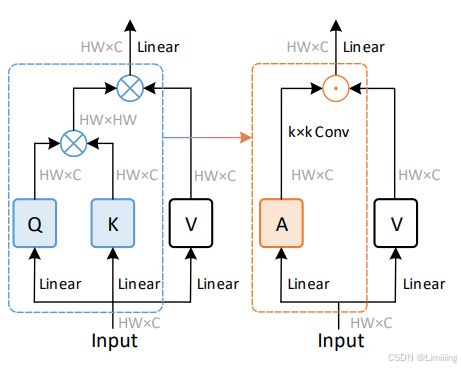

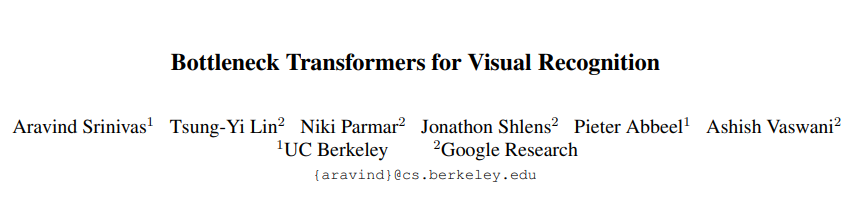

一、本文介绍 本文记录的是利用Conv2Former优化RT-DETR的目标检测网络模型。Transformer通过自注意力机制能够获取全局信息,但资源占用较大。卷积操作资源占用较少,但只能根据卷积核的大小获取局部信息。Conv2Former==通过卷积调制操作简化了自注意力机制,更有效地利用了大核卷积,在视觉识别任务中表现出较好的性能。== 专栏目录:RT-DETR改进目录一览 | 涉及卷积.....

YOLOv11改进策略【Conv和Transformer】| TPAMI-2024 Conv2Former 利用卷积调制操作和大核卷积简化自注意力机制,提高网络性能

一、本文介绍 本文记录的是利用Conv2Former优化YOLOv11的目标检测网络模型。Transformer通过自注意力机制能够获取全局信息,但资源占用较大。卷积操作资源占用较少,但只能根据卷积核的大小获取局部信息。Conv2Former==通过卷积调制操作简化了自注意力机制,更有效地利用了大核卷积,在视觉识别任务中表现出较好的性能。== 专栏目录:YOLOv11改进目录一览 | 涉及卷积.....

揭示Transformer重要缺陷!北大提出傅里叶分析神经网络FAN,填补周期性特征建模缺陷

近年来,神经网络的发展日新月异,尤其是以MLP(多层感知器)和Transformer为代表的模型,在各种任务中取得了显著的成功。然而,这些模型在处理周期性特征时却暴露出潜在的缺陷。它们往往倾向于记忆周期性数据,而不是真正理解其背后的原理。 周期性是自然界和工程系统中普遍存在的重要特性,...

【深度学习+面经】Transformer 网络学习笔记

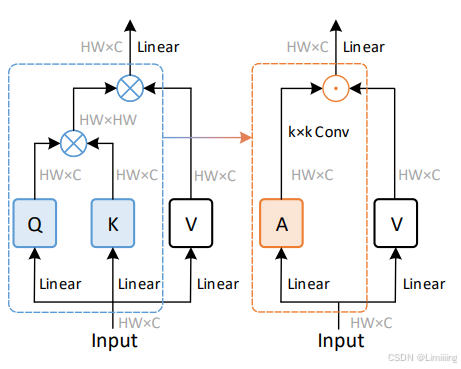

1 引言 Transformer中抛弃了传统的CNN和RNN,整个网络结构完全是由Attention机制组成。更准确地讲,Transformer主要由多头self-Attenion和Feed Forward Neural Network组成。一个基于Transformer的可训练的神经网络可以通过堆叠Transformer的形式进行搭建,作者的实验是通过搭建编码器和解码器各6层,总共12层...

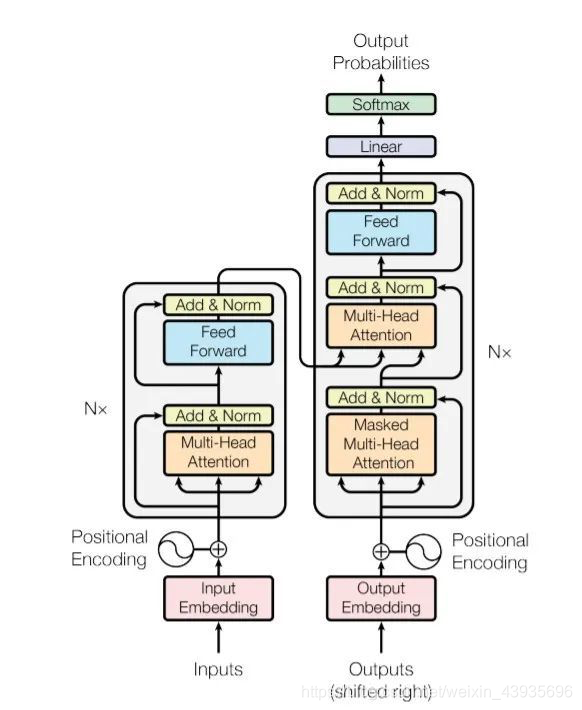

【YOLOv8改进- Backbone主干】BoTNet:基于Transformer,结合自注意力机制和卷积神经网络的骨干网络

YOLOv8目标检测创新改进与实战案例专栏 专栏目录: YOLOv8有效改进系列及项目实战目录 包含卷积,主干 注意力,检测头等创新机制 以及 各种目标检测分割项目实战案例 专栏链接: YOLOv8基础解析+创新改进+实战案例 介绍 摘要 我们提出了BoTNet,这是一种概念上简单但功能强大的骨干架构,结合了自注意力机制,用于图像分类、目标检测和实例分割等多个计算机视...

Transformer 能代替图神经网络吗?

当Transformer模型发布时,它彻底革新了机器翻译领域。虽然最初是为特定任务设计的,但这种革命性的架构显示出它可以轻松适应不同的任务。随后成为了Transformer一个标准,甚至用于它最初设计之外的数据(如图像和其他序列数据)。 然后人们也开始优化和寻找替代方案,主要是为了减少计算成本(自注意力机制的二次方成本)。关于哪种架构在计算成本方面更优的讨论一直在进行,但是对于Transfor.....

Transformer:Attention机制、前馈神经网络、编码器与解码器

Transformer中的Attention机制 一、引言 在自然语言处理领域,Transformer模型已经成为了主流的深度学习架构。凭借其强大的处理能力和高效的性能,Transformer在许多NLP任务中都取得了显著的成果。而在Transformer模型中,Attention机制起到了至关重要的作用。 二、Transformer中的Attention机制 1...

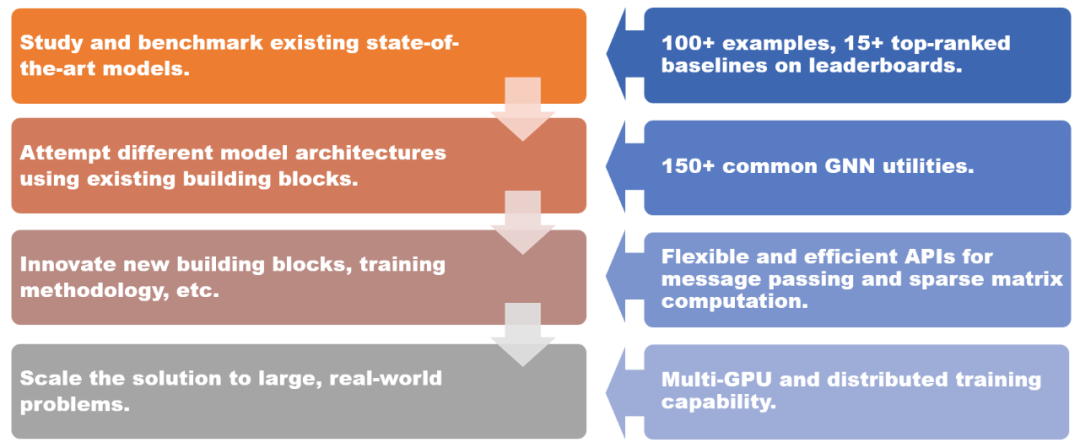

10行代码搞定图Transformer,图神经网络框架DGL迎来1.0版本

让所有人都能快速使用图机器学习。2019 年,纽约大学、亚马逊云科技联手推出图神经网络框架 DGL (Deep Graph Library)。如今 DGL 1.0 正式发布!DGL 1.0 总结了过去三年学术界或工业界对图深度学习和图神经网络(GNN)技术的各类需求。从最先进模型的学术研究到将 GNN 扩展到工业级应用,DGL 1.0 为所有用户提供全面且易用的解决方案,以更好的利用图机器学习的....

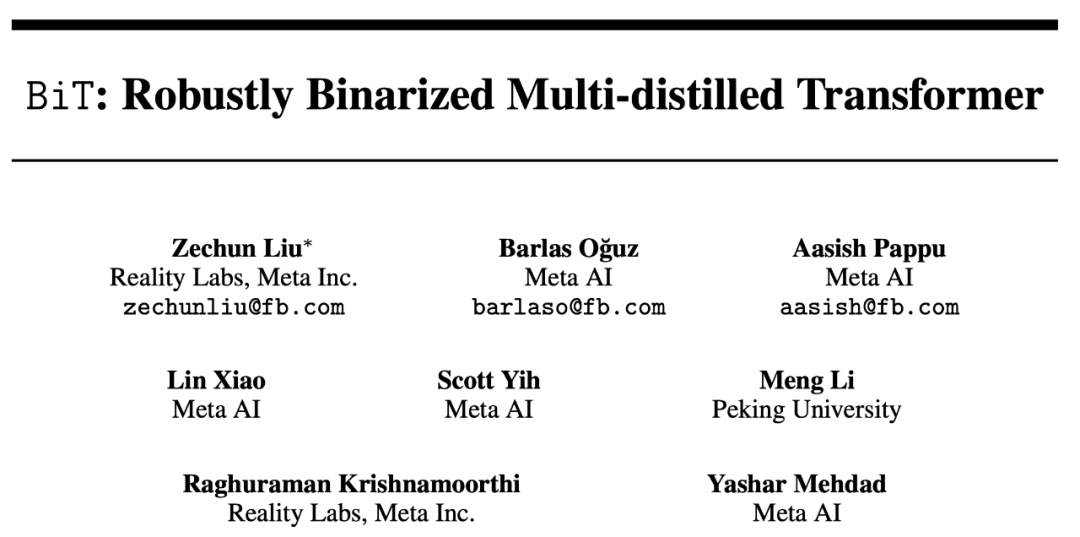

NeurIPS 2022 | Meta 提出二值transformer网络BiT,刷新NLP网络压缩极限

神经网络压缩一直被视为机器学习模型从实验室走向工业应用中的不可或缺的一步,而量化 (quantization) 又是神经网络压缩中最常用的方法之一。今天这篇 NeurIPS 论文 BiT 从实验和理论验证了极端压缩情况下的 1-bit 的 BERT 网络也能在自然语言处理的分类数据集 GLUE 上取得接近全精度网络的结果,将与全精度网络差距从之前方法的 16% 缩小到了仅 6%,被审稿人称赞是一....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

域名解析DNS

关注DNS行业趋势、技术、标准、产品和最佳实践,连接国内外相关技术社群信息,追踪业内DNS产品动态,加强信息共享,欢迎大家关注、推荐和投稿。

+关注