Dataflow集群如何连接DLF,并读取Hudi全量数据

DataFlow集群可以通过数据湖构建(DLF)的统一元数据服务,访问DataLake集群或自定义集群中的Hudi表数据。本文为您介绍DataFlow集群如何连接DLF并读取Hudi全量数据。

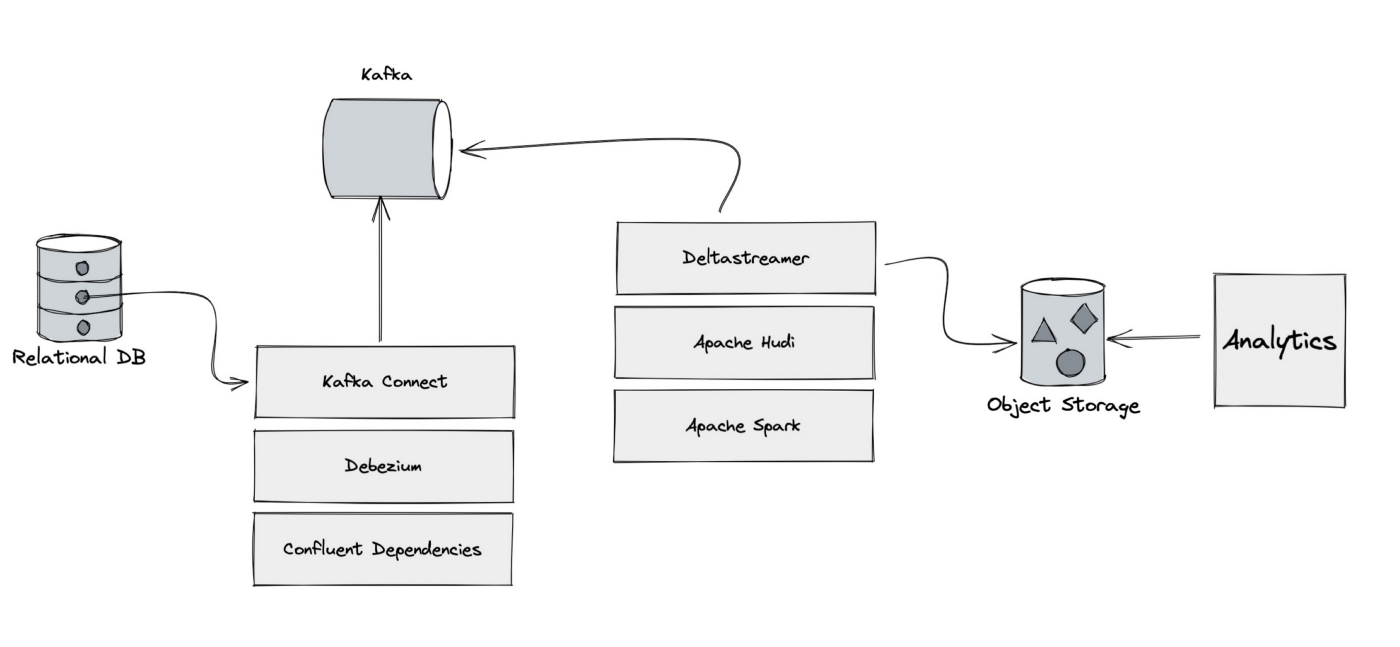

基于Apache Hudi在Google云构建数据湖平台

自从计算机出现以来,我们一直在尝试寻找计算机存储一些信息的方法,存储在计算机上的信息(也称为数据)有多种形式,数据变得如此重要,以至于信息现在已成为触手可及的商品。多年来数据以多种方式存储在计算机中,包括数据库、blob存储和其他方法,为了进行有效的业务分析,必须对现代应用程序创建的数据进行处理和分析,并且产生的数据量非常巨大!有效地存储数PB数据并拥有必要的工具来查询它以便使用它至关重要,只有....

Apache Hudi 0.9.0版本重磅发布!更强大的流式数据湖平台

1. 重点特性1.1 Spark SQL支持0.9.0 添加了对使用 Spark SQL 的 DDL/DML 的支持,朝着使所有角色(非工程师、分析师等)更容易访问和操作 Hudi 迈出了一大步。 用户现在可以使用 CREATE TABLE....USING HUDI 和 CREATE TABLE .. AS SELECT 语句直接在 Hive 等目录中创建和管理表。 然后用户可以使用 INSE....

使用 Flink Hudi 构建流式数据湖平台

摘要:本文整理自阿里巴巴技术专家陈玉兆 (玉兆)、阿里巴巴开发工程师刘大龙 (风离) 在 Flink Forward Asia 2021 的分享。主要内容包括:Apache Hudi 101Flink Hudi IntegrationFlink Hudi Use CaseApache Hudi RoadmapFFA 2021 直播回放 & 演讲 PDF 下载一、Apache Hudi 1....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。