即插即用 | CNN与Transformer都通用的Trick,即插即涨点即提速!(二)

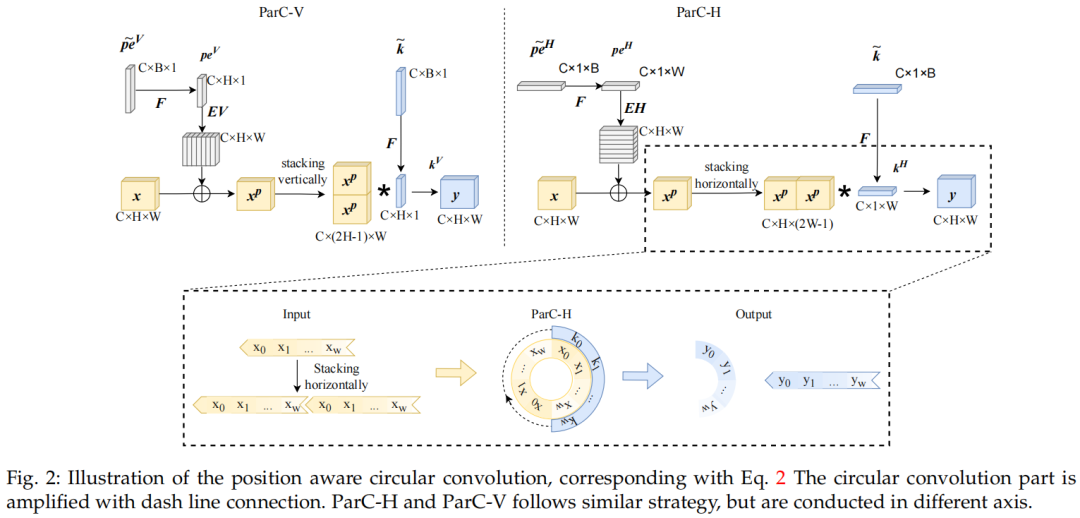

3、本文方法3.1、ParC Operation1、Vanilla Depth-wise Convolution为了描述在B×C×H×W形状的4D输入张量上以水平维进行的一维深度卷积(称为Conv1d-H),可以首先关注一个特定的通道。将输出表示为 ,输入为,卷积权重为 。然后,带零填充的Pytorch型卷积(即F.conv1d)可以表示为:其中,用于抵消输入两侧标量的额外填充。等式1中,是其局....

即插即用 | CNN与Transformer都通用的Trick,即插即涨点即提速!(一)

近年来,Transformer模型在各个领域都取得了巨大的进展。在计算机视觉领域,视觉Transformer(ViTs)也成为卷积神经网络(ConvNets)的有力替代品,但它们还无法取代ConvNet,因为两者都有各自的优点。例如,ViT善于利用注意力机制提取全局特征,而ConvNets由于其强烈的归纳偏差,在建模局部关系时更有效。一个自然的想法是结合ConvNets和ViT的优势来设计新的结....

即插即用 | CNN与Transformer都通用的Trick,即插即涨点即提速!

近年来,Transformer模型在各个领域都取得了巨大的进展。在计算机视觉领域,视觉Transformer(ViTs)也成为卷积神经网络(ConvNets)的有力替代品,但它们还无法取代ConvNet,因为两者都有各自的优点。例如,ViT善于利用注意力机制提取全局特征,而ConvNets由于其强烈的归纳偏差,在建模局部关系时更有效。一个自然的想法是结合ConvNets和ViT的优势来设计新的结....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。