机器学习入门:梯度下降算法(下)

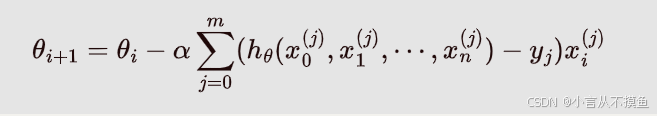

学习目标 了解全梯度下降,随机梯度下降,小批量梯度下降,随机平均梯度下降的原理 全梯度下降算法(FGD) 全梯度下降算法(FGD)-----每次迭代时, 使用全部样本的梯度值 批量梯度下降法,是梯度下降法最常用的形式,具体做法也就是在更新参数时使用所有的样本来进行更新。 计算训练集所有样本误差,对其求和再取平均值作为目标函数。 权重向量沿其梯度...

机器学习入门:梯度下降算法(上)

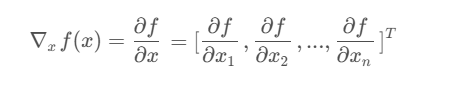

学习目标 掌握梯度下降算法的原理 掌握梯度下降法优化损失函数的原理 梯度下降(Gradient Descent) 1.1 什么是梯度下降 梯度下降法的基本思想可以类比为一个下山的过程。 假设这样一个场景: 一个人 被困在山上,需要从山上下来 (i.e. 找到山的最低点,也就是山谷)。但此时山上的浓雾很大,导致可视度很低。 因此...

探索机器学习中的梯度下降优化算法

机器学习领域充满了各种令人着迷的概念和算法,其中,梯度下降法无疑是最基础且广泛应用的技术之一。它是一种迭代优化算法,用于找到函数的局部最小值,这在机器学习中通常意味着损失函数的最小化。 梯度下降法的核心思想是利用函数在某点的梯度(导数)来决定下一步移动的方向。想象一下,你站在山顶,想要...

梯度下降算法(二)

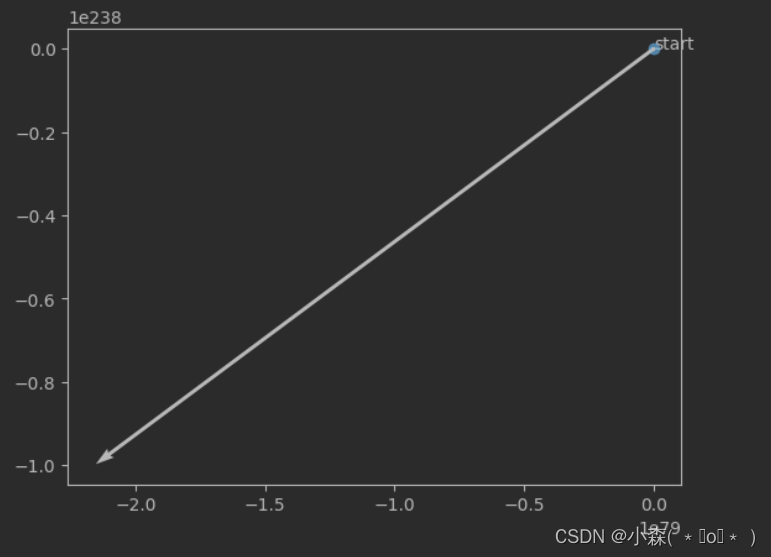

梯度下降算法(一)+https://developer.aliyun.com/article/1544680?spm=a2c6h.13148508.setting.28.2a1e4f0euIPhgb 如果学习率调整为0.3,那么将找不到最低点,还会产生震荡** ...

梯度下降算法(一)

梯度下降算法 1.1 什么是梯度下降 在线性回归中,我们使用最小二乘法,能够直接计算损失函数最小值时的参数值,但是,最小二乘法有使用的限制条件,在大多数机器学习的使用场景之下,我们会选择梯度下降的方法来计算损失函数的极小值,首先梯度下降算法的目标仍然是求最小值,但和最小二乘法这种一步到位、通过解方程组直接求得最小值的方式不同,梯度下降是通过一种“迭代求解”的...

《PyTorch深度学习实践》--3梯度下降算法

一、.在第二节中的线性模型中,求解w的最优值(使得MSE最小的w)问题。 从图中可以看出:w=2时,MSE最小。(即最优) 二、求解最优w问题的方法 2.1梯度下降(Gradient Descent)算法: ...

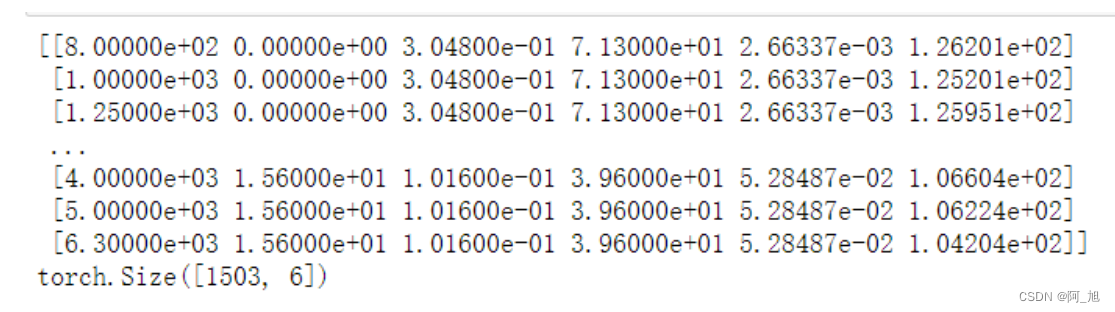

【从零开始学习深度学习】38. Pytorch实战案例:梯度下降、随机梯度下降、小批量随机梯度下降3种优化算法对比【含数据集与源码】

1. 梯度下降、随机梯度下降、小批量随机梯度下降区别 梯度下降:在每一次迭代中,梯度下降使用整个训练数据集来计算梯度,一个epoch周期内参数只更新一次。 随机梯度下降:在每次迭代中,只随机采样一个样本来计算梯度,一个epoch周期内会进行样本数目次参数更新。 小批量随机梯度下降:在每次迭代中随机均匀采样多个样本来组成一个小批量来计算梯度,一个epoch周期内会进行(样本...

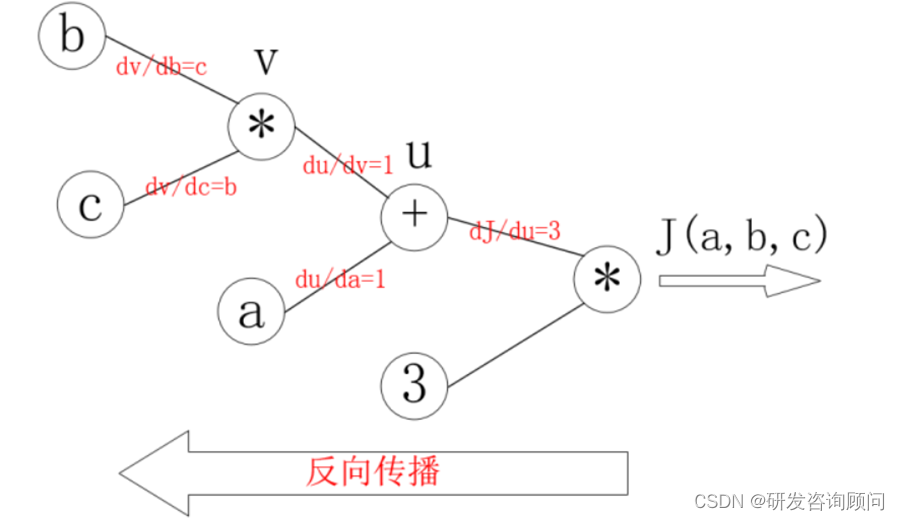

反向传播原理的梯度下降算法

1. 反向传播原理的梯度下降算法 1.1 反向传播原理介绍 在深度学习中,反向传播算法是一种用于训练神经网络的技术。它通过计算损失函数对每个参数的梯度,然后沿着梯度的反方向更新参数,以最小化损失函数。这一过程可以被分解为两个阶段:前向传播和反向传播。 在前向传播阶段,输入数据通过神经网络的各个层,经过一系列的线性变换和激活函数,最终得到输出。在这个过程中,每一层都会保存一...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

智能搜索推荐

智能推荐(Artificial Intelligence Recommendation,简称AIRec)基于阿里巴巴大数据和人工智能技术,以及在电商、内容、直播、社交等领域的业务沉淀,为企业开发者提供场景化推荐服务、全链路推荐系统开发平台、工程引擎组件库等多种形式服务,助力在线业务增长。

+关注