问odps同步polardb的数据,可以像sqoop抽取mysql数据到hive一样从上一次同步的自

问odps同步polardb的数据,可以像sqoop抽取mysql数据到hive一样从上一次同步的自增id开始同步吗

问下mysql-cdc到hive能实现无界流吗 我用mysql-cdc 建的表insert到hive

问下mysql-cdc到hive能实现无界流吗 我用mysql-cdc 建的表insert到hive 最后效果是批处理 flink任务显示finished

用flink cdc 实现mysql到hive数据同步有没demo?能实现自动加字段吗

用flink cdc 实现mysql到hive数据同步有没demo?能实现自动加字段吗

大佬们,flink sql client实现 mysql表实时同步到hive,除了中间转kafka再

大佬们,flink sql client实现 mysql表实时同步到hive,除了中间转kafka再写hive,有没有别的方式,能一步到位。

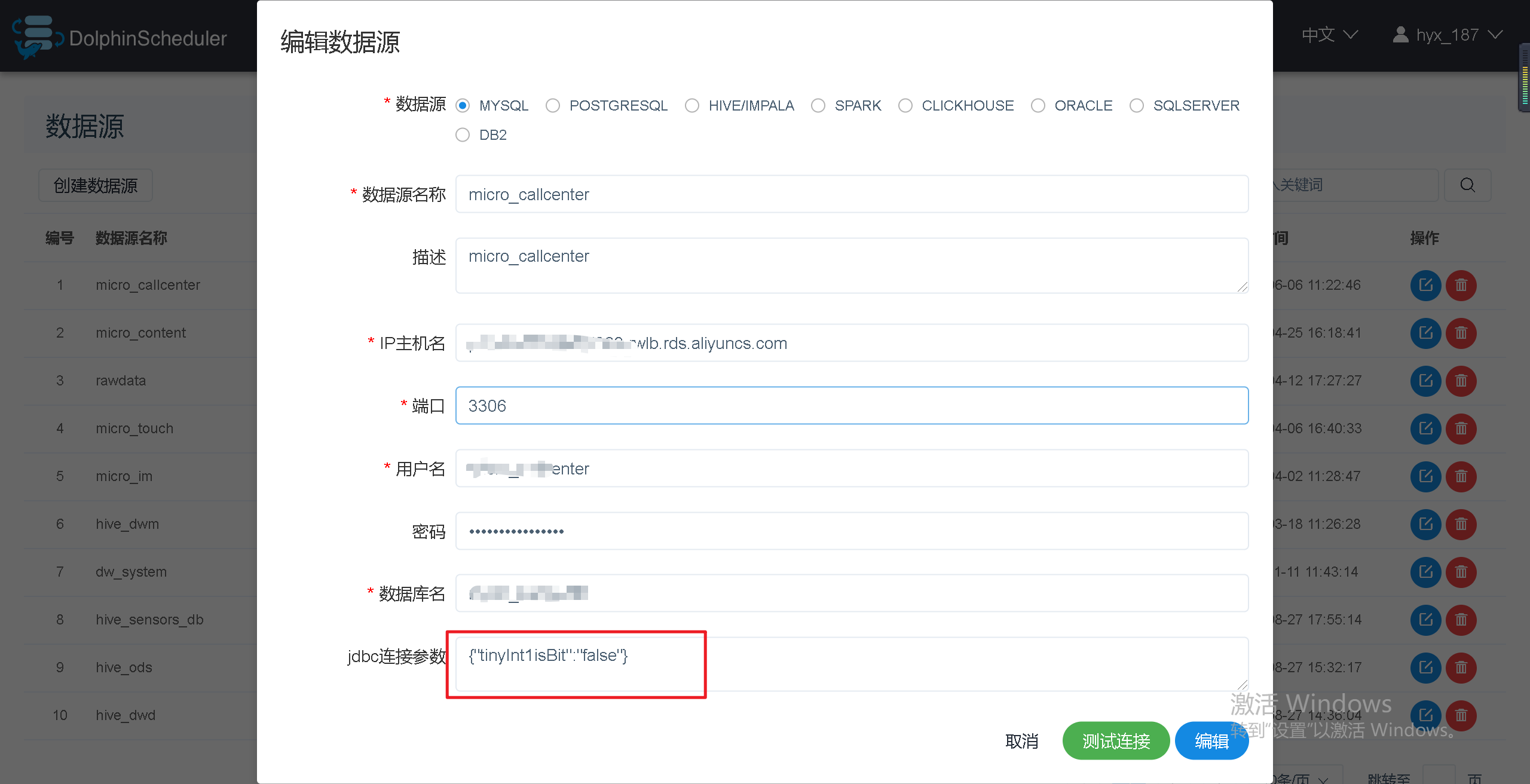

巨坑:Sqoop任务中从MySQL导入tinyint(1)类型数据到hive(tinyint),数据为null

问题描述从Sqoop导入MySQL导入TINYINT(1)类型数据到hive(tinyint),数据为null。问题原因Sqoop在抽取数据到Hive或者HDFS时,会自动将类型为tinyint(1)的列转为boolean类型,这就是导致抽取到Hive或HDFS中的数据中只有0和1的原因。因为默认情况下,MySQL JDBC connector 会将tinyint(1)映射为java.sql.T....

有大佬用过cdc 从mysql到hive表嘛,会报Connector 'mysql-cdc' can

有大佬用过cdc 从mysql到hive表嘛,会报Connector 'mysql-cdc' can only be used as a source. It cannot be used as a sink,但是我的cdc表就是source表呀,sink是hive表。怎么办?

flink-sql 通过jdbc读取mysql 然后写出到Hive中,数据查不到,但是数据已经写入到

flink-sql 通过jdbc读取mysql 然后写出到Hive中,数据查不到,但是数据已经写入到Hdfs了但是是个隐藏文件,怎么才能使Hive数据?

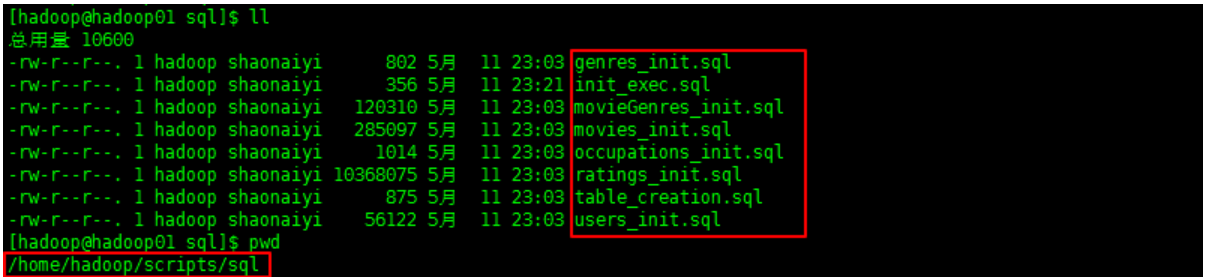

使用Sqoop导出Mysql数据到Hive(实战案例)

0x00 教程内容SQL文件准备导出Mysql数据到Hive前提:安装好了Hive安装好了Sqoop0x01 SQL文件准备1. 准备sql脚本a. 准备建表与添加数据sql文件2. 执行sql脚本source /home/hadoop/scripts/sql/init_exec.sqlPS:文件多的话,可能执行起来会有点慢。0x02 导出Mysql数据到Hive1. 导出数据到HDFSa. 将....

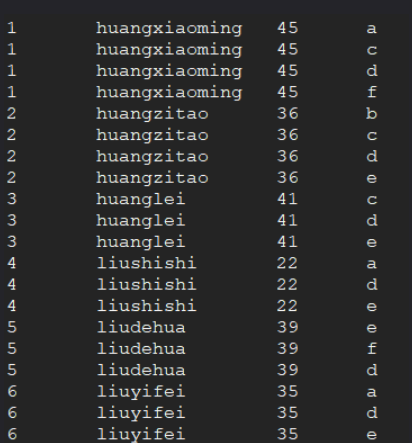

对比mysql和hive:分组,取不同组前几条记录-explode函数的使用

1、数据源如下id,name,age,favors(爱好) 1,huangxiaoming,45,a-c-d-f 2,huangzitao,36,b-c-d-e 3,huanglei,41,c-d-e 4,liushishi,22,a-d-e 5,liudehua,39,e-f-d 6,liuyifei,35,a-d-e2、建表语句create table mian6( id int, ...

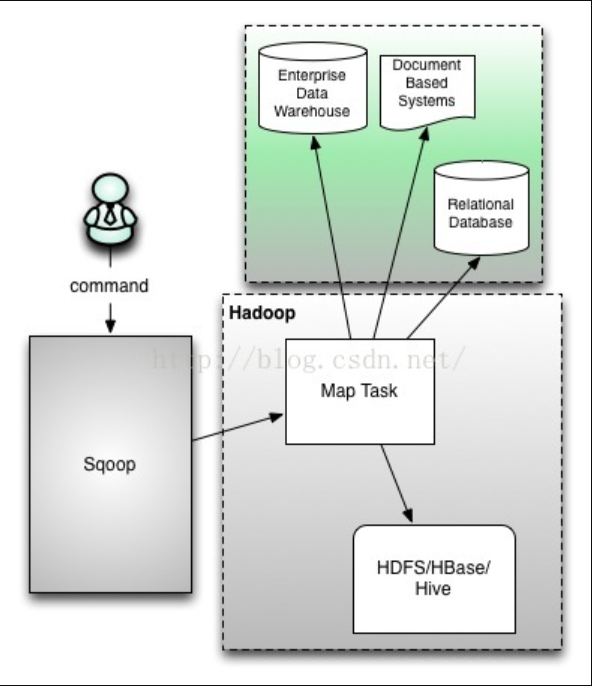

sqoop用法之mysql与hive数据导入导出

一. Sqoop介绍Sqoop是一个用来将Hadoop和关系型数据库中的数据相互转移的工具,可以将一个关系型数据库(例如:MySQL、Oracle、Postgres等)中的数据导进到Hadoop的HDFS中,也可以将HDFS的数据导进到关系型数据库中。对于某些NoSQL数据库它也提供了连接器。Sqoop,类似于其他ETL工具,使用元数据模型来判断数据类型并在数据从数据源转移到Hadoop时确保类....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。