详解PyTorch编译并调用自定义CUDA算子的三种方式

在上一篇教程中,我们实现了一个自定义的CUDA算子add2,用来实现两个Tensor的相加。然后用PyTorch调用这个算子,分析对比了一下和PyTorch原生加法的速度差异,并且详细解释了线程同步给统计时间带来的影响。「上一篇教程:」https://godweiyang.com/2021/03/18/torch-cpp-cuda本篇教程我们主要讲解如何「编译并调用」之前我们写好的CUDA算子,....

PyTorch自定义CUDA算子教程与运行时间分析

最近因为工作需要,学习了一波CUDA。这里简单记录一下PyTorch自定义CUDA算子的方法,写了一个非常简单的example,再介绍一下正确的PyTorch中CUDA运行时间分析方法。所有的代码都放在了github上,地址是:https://github.com/godweiyang/torch-cuda-example完整流程下面我们就来详细了解一下PyTorch是如何调用自定义的CUDA算....

PyTorch自定义CUDA算子教程与运行时间分析(二)

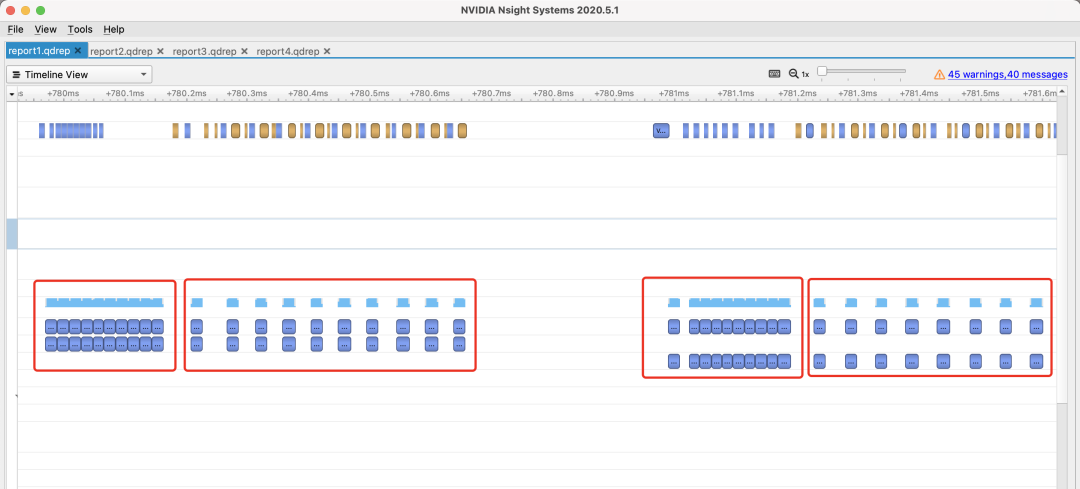

两次同步这是正确的统计时间的方法,我们打开Nsight Systems,放大kernel运行那一段可以看到下图:其中第1和第3个框分别是cuda和torch的GPU warm up过程,这部分没有进行线程同步(上面的黄色块)。而第2和第4个框就分别是cuda和torch的加法执行过程了,我们可以放大来看看。可以看出,每执行一次(一个框)都经过了三个步骤:先是调用api(左上角蓝色框),然后执行k....

PyTorch自定义CUDA算子教程与运行时间分析(一)

最近因为工作需要,学习了一波CUDA。这里简单记录一下PyTorch自定义CUDA算子的方法,写了一个非常简单的example,再介绍一下正确的PyTorch中CUDA运行时间分析方法。所有的代码都放在了github上,地址是:https://github.com/godweiyang/torch-cuda-example完整流程下面我们就来详细了解一下PyTorch是如何调用自定义的CUDA算....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

pytorch您可能感兴趣

- pytorch安装

- pytorch环境

- pytorch策略

- pytorch内存

- pytorch资源

- pytorch架构

- pytorch模型

- pytorch构建

- pytorch deepseek-v2

- pytorch keras

- pytorch神经网络

- pytorch教程

- pytorch实战

- pytorch训练

- pytorch学习

- pytorch数据集

- pytorch tensorflow

- pytorch官方教程

- pytorch代码

- pytorch卷积

- pytorch gpu

- pytorch卷积神经网络

- pytorch数据

- pytorch源码

- pytorch分类

- pytorch框架

- pytorch案例

- pytorch学习笔记

- pytorch版本

- pytorch张量